1.人工知能はサイズを大きくすると今までできなかった事が突然できるようになる(2/2)まとめ

・創発的なプロンプトは小さなモデルで失敗し十分に大きなモデルで成功する

・思考連鎖のプロンプトは創発的であり小さいモデルでは標準プロンプトに劣る

・創発的能力がモデル規模と関連があるならば未知の能力があるかもしれない

2.創発的なプロンプトとは?

以下、ai.googleblog.comより「Characterizing Emergent Phenomena in Large Language Models」の意訳です。元記事の投稿は2022年11月10日、Jason WeiさんとYi Tayさんによる投稿です。

謝辞の部分を読んでいて改めて思ったのですがこの研究、T5のColin RaffelやGoogle AIのトップのJeff Deanの名前が入っています。

改めて調べてみるとJeff Deanの名前って、LaMDA、GLaM、PaLM、などの非常に膨大な予算を必要としたであろう大規模言語モデル系の研究で出てきますが、そう考えると、やっぱり、この研究の注目度はGoogle AI内でかなり高く、公開されていない情報もあるのではないかとアヤシイ感じがしてきちゃいますね。

ちなみに情報公開がされていない理由はAI開発に関するGoogleの原則の第一条「社会的に有益であるか?」や第三条「安全第一で作成し、試験する」などに懸念があるためではないかと思っています。LaMDAレベルのチャットボットが一般公開可能になった際の社会的インパクト、例えばサポートセンター系の職種はほぼ代替されちゃうでしょうから計測が難しくSFチックですが「人類にはまだ早すぎる」のかもしれません。

アイキャッチ画像はstable diffusionの1.5版の生成

創発的プロンプティング戦略

第2の能力は、言語モデルの能力を向上させるプロンプティング戦略(prompting strategies)です。プロンプティング戦略は、さまざまなタスクに適用できるプロンプティングの広範なパラダイムです。小さなモデルで失敗し、十分に大きなモデルでなければ使用できない場合、それらは創発的なプロンプトであるとみなされます。

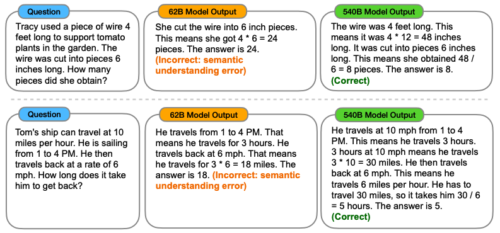

創発的プロンプトの一例は「思考連鎖のプロンプト(chain-of-thought prompting)」と呼ばれるもので、最終的な答えを出す前に、一連の中間ステップを生成するようモデルに促すものです。

思考の連鎖プロンプトにより、言語モデルは複数回の計算手順を踏む必要がある数学の文章問題など、複雑な推論を必要とするタスクを実行することができます。注目すべきは、モデルは明示的に訓練されなくとも、思考の連鎖を用いた推論を行う能力を獲得することです。下図に思考連鎖型プロンプトの例を示します。

思考の連鎖プロンプトにより、十分に大きなモデルであれば多段階の推論問題を解くことができます。

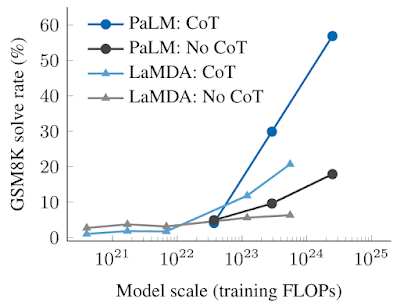

思考の連鎖プロンプトの実証結果を以下に示します。小さいモデルでは、思考の連鎖プロンプトを適用しても、例えば数学の文章問題の難易度の高いベンチマークであるGSM8Kに適用した場合、小さいモデルでは標準的なプロンプトを上回りません。しかし、大規模なモデル(1024FLOPs)では、思考の連鎖プロンプトは私達のテストで大幅に性能を向上させ、GSM8Kで57%の解答率に達しました。

思考の連鎖プロンプトは、小さな言語モデルでは性能を向上させることができませんが、大きなモデルでは大幅に性能を向上させることができるという、創発的な能力です。この図では、LaMDAとPaLMという2つの言語モデルについて、異なる規模での標準的なプロンプトと思考の連鎖プロンプトの違いを説明しています。

創発的な能力の意味するもの

創発的な能力の存在は、様々な意味を持ちます。例えば、少数回プロンプトの能力・戦略は事前学習で明示的にコード化されていないため、研究者は現在の言語モデルが持つ少数回プロンプト能力の全容を知らない可能性があります。さらに、モデル規模の関数として新しい能力が出現していることから、さらに大規模なモデルに新しい能力が付与される可能性があるのではないかという疑問が生じます。

大規模な言語モデルにおける創発的な能力を特定することは、そのような現象と将来のモデル能力への潜在的な影響を理解するための最初のステップとなります。

なぜモデル規模の拡大が創発的能力を解放するのでしょうか?

計算機資源は高価であるため、規模を拡大させることなく、他の方法(例えば、より優れたモデルアーキテクチャや学習技術)で創発的能力を解放することは出来るのでしょうか?

特定の能力が創発したら現実世界での言語モデルの新しいアプリケーションを実現可能になるのでしょうか?

モデルの規模拡大によって生じる創発的な振る舞いを含む言語モデルの振る舞いを分析し理解することは、自然言語処理(NLP:Natural Language Processing)の分野が成長し続ける中で重要な研究課題となっています。

謝辞

Rishi Bommasani, Colin Raffel, Barret Zoph, Sebastian Borgeaud, Dani Yogatama, Maarten Bosma, Denny Zhou, Donald Metzler, Ed H. Chi, Tatsunori Hashimoto, Oriol Vinyals, Percy Liang, Jeff Dean そして William Fedusと仕事ができたのは名誉であり特権でした。

3.人工知能はサイズを大きくすると今までできなかった事が突然できるようになる(2/2)関連リンク

1)ai.googleblog.com

Characterizing Emergent Phenomena in Large Language Models

2)openreview.net

Emergent Abilities of Large Language Models