学習手法

学習手法 Scaled Q-learning:強化学習も大規模言語モデルみたいに事前学習をしたいです(2/2)

1.Scaled Q-learning:強化学習も大規模言語モデルみたいに事前学習をしたいです(2/2)まとめ ・Scaled Q-Learningは強化学習であるにも関わらず規模を拡大する事が有利になるべき乗スケーリング特性を持っている ...

学習手法

学習手法  学習手法

学習手法  AI関連その他

AI関連その他  モデル

モデル  学習手法

学習手法  学習手法

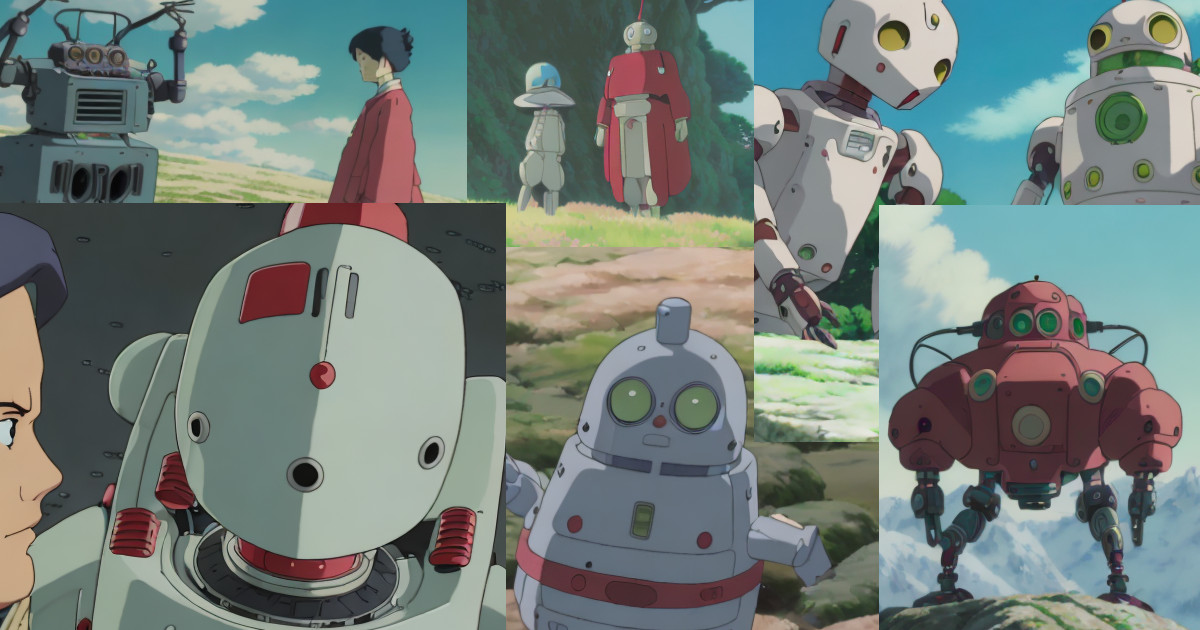

学習手法  ロボット

ロボット  ロボット

ロボット  学習手法

学習手法  学習手法

学習手法  ロボット

ロボット  モデル

モデル