1.MGDT:41種のゲームを人間同等にプレイ可能なTransformer(1/2)まとめ

・現在の強化学習は様々な個別タスクの意思決定に秀でるが汎用性に関する研究は少ない

・自然言語、視覚、生成モデルの分野ではTransformerが活躍しているが強化学習ではどうか?

・Multi-Game Decision Transformersは多数のゲームをプレイ可能な汎用エージェント

2.Multi-Game Decision Transformerとは?

以下、ai.googleblog.comより「Training Generalist Agents with Multi-Game Decision Transformers」の意訳です。元記事は2022年7月21日、Winnie XuさんとKuang-Huei Leeさんによる投稿です。

当初は自然言語のブレークスルーとして注目を集めたTransformerは最近は(畳み込みに比べると重いにも関わらず)画像にも当然のように使われるようになってきていますが、遂にはゲームのプレイにも使用されるようになるとは!

アイキャッチ画像のクレジットはPhoto by Giorgio Trovato on Unsplash

現在の深層強化学習(RL:deep Reinforcement Learning)手法は、囲碁やスタークラフトなど、特定の環境における様々な個別タスクの意思決定に秀でた専門的な人工エージェントを訓練することができます。しかし、これらの成果を、多くの異なるタスクを実行できるだけでなく、潜在的に異なる実施形態を持つ様々な環境にも対応できる汎用のエージェントに拡張することはほとんど行われていません。

自然言語処理、視覚、生成モデル(PaLM、Imagen、Flamingoなど)の分野での最近の進歩を見ると、汎用的なモデルを作るためのブレークスルーは、しばしばTransformerベースのモデルをスケールアップして、大規模で意味的に多様なデータセットで学習することによって達成されていることがわかります。

逐次的な意思決定のための汎用的なエージェントを構築する際に、同様の戦略を用いることができないだろうか?と考えるのは自然なことです。このようなモデルは、PaLMやFlamingoのように、新しいタスクに素早く適応することができるのでしょうか?

これらの疑問に答える第一歩として、最近の論文「Multi-Game Decision Transformers」では、多くのビデオゲームを同時にプレイ可能な汎用エージェントを構築する方法を探っています。

私達のモデルは、人間に近い性能で41のアタリゲームを同時にプレイでき、さらに微調整によって新しいゲームに素早く適応できるエージェントを訓練するものです。このアプローチは、時間差(TD:Temporal Difference)学習や行動クローニング(BC:Behavioral Cloning)のような、複数ゲームエージェントを学習するための既存の数少ない代替手段を大幅に改善するものです。

マルチゲーム・デシジョントランスフォーマー(MGDT:Multi-Game Decision Transformer)は、あらゆる専門レベルにまたがるさまざまな軌道のトレーニングから、希望するレベルの能力で複数のゲームをプレイすることができます。

リターンを最適化するのではなく、最適化だけを求める

強化学習において、報酬とはタスクの完了に関連するインセンティブ信号のことであり、リターンとはエージェントとその周辺環境との相互作用の過程における累積報酬のことです。

従来の深層強化学習エージェント(DQN、SimPLe、Dreamerなど)は、最適なリターンを達成するために意思決定を最適化するように訓練されています。時間ステップごとに、エージェントは環境を観察し(過去に起こった相互作用も考慮するものもあります)、将来の相互作用においてより高いリターンの大きさを達成するためにどのような行動をとるべきかを決定します。

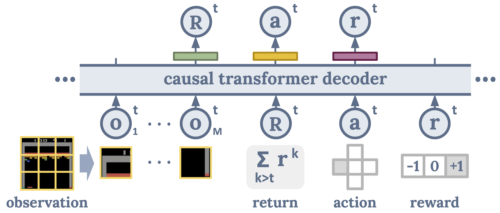

本研究では、RLエージェントを訓練するためのバックボーンアプローチとして、デシジョントランスフォーマー(Decision Transformer)を使用します。Decision Transformerは、エージェントと周辺環境との過去の相互作用と、(最も重要な)将来の相互作用で達成されるべき望ましいリターンを考慮し、将来の行動を予測するシーケンスモデルです。

従来の強化学習のように高いリターンを得るためのポリシーを学習するのではなく、訓練中にエキスパートレベルから初心者レベルまでの多様な経験とそれに対応する見返りの大きさを対応付けます。これは、エージェントを初心者からエキスパートレベルまでの様々な経験で訓練することで、ゲームプレイのバリエーションが広がり、その結果、どんな状況でも成功できるようなゲームプレイの有用なルールを抽出できるようになるという考え方です。そのため、推論時には、最適なリターンを含め、トレーニング中に見た範囲内の任意のリターン値を達成することができます。

しかし、あるリターンが与えられた環境において最適であり、かつ安定的に達成可能であるかどうかは、どのようにして知ることができるのでしょうか?これまでの Decision Transformers は、個々のタスクごとにカスタマイズしたリターンの定義に依存していました。

そのため、特定のゲームごとに適切に解釈できるシグナルである、もっともらしく有益なスカラー値の範囲を手動で定義する必要がありました。しかし、このような作業は自明ではなく、また拡張性もありません。

この問題を解決するために、私達は学習時の過去の環境との相互作用に基づくリターンの大きさの分布をモデル化します。推論時には、より高いリターンに関連する行動を生成する確率を増加させる最適化バイアスを追加するだけです。

エージェントと環境の相互作用の空間的・時間的パターンをより包括的に捉えるために、私達はまた、グローバルな画像特徴表現の代わりに画像に断片を考慮するようにDecision Transformersのアーキテクチャを修正しました。断片を見る事によって、モデルは局所的なダイナミクスに焦点を当てることができ、ゲーム固有の情報をより詳細にモデル化するのに役立ちます。

これらの要素を組み合わせることで、「マルチゲーム・デシジョントランスフォーマー」の骨格ができあがります。

各観測画像をM個の画素の断片に分割し、Oと表記します。リターンR、アクションa、報酬rはカジュアルシーケンスにおいてこれらの画像断片入力に続きます。Decision Transformersは(画像断片を除いた)次の入力を予測するように学習し、因果関係を確立します。

41ゲームを同時プレイするMulti-Game Decision Transformersの学習

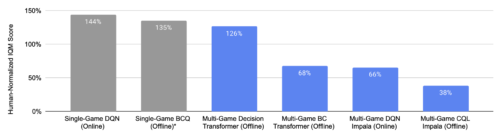

私達は、41のAtariゲームから得た大規模(〜10億)かつ広範なゲームプレイ経験セットを用いて、1つのMulti-Game Decision Transformerを訓練しました。私達の実験では、このエージェント(Multi-Game Decision Transformer(MGDT)と呼んでいます)は、41のゲームを同時にプレイする学習において、既存の強化学習や行動クローニング手法を約2倍上回り、人間レベルの能力(下図の100%は人間のゲームプレイレベルに相当)を発揮することが明らかになりました。この結果は、静的なデータセットから学習する場合(オフライン)と、環境との相互作用によって新しいデータを収集できる場合(オンライン)の両方において、学習手法を横断的に比較した場合にも当てはまります。

各バーは41ゲームのスコアを合計したもので、100%が人間レベルのパフォーマンスを示しています。青いバーは41のゲームを同時に学習したモデル、灰色のバーは41のスペシャリスト・エージェントのものです。マルチゲーム意思決定トランスフォーマーは、他のマルチゲームエージェントよりも大幅に優れた、人間レベルのパフォーマンスを達成し、スペシャリストエージェントにさえ匹敵します。

3.MGDT:41種のゲームを人間同等にプレイ可能なTransformer(1/2)関連リンク

1)ai.googleblog.com

Training Generalist Agents with Multi-Game Decision Transformers

2)arxiv.org

Multi-Game Decision Transformers

3)github.com

google-research/multi_game_dt/