1.MGDT:41種のゲームを人間同等にプレイ可能なTransformer(2/2)まとめ

・MGDTは様々な経験を学習した方が専門家レベルのデモのみを学習するより優れている

・他の学習システムと比較してモデルサイズの増加に伴う性能向上がより顕著の傾向

・MGDTはごく少数のゲームプレイのデモから新しいゲームのプレイを学習できる

2.MGDTの性能

以下、ai.googleblog.comより「Training Generalist Agents with Multi-Game Decision Transformers」の意訳です。元記事は2022年7月21日、Winnie XuさんとKuang-Huei Leeさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Giorgio Trovato on Unsplash

この結果は、デシジョントランスフォーマーが、マルチタスク、マルチ環境、マルチ実施形態のエージェントに適していることを示しています。

同時進行の研究であるdeepmind社の「A Generalist Agent」は同様の結果を示し、大規模なTransformerに基づくシーケンスモデルが、より多くの環境にわたって専門家の行動を非常によく記憶できることを実証しています。さらに、彼らの研究と私たちの研究は、うまく補完し合う結果を得ています。彼らは、アタリゲーム以外の幅広い環境で学習することが可能であることを示し、私達は、幅広い経験で学習することが可能かつ有用であることを示しました。

前述のパフォーマンスに加えて、経験的に、MGDTは、専門家レベルのデモンストレーションのみを学習したMDGTや、単にデモンストレーションの動作を模倣したMDGTよりも、様々な経験を学習した方が優れていることが分かりました。

マルチゲームモデルを規模拡大する事による性能向上

近年の機械学習におけるブレークスルーの主な原動力は、間違いなく規模を拡大する事であり、それは通常、Transformerベースのモデルのパラメータ数を増加させることで達成されます。

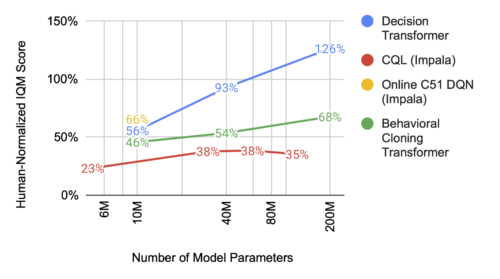

マルチゲーム・デシジョントランスフォーマーに関する私達の観察も同様で、モデルサイズが大きくなればなるほど、その性能は予測通りに向上します。特に、その性能はまだ天井に達していないようで、他の学習システムと比較すると、モデルサイズの増加に伴って性能向上がより顕著になっています。

マルチゲーム・デシジョントランスフォーマー(青線)は、モデルサイズが大きくなると予想通りパフォーマンスが向上しますが、他のモデルはそうではありません。

事前訓練済みMGDTは学習速度が速い

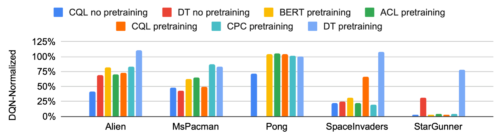

MGDTのもう一つの利点は、ごく少数のゲームプレイのデモンストレーションから、新しいゲームのプレイ方法を学習できることです。(デモの全てが専門家レベルである必要はありません)。その意味で、MGDTは、少量の新しいゲームプレイデータに対して迅速に微調整を行うことができる、事前学習済みモデルと考えることができます。MGDTは、他の一般的な事前学習手法と比較して、より高いスコアを得るための一貫した利点を明確に示しています。

マルチゲーム・デシジョントランスフォーマーの事前学習(DT pretrainingとして水色で表示)は、新しいタスクへの適応において、他の一般的なモデルよりも一貫した優位性を示しています。

エージェントはどこを見ているのでしょうか?

定量的な評価に加えて、エージェントの行動を視覚化することは、洞察に富み、楽しいことです。MGDTモデルのAttentionヘッドを調査したところ、観測された画像の中で、意味のあるゲームの実体を含む領域に一貫して重みを置いていることがわかりました。

様々なゲームにおいて、次の行動を予測する際のモデルの注意を可視化したところ、画面上のアバター、エージェントが自由に行動できる空間、非エージェントな物体、主要な環境特徴などの実体に一貫して注意を向けていることがわかりました。

例えば、インタラクティブな環境において、正確な世界モデルを持つには、既知のオブジェクト(例えば、現在存在する障害物)にいつ、どのように注目するかを知ることと、将来の未知のオブジェクト(例えば、負の影響を受ける空間)に対する期待や計画を持つことが必要です。このように、各環境の多くの重要な構成要素に多様な注意を向けることが、最終的にパフォーマンスを向上させます。

上図では、ゲーム画面の各主要な資産にモデルがどの程度重きを置いているかを見ることができます。赤色が強いほど、その画素がより重要視されていることを示しています。

大規模汎化エージェントの未来

この研究は、多くの環境、実施形態、行動様式にまたがる汎用的なエージェントの訓練の可能性を示す重要なステップです。私達は、規模を大きくすることによる性能への恩恵と、さらなる規模拡大による可能性を示しました。これらの知見は、視覚や言語といった他の領域で語られている汎化と同等である事を指し示しているように思われ、データの規模拡大の大きな可能性と多様な経験から学ぶことの有効性を示唆しています。

私達は、多環境・多体系に対応した高性能なエージェントの開発に向けた今後の研究を期待しています。私たちのコードとモデルのチェックポイントは、近日中にgithubからアクセスできるようになります。

謝辞

Igor Mordatch, Ofir Nachum Menjiao Yang, Lisa Lee, Daniel Freeman, Sergio Guadarrama, Ian Fischer, Eric Jang, Henryk Michalewskiを含むこの論文の残りのすべての著者に感謝します。

3.MGDT:41種のゲームを人間同等にプレイ可能なTransformer(2/2)関連リンク

1)ai.googleblog.com

Training Generalist Agents with Multi-Game Decision Transformers

2)arxiv.org

Multi-Game Decision Transformers

3)github.com

google-research/multi_game_dt/