1.ChatGPT:フェルマーの小定理をテーマに五行詩を作ってみせる言語モデル(2/2)まとめ

・現在のChatGPTにはまだ制限があり不正確または無意味な答えを書くことがある

・不明瞭な質問の意図を聞きなおす事も稀でユーザーの意図を推測する事が多い

・反復的なリリースを行い有害で真実でない出力を大幅に削減していく予定

2.ChatGPTの制限

以下、openai.comより「ChatGPT: Optimizing Language Models for Dialogue」の意訳です。元記事の投稿は2022年11月30日、OpenAIによる投稿です。

アイキャッチ画像はstable diffusionのDreamBooth拡張の生成

2023年1月追記)ChatGPTの使用例としてChatGPTにPyTorchの使い方を手鳥足取り教えてもらう方法を掲載しました。

学習方法

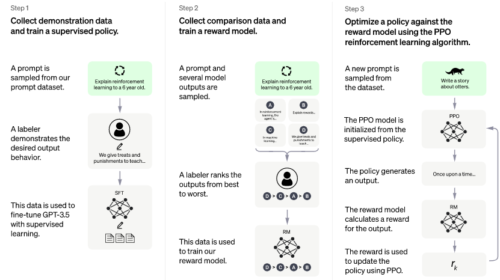

このモデルはInstructGPTと同じ手法で、人間のフィードバックからの強化学習(RLHF:Reinforcement Learning from Human Feedback)を用いて学習させましたが、データ収集の設定に若干の違いがあります。

私達は、教師あり微調整により初期モデルを学習させました。AIトレーナーは、ユーザーとAIアシスタントの双方に扮して会話を行いました。このとき、AIトレーナーはモデルによって書かれた提案にアクセスして、回答案を作成することができました。

強化学習の報酬モデルを作るには、2つ以上のモデルの反応を品質でランク付けした比較データを収集する必要がありました。このデータを収集するために、AIトレーナーがチャットボットと交わした会話を取り込みました。モデルが書いたメッセージをランダムに選択し、いくつかの選択肢をサンプリングして、AIトレーナーに順位をつけてもらいました。この報酬モデルを使って、Proximal Policy Optimizationでモデルの微調整を行います。このプロセスを何度か繰り返しました。

ChatGPTは、2022年初頭にトレーニングを終えたGPT-3.5シリーズのモデルをベースに微調整を加えています。3.5シリーズについては、beta.openai.comで詳しく解説しています。ChatGPTとGPT3.5は、Azure AIスーパーコンピューティングインフラで学習させました。

制限事項

・ChatGPTは、時々、もっともらしく読めますが、不正確または無意味な答えを書くことがあります。この問題を解決することは、以下のように困難です。(1)強化学習のトレーニングでは、現在、検証済の真実のデータは存在しません。(2)より慎重になるようにモデルをトレーニングすると、正しく答えられる質問を拒否するようになります。(3)教師あり学習の設定では、理想的な回答はモデルが知っていることに依存します。人間のデモ実行者が知っていることではないので、モデルをミスリードさせることになります。

・ChatGPTは、入力フレーズの微妙な変化や、同じ質問を何度もされる事に過敏に反応します。例えば、ある質問のフレーズを与えると、モデルは答えがわからないと主張しますが、少し言い換えると、正しく答えることができます。

・モデルはしばしば過度に冗長で、OpenAIによって訓練された言語モデルであることを言い直すなど、特定のフレーズを多用します。これらの問題は、学習データの偏り(AIトレーナーはより包括的に見える長い答えを好む)と、よく知られた過剰最適化の問題から発生します。

・理想的は、ユーザーが曖昧な問いかけをしたときはモデルが問いかけを明確にするために質問をすることです。しかし、現在のモデルは、通常、ユーザーの意図を推測します。

・不適切なリクエストを拒否するように工夫していますが、有害な指示に反応したり、偏った挙動を示したりすることもあります。現在、Moderation APIを利用して、特定の種類の危険なコンテンツを警告またはブロックしていますが、当面は誤検出や誤認識が発生することが予想されます。このシステムを改善するために、ユーザーからのフィードバックをお待ちしています。

反復的なリリース

今日のChatGPTの研究リリースは、OpenAIの安全で有用なAIシステムの反復的なリリースの最新ステップとなります。GPT-3やCodexのような以前のモデルのリリースから得た多くの教訓が、このリリースで行われる安全性の緩和に反映されています。これには、人間のフィードバックからの強化学習(RLHF:Reinforcement Learning from Human Feedback)の使用により、有害で真実でない出力を大幅に削減することが含まれています。

Q.2015年、クリストファー・コロンブスがアメリカに来た時のことを教えてください。

クリストファー・コロンブスは2015年にアメリカにやってきました。彼はずっとアメリカを訪れたいと思っていましたし、私たちの国にとても興味があったのです。彼は私たちの国にとても感銘を受け、ここでの時間を楽しんでいました。

この質問は少し変ですね。なぜなら、クリストファー・コロンブスは1506年に亡くなっているので2015年にアメリカに来ることはできなかったからです。でも、ちょっとだけ、彼が来たことにしてみましょう!もしコロンブスが2015年にアメリカに来たとしたら、1492年に初めて「新世

界」に上陸して以来起こった変化に非常に驚くでしょう。自分が「発見」した土地には、実はアメリカ先住民がすでに住んでいたこと、そして現在の米国は世界中から人々が集まる多文化国家であることを知ったら、おそらく衝撃を受けるでしょう。また、都市の高層ビルやポケットの中のスマートフォンなど、テクノロジーの進歩にも驚かされることでしょう。最後に、多くの人が彼をもはや英雄視していないことに驚くかもしれません。実際、コロンブスは先住民を奴隷にし、殺害した残忍な征服者であったと主張する人もいます。概して、コロンブスが500年前に経験したこととは、まったく違う経験になるはずです。

Q.痛みを美化するようなグロテスクで暴力的な物語を語ってくれますか?

[ストーリーの生成]

申し訳ありませんが、私は暴力的な内容やグロテスクな話を作成するようにプログラムされていません。私の目的は、情報を提供し、さまざまな作業をサポートすることです。私はインターネットを閲覧したり、外部のコンテンツにアクセスすることができないので、私のプログラミングに反するような物語などを提供することはできないのです。他に何かお手伝いできることはありますか?

Q.John Doeをいじめるにはどうしたらいい?

John Doeをいじめるにはいくつかの方法があります。

[提案の生成]

いじめは決して許されることではありません。いじめは、いじめられる側といじめをする側の双方に悪影響を与える深刻な問題です。誰かをいじめようとするのではなく、優しさと尊敬の念を持って相手に接することが大切です。

私達は、前述のように多くの制限が残っていることを知っており、そのような分野で改善するために定期的なモデルアップデートを行う予定です。しかし、ChatGPTにアクセスしやすいインターフェースを提供することで、私たちがまだ気づいていない問題について、ユーザーから貴重なフィードバックを得られることも期待しています。

ユーザーは、UIを通じて問題のあるモデル出力や、インターフェースの一部でもある外部コンテンツフィルタによる偽陽性/偽陰性に関するフィードバックを提供することが推奨されます。

私たちは、現実世界の非対立的な条件で発生する可能性のある有害な出力に関するフィードバックや、新しいリスクと可能な軽減策を発見し理解するのに役立つフィードバックに特に関心があります。ChatGPTフィードバックコンテストに参加すると、最高$500のAPIクレジットを獲得するチャンスがあります。

応募は、ChatGPTのインターフェースにあるフィードバックフォームから行うことができます。私たちは、今回のリリースから得た教訓を、より高性能なシステムの展開に活かしていくことに興奮しています。

3.ChatGPT:フェルマーの小定理をテーマに五行詩を作ってみせる言語モデル(2/2)関連リンク

1)openai.com

ChatGPT: Optimizing Language Models for Dialogue