1.2022年のGoogleのAI研究の成果と今後の展望~ロボット編~(1/2)まとめ

・大規模で汎用的な言語モデルを他のアプローチと連携し、ロボットが人間の幅広い知識から学習して自然に関わり合えるようにする能力を探求

・これにより「ロボットの学習」を「規模拡大可能なデータ問題」に変換し、汎用的な低レベルスキルの学習の規模が拡大できるようになった

・基本コンセプトの1つは大規模言語モデルを使用して他の事前学習済みモデルに情報提供を促し、現在の状況を把握した上で予測を実施する事

2.大規模言語モデルとロボット

以下、ai.googleblog.comより「Google Research, 2022 & beyond: Robotics」の意訳です。元記事は2023年2月14日、Kendra ByrneさんとJie Tanさんによる投稿です。

本投稿内でも言及されているEveryday Robotsは、一週間くらい前に子会社としての解散が決定した事が報道されています。失敗プロジェクト扱いしている報道もありますが、沢山のロボットを同時に使用してデータを大量に収集する段階はもう終わって、大規模言語モデルとの密接な統合が求められる段階になったからgoogle aiの方に吸収したって話だろうなと思っています。

アイキャッチ画像はstable diffusionのカスタムモデルによる生成で下町のロボット工場

(本記事は、Googleの様々な研究分野を取り上げるシリーズの第6部です。このシリーズの他の記事は第1部「2022年のGoogleのAI研究の成果と今後の展望~言語・視覚・生成モデル編~」からご覧いただけます)

私たちが生きている間に、人間の生産性や生活の質を向上させ、日常的な活動を支援するロボット技術が登場することになるでしょう。ロボット技術が、人間中心の空間(機械ではなく、人間のために設計された空間)で実用レベルな日常作業を支援し、広く役立つようになるには、人間を安全に、かつ有能に支援できるようになる必要があります。

2022年、私たちは、ロボットがより人の役に立つことを可能にする際の課題に焦点を当てました。

(1)ロボットと人間がより効率的かつ自然にコミュニケーションできるようにする。

(2)ロボットが実世界の状況において常識的な知識を理解し、適用できるようにする。

(3)ロボットが整理整頓されていない環境(unstructured environments)でタスクを効果的に実行するために必要な低レベルスキルの数を拡大する。

この1年の大きな流れは、PaLMのような大規模で汎用的なモデルが、他のアプローチとどのように連携し、ロボットが人間の幅広い知識から学習し、人々がより自然にロボットと関わることができるような能力を表面化できるかを探求してきたことです。

こうする事で、「ロボットの学習」を「規模拡大可能なデータ問題」に変換し、物体操作などの汎用的な低レベルスキルの学習の規模を拡大できるようにしました。本投稿では、2022年における私達の探求から得られた主要な学習とテーマについて振り返ります。

大規模言語モデルの能力をロボティクスに生かす

大規模言語モデル(LLM:Large Language Models)は、説明文や文脈を人と機械の双方が理解できるように符号化できる事が大きな特徴です。

LLMをロボット工学に応用すると、人はロボットに自然な言葉で、より簡単に、尋ねるだけでタスクを与えることができます。LLMは、視覚モデルやロボット工学の学習アプローチと組み合わせることで、ロボットが人の要求が基づく文脈を理解し、それを完了させるためにどのような行動を取るべきかを判断する方法を提供します。

基本的なコンセプトの1つは、LLMを使用して、他の事前学習済みモデルに情報提供を促す事です。これにより、視界内で何が起こっているかについての文脈を構築し、様々な種類の情報が必要となるタスクに関しても予測を立てる事ができるようになります。

これは、教師が質問をし、生徒がそれに答える事で合理的な思考プロセスに導く、ソクラテス式問答(socratic method)に似ています。

ソクラテス式問答モデルでは、このアプローチにより、事前に学習していない画像に説明文をつけるタスクや動画からテキストを検索するタスクにおいて、最先端の性能を達成できることを示しました。

また、ビデオを使った自由形式の質問に対する回答や将来の活動の予測、マルチモーダルな支援対話、そして以下に述べるように、ロボットの知覚と計画といった新しい機能を実現することができます。

このアプローチが機能するためには、長期目線が必要となるタスクを完了するための一連のステップを予測できるLLMと、与えられた状況でロボットが実行可能なスキルが何かを示すアフォーダンスモデル(affordance)の両方が必要です。

「Extracting Skill-Centric State Abstractions from Value Functions」では、強化学習(RL:Reinforcement Learning)モデルの価値関数を用いて、アフォーダンスモデル(異なる状態の下でロボットが実行できる行動の抽象表現)を構築できることを示しました。

これにより、「リビングを片付ける」という現実のタスクを実行するための長期目線と、そのタスクを完了するために必要な短期目線のスキル(アイテムを正しく選び、置き、並べるなど)を結びつけることができます。

LLMとアフォーダンスモデルの両方を持っていても、ロボットが実際にタスクを成功させられるとは限りません。しかし、「Inner Monologue:Embodied Reasoning through Planning with Language Models」では、LLMに基づくタスクプランニングのループを閉じ、人間のフィードバックやシーン理解といった他の情報源によって、ロボットがタスクを正しく完了できなかった場合に検出するようにしました。

Everyday Robotsのロボットを使って、LLMは現在または以前の計画ステップが失敗した場合に効果的に再計画できることを示し、ロボットが失敗から回復して、下のビデオに示すように「一番上の引き出しにコーラを入れる」といった複雑なタスクを完了できるようにしました。

Inner Monologueで見られた、LLMベースのタスクプランニングのループを閉じることによる新たな能力は、ロボットがタスクの途中で高レベルのゴールの変更に反応できることです。例えば、人はロボットの行動を変更するために、素早い修正を行ったり、ロボットを別のタスクに向かわせたりすることができます。このような行動は、ロボットが人のそばで作業しているときに、人がロボットのタスクをインタラクティブに制御したりカスタマイズしたりするのに特に有効です。

自然言語を使えば、ロボットのタスクを指定したり、変更したりすることが容易になりますが、ロボットができるタスクを表現するために人々が使える語彙を、リアルタイムで反応させることができるかが課題の一つです。

「Talking to Robots in Real Time」では、リアルタイムで、語彙を限定せずに、言語条件付きロボットを作成するための大規模模倣学習フレームワークを示しました。

1つのポリシーで87,000以上のユニークな命令に対応することができ、平均成功率は93.5%と推定されました。このプロジェクトの一環として、言語注釈付きロボットデータセットとして最大規模のLanguage-Tableを公開し、リアルタイムで言語制御可能なロボットに焦点を当てたさらなる研究の推進を期待しています。

リアルタイムの人間の言語誘導のもと、長期目線が必要な目標に到達した例

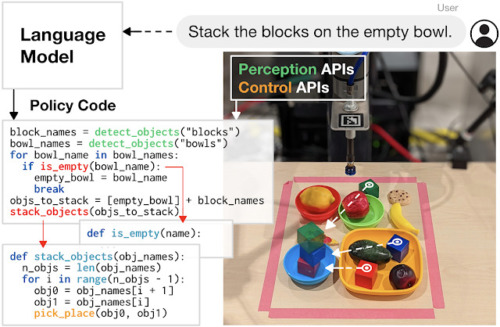

私たちは、LLMがロボットの動作を制御できるコードを書く可能性についても期待しています。コードを書くアプローチは「Robots That Write Their Own Code」で示したように、APIコールを再構成して新しいコードを自律的に生成することで、ロボットがこなすタスクの複雑さを高めることが期待できます。また、新しい機能を合成し、フィードバックループを表現することで、実行時に新しい動作を組み立てることができます。

Code as Policiesは、コードを書ける言語モデルを使用して、タスクを完了するために自然言語の指示をロボット操作コードにマッピングします。生成されたコードは、既存のパーセプションアクションAPIやサードパーティライブラリを呼び出したり、実行時に新しい関数を記述することができます。

3.2022年のGoogleのAI研究の成果と今後の展望~ロボット編~(1/2)関連リンク

1)ai.googleblog.com

Google Research, 2022 & beyond: Robotics

2)innermonologue.github.io

Inner Monologue:Embodied Reasoning through Planning with Language Models

3)sites.google.com

Legged Robots that Keep on Learning:Fine-Tuning Locomotion Policies in the Real World

4)sites.google.com

GoalsEye: Learning High Speed Precision Table Tennis on a Physical Robot