1.Google Research:2019年の振り返りと2020年以降に向けて(2/8)まとめ

・AIの他の分野への応用では様々な組織とコラボし多くの論文発表や芸術作品に繋がった

・日常生活を支援するAIとしては視覚、聴覚、音声に困難を抱える人々向けにアプリを発表

・音声を文章に書き起こしたり文章を読み取って音声として再生したり日常生活の改善に繋がった

2.AIの他の分野への応用と日常生活の支援

以下、ai.googleblog.comより「Google Research: Looking Back at 2019, and Forward to 2020 and Beyond」の意訳です。元記事の投稿は2020年1月9日、Google Research部門トップのJeff Deanさんによる投稿です。アイキャッチ画像のクレジットはPhoto by Benjamin Davies on Unsplash

(3)AIの他の分野への応用

他の科学分野へのコンピューターサイエンスと機械学習の応用は、特に多数の組織間でコラボレーションをする事で多くの論文発表に繋がり、私達が特に興奮している分野です。 今年のハイライトは次のとおりです。

・論文「An Interactive, Automated 3D Reconstruction of a Fly Brain」では、ハエの脳全体の構造をマッピングすると言うマイルストーンを達成したコラボレーションについて報告しました。この研究は、ハエの脳の個々のニューロンを入念にトレースする機械学習モデルを使用する事で実現しました。

![]()

・論文「Learning Better Simulation Methods for Partial Differential Equations」では、気候科学、流体力学、電磁気学、熱伝導、一般相対性理論における多くの基本的な計算問題の中心にある偏微分方程式(PDE:Partial Differential Equations)計算を加速するために、機械学習を使用する方法を示しました。

流体中の衝撃波を表現するモデルであるバーガー方程式を、従来の有限体積法(左)または今回発表したニューラルネットワークベースの手法(右)で予測したもの。オレンジ色の四角は、予測結果を表します。これらの四角は定期的にモデルにフィードバックされ、モデルは各四角がどのように変化するかを予測します。青色の線は、バーガー方程式の正確なシミュレーションを示しています。 青色の線を滑らかにトレースするオレンジ色の四角が示すように、右側のニューラルネットワークによる手法は、予測ポイントの数が1/4程度であっても非常に滑らかです。

・論文「Learning to Smell: Using Deep Learning to Predict the Olfactory Properties of Molecules」では機械学習モデルで香りの感覚を扱う事に取り組みました。グラフニューラルネットワーク(GNN)を活用して、手動で振り分けルールを作成する事なしに、個々の分子の匂い記述子を直接予測する方法を示しました。

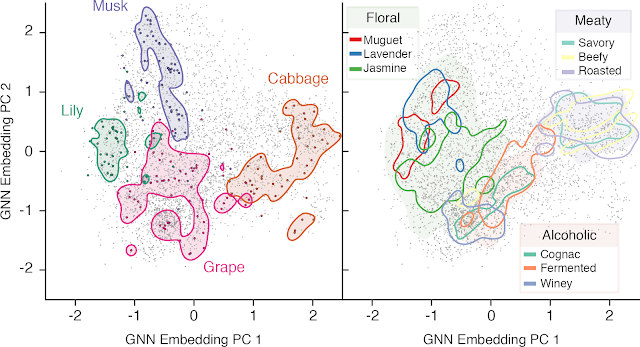

embedding空間を2D表示した図。いくつかの匂いが強調表示されています。

左:それぞれの匂いがそれぞれの空間に集まってクラスタ化されています。

右:匂い記述子の階層的性質。影付きおよび輪郭付きの領域は、embeddingのカーネル密度推定を使用して計算されました。フローラルには「muguet(すずらん)」、「Lavender(ラベンダー)」、「Jasmine(ジャスミン)」などが含まれ、アルコールには「winey(ワイン)」や「Cognac(コニャック)」、「Fermented(発酵)」などが含まれます。

・化学と強化学習技術を組み合わせた研究では、「Optimization of Molecules via Deep Reinforcement Learning」で分子を最適化するフレームワークを発表しました。

・機械学習は、芸術的および創造的な取り組みにも役立ちます。アーティストは、AIやARと協力して、機械で踊ったり、振り付けを再考したり、機械学習ツールで新しいメロディを作成するなど、興味深い新しい表現手段を作成する方法を見つけました。MLは技術に詳しくなくとも使用できます。ヨハン・ゼバスティアン・バッハの生誕記念日を祝うために、私たちはMLを活用したツールをDoodle(Googleの検索ページのタイトル部分)で特集しました。あなたがメインメロディを作成するだけで、MLツールはバッハスタイルでハーモニ―を作成してくれます。

(4)日常生活を支援するAI

機械学習は日常生活の中で、より個人的なニーズに合わせて私達を助ける事ができます。

美しい画像を見たり、お気に入りの曲を聴いたり、愛する人と話をしたりするのは当然の事と感じるかもしれませんが、世界では10億人を超える人々がこれらの方法で現実世界と関わり合う事ができません。機械学習テクノロジは、これらの信号(視覚、聴覚、音声)を、アクセシビリティが必要な人々が適切に管理できる他の信号に変換することで、周囲世界へのアクセスを改善します。

支援技術のいくつかの例:

・Lookoutは、目の不自由な人や弱視の人が周囲の情報を特定するのに役立ちます。Google Lensと同じテクノロジーを基盤としており、スマートフォン搭載カメラを向けるだけで、周囲の物体を検索して文字を読みあがる等のアクションを実行できます。

・Live Transcribeは、耳の不自由な人や日常生活での自立が難しい人に大きな可能性をもたらします。ユーザーが行っている会話をリアルタイムで文字起こし可能なため、それを読む事で情報を取得できます。外国語で話しかけられた場合でも文字起こしが可能です。

・Project Euphoniaは、パーソナライズされた音声からテキストへの文字起こしを実行します。ALS(筋萎縮性側索硬化症)やその他の発声に困難を抱える人々のために、聞き取りが難しい発声、または非標準的なスピーチであっても、文字起こしが可能であり、この研究は他の最新の自動音声認識モデルよりも聞き取り性能を改善しています。

・Project Euphoniaと同様に、Parrotronは音声を音声にそのままの変換するニューラルネットワークを使用してコミュニケーションを改善します。Parrotronでは、音声を文字に書き起こす転写ではなく、音声を音声にそのままの変換する事に焦点を当てており、一部の人にとっては更にアクセスしやすい音声インターフェイスを提供しています。

・インターネット上の何百万もの画像には説明文がありません。Googleが提供するブラウザであるChromeのscreen readerではGoogleから画像の説明を取得する機能が実装されており、目の不自由なユーザーや低視力のユーザーが説明ない画像が何なのかを理解するのに役立ちます。screen readerが説明のない画像やグラフィックに遭遇した場合、Chromeは自動的に説明を取得できるようになりました。

・Lens for Google Goでは、スマートフォンのカメラに写した文書を音声に変換できるツールを開発しました。読み書きが完全にできないユーザーであっても、看板や説明書きなどの周囲の文章が何を表しているかを知り、文書による案内を利用する事が出来るようになります。

3.Google Research:2019年の振り返りと2020年以降に向けて(2/8)関連リンク

1)ai.googleblog.com

Google Research: Looking Back at 2019, and Forward to 2020 and Beyond

2)research.google

Publication database(2019)

Optimization of Molecules via Deep Reinforcement Learning

AVA

3)modelcards.withgoogle.com

Object Detection Model Card v0 Cloud Vision API

4)ai.google

Working together to apply AI for social good

5)blog.google

Using AI to give people who are blind the “full picture”

What our quantum computing milestone means

Teachable Machine 2.0 makes AI easier for everyone

Google for Startups Accelerator empowers AI startups in Europe

6)support.google.com

Get image descriptions on Chrome

7)federated.withgoogle.com

Federated Learning An online comic with google AI

8)arxiv.org

The Evolved Transformer

9)www.isca-speech.org

Improving Keyword Spotting and Language Identification via Neural Architecture Search at Scale

10)github.com

google / jax

11)leogao.dev

The Decade of Deep Learning

コメント