1.Project Euphoniaの非標準音声用にパーソナライズした音声認識(1/2)まとめ

・Project Euphoniaは音声認識モデルを改良して様々な非定形音声を適切に転写する事が目標

・一般的な音声モデルでトレーニングした後に個人特有の話し方の癖など学ばせる二段階方式で学習

・ニューラルネットワークアーキテクチャーもRNN-TベースとLASベースの2モデルを検討

2.Project Euphoniaとは?

以下、ai.googleblog.comより「Project Euphonia’s Personalized Speech Recognition for Non-Standard Speech」の意訳です。元記事は2019年8月13日、Joel ShorさんとDotan Emanuelさんによる投稿です。こういった困難を抱える人向けのサービスに取り組んでる方達は皆さん笑顔が素敵です。

テクノロジーの有用性は、そのアクセシビリティに依存しています。アクセシビリティの重要な要素の1つは、自動音声認識(ASR:Automatic Speech Recognition)です。ASRの改良により、発声に困難を持つ人が日常的にスマートデバイスと対話し使いこなす能力が大幅に向上します。

ただし、ASRシステムはほとんどの場合、「典型的な発音の音声データ」から訓練されます。つまり、発声に困難を抱える人々の音声データ、聞き取りにくい発声やアクセントはASRシステムを訓練する際に重視されていないため、これらの人々の発声はASRが認識できない事が多く、あまり有用ではありません。

たとえば、筋萎縮性側索硬化症(ALS)は、人の発話に悪影響を与える可能性がある病気です。ALS患者の約25%が、最初の症状として不明瞭な発話を経験します。更にALSを患うほとんどの人は最終的に歩行する能力を失うため、離れた場所から自動化された機器と対話できることは非常に重要です。

しかし、現在の最先端のASRモデルであっても、ALS患者の発声を聞き取る事は困難です。ALSにより発話に中程度の困難がある話者の発声であっても高い単語誤認識率(WER:Word Error Rates)を示し、事実上、ALS患者がASR技術に頼る道を閉ざしています。

Interspeech 2019で発表される論文「Personalizing ASR for Dysarthric and Accented Speech with Limited Data」では、音声からテキストへの転記を実行するASRプラットフォームであるProject Euphoniaの背後にあるいくつかの研究について解説しています。

今回の研究は、ALSを患う人々の発声に対してASRシステムを改善するアプローチを提示しており、この結果は、他の同様のタイプの非標準音声にも適用できます。

基本となる「標準的な音声」を用いたトレーニングから開始し、パーソナライズされた音声データセットでトレーニングを微調整する2段階のトレーニングアプローチを使用して、現在の最先端モデルよりも非定型のスピーチを持つ話者の発声の認識率の大幅な改善を実証しました。

2段階トレーニングアプローチ

非標準の音声で機能するASRモデルを作成するには、2つの課題を克服する必要があります。1つ目は、例えば地域的なアクセントや病気がもたらす発話障害などの複数の人が患うある特定の非定型的な発話状態であっても、その中で更に個人は個人特有の非常に異なった話し方をするということです。

私たちのアプローチは、ASRモデルを2つのフェーズでトレーニングすることにより、このサブグループ間での不均一性を扱います。数千時間の標準音声でトレーニングされた高品質のASRモデルを元に、非標準音声を持つ個人に合わせてモデルの一部を微調整します。

このアプローチはParrotronのアプローチに似ています。両方のシステムは、エンドツーエンドのニューラルネットワークを使用してコミュニケーションとアクセシビリティを向上させますが、Parrotronは、テキストではなく、音声から音声にのみ焦点を当てています。

2番目の課題は、個人向けに最新の認識エンジンをトレーニングするために必要な十分なデータを収集することが難しいことから生じます。典型的な音声認識装置は、多くの異なるスピーカーが発声した数千時間規模の莫大な音声データを使って訓練されています。

1人の話者からこれだけのデータを取得することは、ほぼ不可能です。特に、今回のケースでは話者が抱える病状のために話す事は非常に体力を消耗する場合があります。私達のアプローチは、最初に典型的なスピーチの大きな言語データで基本モデルをトレーニングし、次にターゲットの非標準スピーチ特性を持つはるかに小さなデータセットを使用してパーソナライズされたモデルをトレーニングすることでこの問題を解決します。

ニューラルネットワークのアーキテクチャ

非定型音声のトレーニングデータに使用されるモデルを開発する際、2つの異なるニューラルアーキテクチャを検討しました。

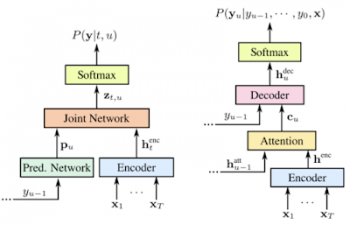

1つ目はRNN-Transducer(RNN-T)です。これは、多数のASRタスクで良好な結果を示したエンコーダーおよびデコーダーネットワークで構成されるニューラルネットワークアーキテクチャです。エンコーダーは双方向(つまり、文脈を理解するために単語の前の文章と後の文章を確認するモデル。言い換えれば文全体を確認する必要がある)であるため、音声認識を実行するにはオーディオサンプル全体が必要です。

もう1つのアーキテクチャは、LAS(Listen, Attend, and Spell)です。これは、連続する音響特性を連続する言語情報にマッピングする、Attentionに基づくsequence-to-sequenceモデルです。

このモデルは、エンコーダーを使用して音響フレームのシーケンスを内部表現のシーケンスに変換します。そして、デコーダーを使用して内部表現のシーケンスを言語出力に変換します。ネットワークは、「単語の断片」を生成します。これは、書記素と単語の間の言語表現です。

RNN-Transducer(左)とListen、Attend、Spell(右)のアーキテクチャの比較。Prabhavalkar et al. 2017より

2種類の非標準音声で、最先端のRNN-TおよびLASベースモデルを微調整して実験しました。 ALSセラピー開発研究所とのパートナーシップにより、最初にALSを持つ67人のスピーカーから約36時間の音声を収集しました。

参加者は、非常に制限された文章を読みながら、カスタムソフトウェアを使用して自宅のコンピューターに記録しました。多くのフレーズは、単純な文法構造を持つ単一の文でした。(例:「今夜のバスケットボールの試合は何時ですか?」)

これは、特定領域固有の語彙(科学の話など)や複雑な言語構造(討論など)が含まれる制限無しの文章とは対照的です。録音データには、「um」や「uh」など、通常の発話で一般的な繋ぎ言葉は多くは含まれていませんでした。

また、非ネイティブ音声のオープンソースデータセットであるL2 Arctic dataseを使用してアクセント付き音声をテストしました。これは、20人のスピーカーで構成され、スピーカーごとに約1時間の音声が収録されています。各スピーカーは、CMU Arctic promptsから1150の発話セットを録音しています。

| ASL患者の発音音声 | Euphonia Model | 一般的なASR |

| Did I have anything to say about it? | Dictatorship angels to think about it | |

| Come right back please | Cameras object | |

| Let’s try that again | It extracts | |

| Turn it down a little bit please | Turning down a little bit please |

オーディオ(左)は、ALS患者の話者の録音です。テキストの書き起こしは、Euphoniaモデル(中央)と標準音声モデル(右)から出力されます。 誤って転写されたテキストは太字になっています。

3.Project Euphoniaの非標準音声用にパーソナライズした音声認識(1/2)関連リンク

1)ai.googleblog.com

Project Euphonia’s Personalized Speech Recognition for Non-Standard Speech

2)arxiv.org

Personalizing ASR for Dysarthric and Accented Speech with Limited Data

3)www.blog.google

How AI can improve products for people with impaired speech

4)ieeexplore.ieee.org

Adapting acoustic and lexical models to dysarthric speech

コメント