1.MICLe:自己教師あり学習で医療用画像の分類精度を向上(1/3)まとめ

・医療画像分類にディープラーニングを適用することへの関心が高まっている

・しかし対照学習などの直近の画像分類タスクの進歩は十分に検討されていない

・医療画像分類における事前トレーニングとして自己教師あり対照学習の有効性を調査

2.MICLeとは?

以下、ai.googleblog.comより「Self-Supervised Learning Advances Medical Image Classification」の意訳です。元記事は2021年10月13日、Shekoofeh Aziziさんによる投稿です。

マルチインスタンス対照学習を意識して選んだアイキャッチ画像のクレジットはPhoto by Marian Oleksyn on Unsplash

近年、医療画像タスクにディープラーニングを適用することへの関心が高まっており、放射線学(radiology)、病理学(pathology)、皮膚科(dermatology)などのさまざまなアプリケーションでエキサイティングな進歩が見られます。

関心が高いにもかかわらず、医用画像モデルの開発は依然として困難です。医用画像に注釈を付けるという時間がかかる作業が必要になるため、高品質のラベル付きデータが利用できない場合が多いためです。

上記理由により、転移学習は医用画像モデルを構築する際に一般的に良く使われるパラダイムです。このアプローチでは、モデルは最初に、大きなラベル付きデータセット(ImageNetなど)での教師あり学習を使用して事前トレーニングされ、次に一般的な画像から学んだ特徴表現が医療領域の画像データで微調整されます。

特にラベル付けされたサンプルが不足している場合に、自然な画像認識タスクで成功することが証明されている他の最近のアプローチには、自己教師あり対照的事前トレーニング(self-supervised contrastive pre-training)と、それに続く教師あり微調整(SimCLRやMoCoなど)があります。

対照学習による事前トレーニングでは、

(1)同じ画像に回転や切り抜きなどの異なる変換を適用して2つの画像を作る

(2)異なる画像を同様に変換して2つの画像を作る

(1)のペアが互いに近くなり、(2)のペアが互いに遠くなるようにすることによって、汎用的な特徴表現を学習します。

この成功にもかかわらず、これらの対照的な学習方法は、医療画像分析において限られた注目しか受けておらず、有効性はまだ調査されていません。

ICCV 2021で発表された「Big Self-Supervised Models Advance Medical Image Classification」では、医療画像分類における事前トレーニング戦略として自己教師あり対照学習の有効性を研究します。

また、医用画像データセットの特殊な特性を活用するために対照学習を一般化する新しいアプローチであるマルチインスタンス対照学習(MICLe:Multi-Instance Contrastive Learning)を提案します。

2つの異なる医用画像分類タスクで実験を行いました。

・デジタルカメラ画像で撮影した皮膚状態の分類(27カテゴリー)

・複数ラベルが付与された胸部X線画像の分類(5カテゴリー)

ImageNetを使った自己教師あり学習と、それに続くラベルのない医療領域固有の医用画像で追加の自己教師あり学習を行う事により、医用画像分類器の精度が大幅に向上することがわかりました。

具体的には、完全教師あり事前トレーニングとして全ImageNetデータセット(1400万画像と218,000クラス)が使用されていたとしても、自己教師あり事前トレーニングの方が優れていることを示します。

SimCLRとマルチインスタンス対照学習(MICLe)

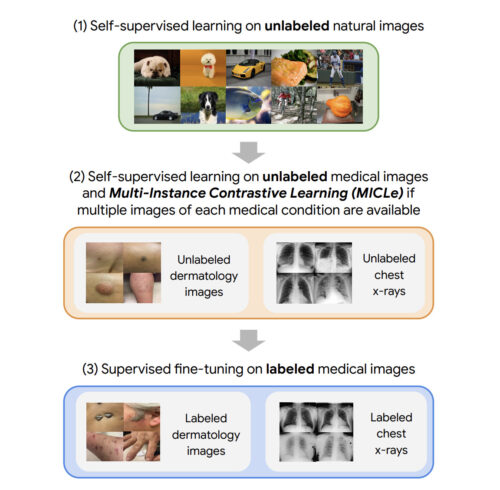

私たちのアプローチは、次の3つのステップで構成されています。

(1)ラベルのない自然画像の自己教師による事前トレーニング(SimCLRを使用)

(2)ラベルのない医療データを使用した(SimCLRまたはMICLeのいずれかを使用した)自己教師による事前トレーニング

(3)ラベル付けされた医療データを使用したタスク固有の教師あり微調整

私たちのアプローチは3つのステップで構成されています。

(1)SimCLRを使用したラベルなしImageNetでの自己教師事前トレーニング(2)ラベルなし医療画像を使用した追加の自己教師事前トレーニング。各病状について複数の画像が利用可能な場合、新手法であるマルチインスタンス対照学習(MICLe)戦略を使用して、異なった画像に基づいてより情報量の多いポジティブペアを構築します。(3)ラベル付けされた医用画像を使った教師有り微調整。ステップ(1)とは異なり、ステップ(2)と(3)はタスクとデータセットに固有であることに注意してください。

3.MICLe:自己教師あり学習で医療用画像の分類精度を向上(1/3)関連リンク

1)ai.googleblog.com

Self-Supervised Learning Advances Medical Image Classification

2)arxiv.org

Big Self-Supervised Models Advance Medical Image Classification