1.MICLe:自己教師あり学習で医療用画像の分類精度を向上(2/3)まとめ

・SimCLRはデータ増強によってのみペアを構築するので医療用画像の特性を活用できない

・MICLeはマンモグラムの正面図と側面図など病理を複数視点から撮影した画像を活用

・これは視点や撮影条件の変換に対して堅牢な特徴表現を学習する絶好の機会を提供

2.自己教師あり事前学習

以下、ai.googleblog.comより「Self-Supervised Learning Advances Medical Image Classification」の意訳です。元記事は2021年10月13日、Shekoofeh Aziziさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Marian Oleksyn on Unsplash

ラベルのない自然画像を使ったSimCLRによる最初の事前トレーニングが完了した後、医用画像データセットの特殊な特性を捕捉するようにモデルをトレーニングします。

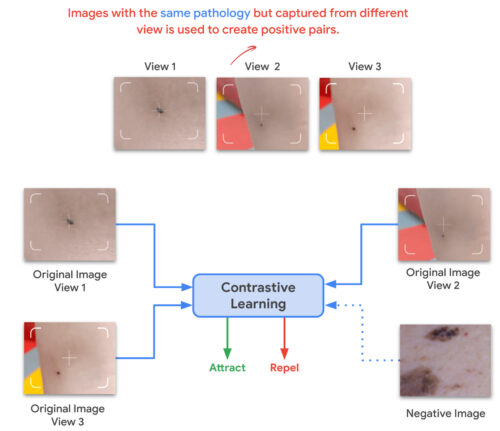

このステップもSimCLRで実行できますが、SimCLRはデータ拡張によってのみポジティブペアを構築するので、ポジティブペア構築の際に患者のメタデータを気軽に活用する事ができません。そのため、代わりにMICLe(Multi-Instance Contrastive Learning)を使用します。

MICLeは、利用可能な場合、各患者の症例の根底にある病理の複数の画像を使用して、自己教師あり学習のためのより有益なポジティブペアを構築します。このようなマルチインスタンスデータは、多くの場合、医用画像データセットで利用できます。たとえば、マンモグラムの正面図と側面図、左右の眼の網膜眼底画像などです。

特定の患者の症例に関する複数の画像が与えられると、MICLeは、同じ患者の症例を撮影した2つの異なる画像から2つの切り抜き画像を作成することにより、自己教師型対照学習用にポジティブペアを構築します。

そのような画像は、異なる視野角から撮影され、同じ根本的な病状を有する異なる身体部分を示し得ます。

これは、自己教師あり学習アルゴリズムが、視点の変化、撮影条件、およびその他の交絡因子に対して直接的な方法で堅牢な特徴表現を学習する絶好の機会を提供します。

MICLeはクラスラベル情報を必要とせず、根底にある病理の異なる画像のみに依存しますが、その病理の種類は不明な可能性があります。

MICLeは、対照学習を一般化して、医用画像データセット(患者のメタデータ)の特殊な特性を活用して現実的なデータ増強を行い、画像分類器のパフォーマンスをさらに向上させます。

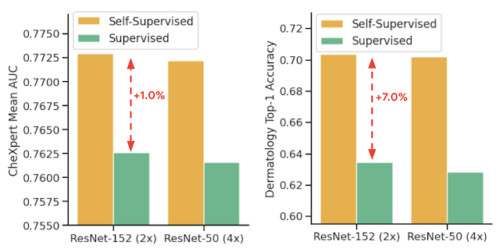

これらの自己教師あり学習戦略を組み合わせることで、競争の激しい製品設定でも、皮膚科の皮膚状態分類でtop-1精度で6.7%、胸部X線分類の平均AUCで.1%のの大幅な向上を達成できることを示しています。

これは、ImageNetで事前にトレーニングされた強力な教師あり手法(医療画像分析モデルをトレーニングするための一般的な手法)を上回っています。更に、自己教師モデルは分布シフトに対して堅牢であり、少数のラベル付き医用画像で効率的に学習できることを以下で示します。

完全教師あり学習と自己教師ありの事前トレーニングの比較

その単純さにもかかわらず、MICLeを使用した事前トレーニングは、SimCLRを使用した元の事前トレーニング方法よりも皮膚分類のパフォーマンスを一貫して向上させることがわかりました。異なった事前トレーニングデータセットと基本となるネットワークアーキテクチャを変更しても結果は同じでした。

事前トレーニングにMICLeを使用すると、SimCLRを使用した場合よりも、皮膚分類のtop-1の精度が(1.18±0.09)%向上します。

この結果は、追加のメタデータまたは医療領域の知識を利用して、対照的な事前トレーニングのためのより意味的に意味のあるデータ拡張を構築することから得られる利点を示しています。

更に、私たちの結果は、モデルの幅が広く深いほどパフォーマンスが向上することを示しています。ResNet-152(2x width)モデルはResNet-50(1x width)モデルまたはそれよりも小さいモデルよりもパフォーマンスが優れていました。

完全教師あり学習と自己教師ありの事前トレーニングの比較、後続処理として皮膚分類と胸部X線分類に関する2つのアーキテクチャを使用した教師あり微調整をしています。自己教師あり学習ではラベルのない領域固有の医用画像を利用していますが、ImageNetを使った教師あり事前トレーニングのスコアを大幅に上回ります。

自己教師モデルを使い一般化性能を改善

タスクごとに、医療領域のラベルなしデータとラベル付きデータをそれぞれ使用して、事前トレーニングと微調整を実行しました。また、異なる臨床設定で取得された別のデータセットを「データの分布がシフトしたデータセット(分布シフト)」と見なして、ドメイン外データ(out-of-domain data)に対する手法の堅牢性をさらに評価しました。

胸部X線タスクの場合、ImageNetまたはCheXpertデータのいずれかを使用した自己教師による事前トレーニングによって一般化が改善されますが、両方を適用すると更にメリットが得られることに着目してください。

予想どおり、自己教師型の事前トレーニングにImageNetのみを使用した場合、事前トレーニングに医療領域データのみを使用した場合と比較して、モデルのパフォーマンスが低下することにも着目してください。

分布シフト下でのパフォーマンスをテストするために、タスクごとに、さまざまな臨床設定で収集された追加のラベル付きデータセットをテスト用に用意しました。

3.MICLe:自己教師あり学習で医療用画像の分類精度を向上(2/3)関連リンク

1)ai.googleblog.com

Self-Supervised Learning Advances Medical Image Classification

2)arxiv.org

Big Self-Supervised Models Advance Medical Image Classification