1.Dreamer V2:モデルベース強化学習でモデルフリー強化学習を超える(2/2)まとめ

・Atariベンチマークには3つのパフォーマンス計測基準が存在するが一長一短であった

・Clipped Record Meanと言う従来手法より人間と比較しやすい新しい計測基準を提案

・DreamerV2はゲーム全体で平均して人間の記録より25%上のスコアを達成した

2.Dreamer V2の性能

以下、ai.googleblog.comより「Mastering Atari with Discrete World Models」の意訳です。元記事の投稿は2021年2月18日、Danijar Hafnerさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Alvaro Reyes on Unsplash

Atariのゲームを使ったパフォーマンスの測定

DreamerV2は、競争の激しいAtariベンチマークで、人間レベルのパフォーマンスで成功した行動を学習できる最初の世界モデルです。私達はこれまでの多くの研究で共通している55のゲームを選択しました。今後、研究を行う際には同じゲームのセットをお勧めします。

標準の評価プロトコルに従って、エージェントは4のアクションリピートとスティッキーアクションは25%(sticky actions:アクションが無視され、代わりに前のアクションが繰り返される確率)で2億回の環境との対話を許可されます。

モデルフリーのトップエージェントであるIQNとRainbow、およびDopamine フレームワークに実装されている有名なC51エージェントとDQNエージェントを比較しました。

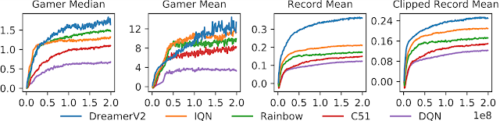

55のゲーム全体のスコアを集計するための様々なパフォーマンス計測基準が存在します。理想的な事に、新しいアルゴリズムはすべての条件下でより良いパフォーマンスを発揮します。4つの集計方法すべてについて、DreamerV2は、同じ計算資源制約の元で、比較されたすべてのモデルフリーアルゴリズムよりも優れています。

DreamerV2は、55のAtariゲーム全てのスコアを集計するために考案された4つの計測手法で、トップのモデルフリーエージェントをよりも優れていました。有益で堅牢なパフォーマンス測定基準として、Clipped Record Mean(右端の図)を紹介し、推奨します。

最初の3つの計測方法は、従来の文献で提案されていました。それぞれの重要な欠点を特定し、新しい集計方法をお勧めします。clipped record meanは、それらの欠点を克服することを意味します。

(1)Gamer Median(ゲーマー中央値)

最も一般的です。各ゲームのスコアは、DQNの論文で評価された人間のゲーマーのパフォーマンスによって正規化され、全てのゲームの正規化されたスコアの中央値が報告されます。残念ながら、中央値は多くのシンプルで難しいゲームのスコアを無視してしまいます。

(2)Gamer Mean(ゲーマー平均値)

ゲーマー平均は全てのゲームのスコアを考慮に入れていますが、主に人間のゲーマーのパフォーマンスが低い少数のゲームの影響を受けます。これにより、アルゴリズムが一部のゲーム(James Bond、Video Pinballなど)で大きく正規化されたスコアを達成し、平均値を支配することが容易になります。

(3)Record Mean(世界記録平均値)

従来の研究では、代わりに人間の世界記録に基づく正規化が推奨されていますが、そのような基準は、人工知能エージェントが人間の世界記録を上回りやすい少数のゲームの影響を過度に受けてしまいます。

(4)Clipped Record Mean(世界記録で刈り取った平均値)

世界記録によってスコアを正規化し、世界記録を超えないように刈り取る(clip)新しい基準を導入します。これにより、全てのゲームのパフォーマンスをほぼ等しい量で考慮した、有益で堅牢な基準が得られます。

現在のアルゴリズムの多くは人間のゲーマーが達成した基準を超えていますが、それでも人間の世界記録からかなり遅れています。上の右端の図に示されているように、DreamerV2は、ゲーム全体で平均して人間の記録より25%上のスコアを達成し、リードしています。世界記録でスコアを刈り取る事で、いくつかのゲームで世界記録を超えるのではなく、全てのゲームで人間の世界記録に近づく方法を開発する事に注力することができます。

重要な事とあまり重要でない事

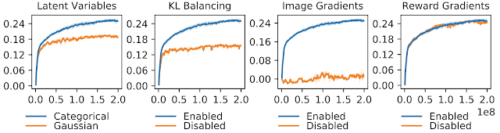

DreamerV2の重要な構成要素についての洞察を得るために、広範なアブレーション研究を実施しています。重要なのは、ガウス分布が以前の研究で広く使用されてきたという事実にもかかわらず、カテゴリ特徴表現がガウス特徴表現よりも明らかに有利であることを発見したことです。KLバランシングは、ほとんどの生成モデルで使用されるKL正則化よりもさらに大きな利点を提供します。

画像の再構築または報酬予測の勾配がモデルの状態を形成するのを防ぐことによって、成功した特徴表現を学ぶためにそれらがどのような貢献をしているのか重要性を研究しました。

DreamerV2は、高次元の入力画像からの普遍的な情報に完全に依存しており、その特徴表現により、報酬に関する情報を使用してトレーニングされていない場合でも、正確な報酬の予測が可能になることがわかりました。これは、コンピュータビジョンコミュニティでの教師なし特徴表現学習の成功を反映しています。

DreamerV2(Clipped Record Mean)の様々なアブレーションに対するAtariのパフォーマンス。

DreamerV2の成功には、カテゴリ特徴表現、KLバランシング、および画像についての学習が不可欠です。一部のタスクに固有の報酬情報を使用しても、世界モデルを学習するための追加の利点はありません。

結論

競争の激しいAtariベンチマークで人間レベルのパフォーマンスを達成し、モデルフリーのトップエージェントを上回る強力な世界モデルを学習する方法を示しました。

この結果は、世界モデルが強化学習問題で高いパフォーマンスを達成するための強力なアプローチであり、実践者や研究者がすぐに使用できることを示しています。これは、コンピュータビジョンにおける教師なし特徴表現学習の成功が、強化学習の世界モデルのとして実現され始めていることを示していると考えています。

DreamerV2の非公式な実装は、Githubで入手でき、将来の研究プロジェクトの生産的な出発点を提供します。大規模なオフラインデータセット、長期記憶、階層的計画、および指示された探索を活用する世界モデルは、将来の研究のための刺激的な手段であると考えています。

謝辞

このプロジェクトは、Timothy Lillicrap, Mohammad Norouzi 及び Jimmy Baとのコラボレーションです。更に、プロジェクト全体の任意の時点で、私たちの論文の草稿にコメントし、フィードバックを提供してくれたBrain Teamと、その枠を超えて多くの皆さんに感謝します。

3.Dreamer V2:モデルベース強化学習でモデルフリー強化学習を超える(2/2)関連リンク

1)ai.googleblog.com

Mastering Atari with Discrete World Models

2)arxiv.org

Mastering Atari with Discrete World Models

3)github.com

danijar / dreamerv2