1.Context R-CNN:過去に撮影された写真を参照して仕掛けカメラの物体検出能力を改善(1/2)まとめ

・生態学的モニタリングは、地球規模の生態系の変遷や人類の活動の影響を測定するのに役立つ

・データ取得は固定カメラ可能だが固定カメラ画像は品質のブレが大きいため自動分析が難しい

・Context R-CNNは過去画像を参照してカメラに写り込んだ物体を特定する能力を向上した

2.Context R-CNNとは?

以下、ai.googleblog.comより「Leveraging Temporal Context for Object Detection」の意訳です。元記事の投稿は2020年6月26日、Sara BeeryさんとJonathan Huangさんによる投稿です。

アイキャッチ画像はケニアのナイバシャのヌーで、クレジットはAdam Mosley for sharing their work on Unsplash.

動植物の生態を観察する「生態学的モニタリング(Ecological monitoring)」は、研究者が地球規模の生態系の変遷を理解し、生物の多様性を定量化し、環境保全と問題改善の取り組みの効果など、気候変動と人類の活動の影響を測定するのに役立ちます。

生態学者は効果的にこれら測定するために、高品質のデータを必要とし、多くの場合、固定カメラなどの監視センサーを現場に配置するために多大な労力を費やしています。

このようなセンサーのネットワークを構築して運用していく事はコスト効率がますます高くなってきていますが、取得したグローバルな生物多様性データは従来通り手動でデータ分析する必要があり、この分析作業は正確でグローバルなリアルタイム生態学的モニタリングを実施する際のボトルネックとなっています。

機械学習を介してこの分析を自動化する方法はありますが、山道の道路状況から生態系の季節による変遷に至るまで、様々な目的で私達の周りの世界を監視するために広く使用されている固定カメラからのデータは、従来のコンピュータービジョンシステムにとって依然として大きな課題です。

電力と保存容量の制約により、撮影間隔は長くなり、多くの場合、写真は1秒あたり1枚以下しか撮影できず、更に、動きを感知して撮影するシステムの場合は撮影時間帯は不規則になってしまいます。

このような設定でも良好に機能するためには、コンピュータービジョンモデルは、画像の中心から外れている、焦点が合っていない、照明が不十分である、または様々な縮尺の対象物体に対しても堅牢に動作しなければなりません。

更に、固定カメラは、移動しない限り常に同じ風景の画像を撮影します。これにより、1台のカメラで撮影されるデータが非常に反復的(repetitive)になります。

十分なデータの変動性(data variability)がない場合、機械学習モデルは背景に注目する事を学習してしまう可能性があります。これにより、新たに画面内に写り込んだ物体への一般化が不十分になる可能性があります。

機械学習と生態学コミュニティは、LILA BCやWildlife Insightsなどの施設を通じて協力して、多くの研究グループの専門家がラベル付けしたトレーニングデータをまとめています。

トレーニングデータの変動性を高めるために、それぞれは1~数百の仕掛けカメラで動作しています。しかし、このデータ収集と注釈付け作業は時間がかかります。また、地理的地域や分類群全体にわたって多様で代表的なデータを用意する必要があるために混乱しています。

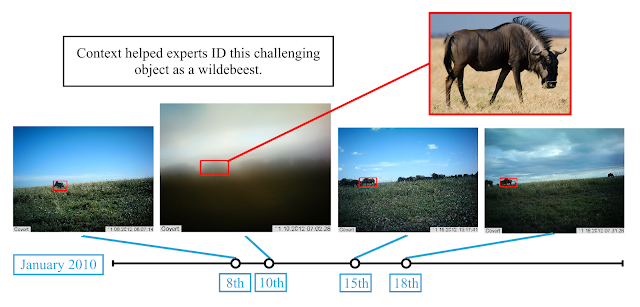

この画像には何が写っているでしょうか? 固定カメラから撮影された写真内の物体は、検出と分類が非常に困難な場合があります。この写真には、朝方に霧がかった丘の上を歩いているヌーの群れが写っていますが視認するのが非常に難しくなっています。(セレンゲティ国立公園のスナップショットから引用)

論文「Context R-CNN: Long Term Temporal Context for Per-Camera Object Detection」では、私達は補完的なアプローチを提示します。

新規に設置されたカメラの一般化能力をアルゴリズム的に改善することにより、生態学的モニタリングを幅広い地域に規模を拡大させる事が出来るようになります。

この新しい物体検出アーキテクチャは、時間の経過に応じて変遷する状況を、各カメラで手がかりとして活用します。これにより、多数のカメラからの追加のトレーニングデータに依存することなく、新規に設置したカメラに写り込んだ物体の認識能力を改善できます。

Context R-CNNは、判別が難しい画像に直面したときに人間の専門家が使用する手法を反映しています。すなわち、同じ固定カメラで撮影された最大1か月分の過去画像を参照して、写真に写り込んだ物体を特定し、識別します。

この手法により、モデルは、単一画像のみを対象とするFaster R-CNNモデルより優れた結果を出せます。野生動物の仕掛けカメラ画像含む複数の領域で大幅に性能を向上しています。

TF Object Detection APIの一部としてこの研究コードとモデルをオープンソース化し、新しい静的カメラデータセットでContext R-CNNモデルを簡単にトレーニングおよびテストできるようにしました。

上図では、同じ風景を違うタイミングで映した写真が、「写り込んだ物体が背景ではなく動物である」と人間の専門家が判断するためにどのように役立つかを確認できます。

物体の形状とサイズ、群れている事、特定の時間帯に習慣的に牧草地を訪れている事、など他の写真から読み取れる状況は、その種がヌーであると判断するのに役立ちます。このような有用な情報を提供する写真が一カ月を通じて発生します。

3.Context R-CNN:過去に撮影された写真を参照して仕掛けカメラの物体検出能力を改善(1/2)関連リンク

1)ai.googleblog.com

Leveraging Temporal Context for Object Detection

2)arxiv.org

Context R-CNN: Long Term Temporal Context for Per-Camera Object Detection

3)github.com

models/research/object_detection

コメント