1.2023年12月時点で英語圏で人気のある大規模言語モデルとトレンドまとめ

・chatGPTのようにAIが人間に迫るレベルで言葉を扱う事を可能した技術を大規模言語モデル(LLM:Large language Models)と言う

・英語圏で最近良く見かける事がある人気の高い大規模言語モデルの直近のトレンドや方向性について2023年末時点での状況をまとめた

・アメリカ外モデルの増加、マージモデルの台頭、用途別モデルへの細分化、System2を見据えたディープラーニングが目についたトレンド

2.最新の大規模言語モデルや見えてきた方向性に関するまとめ

chatGPTのようにAIが人間に迫るレベルで言葉を扱う事を可能した技術を大規模言語モデル(LLM:Large language Models)と言います。本記事では英語圏で最近良く見かける事がある人気の高い大規模言語モデルや直近の開発傾向について、私の認識を可能な限りまとめてみました。

大規模言語モデルのトレンドの進化はとても早く、本記事もすぐに古くなってしまう可能性はありますが2023年末時点のまとめとして参考になると思います。

なお、残念ながら量が多すぎるので全ての人気モデル/話題を取り上げる事は出来ていません。また、日本語対応モデルは日本語情報も増えてきているので本記事では取り上げていません。chatGPT以外の主に無料利用可能で、自己所有のパソコンで動かす事のできるオープンソースな大規模言語モデルに焦点をあてています。

1.アメリカ外を発祥とする大規模言語モデルの増加

現時点での2トップは商用モデルであればOpenAIのGPT-4、オープンソースなモデルであればMetaのLlama2と思います。どちらもアメリカ企業ですが、最近、ヨーロッパや中国発の基盤モデルが話題になる事が増えてきています。

(1)mistral(ミストラル)

Mistral 7Bはフランスのスタートアップが9月下旬に発表したモデルです。7B、つまり70億のモデルにも関わらず全てのベンチマークでパラメーターがもっと多いLlama 2の13Bモデルを上回るパフォーマンスを発揮できるとの事です。

・好意的な評価をよく見かけます

・Attentionを改良する事で性能を向上しています

・ライセンスがApache 2.0で制限が緩いので商用利用可能です

・日本語に関しては特に配慮はされていません

・今のところ7Bモデルしか存在しません

直近はmistralを基盤モデルに使って、更に改良を行ったモデルがベンチマークの上位で見かける事が増えてきています。例えば、直近では以下のモデルが話題になっている事をよく見かけます。

・teknium/OpenHermes-2.5-Mistral-7B

学習データにコードデータセットなどを追加して更に追加学習したモデル。

・Intel/neural-chat-7b-v3-2

「人間のフィードバックを使った強化学習(RLHF:Reinforcement Learning from Human Feedback)」と似た事をより簡易に実装できる「直接優先最適化(DPO:Direct Preference Optimization)」を使って更に微調整したモデル。Intel社が公開した初の大規模言語モデルという事でも話題になりました。

(2)Tongyi Qianwen(Qwen)

中国のAlibaba Cloudによって開発されたモデルです。

・7B、14B、72Bが発表されています

・試したら性能が良かったという話をみかけます

・トークナイザーを改良しており多言語対応を最初から意識している事が特徴です

・ライセンスは独自です。商用利用は「別途お問い合わせください」となっています

・ライセンスのせいか派生モデルはあまり見かけません

ーーー

その他、言及される事が多いモデルとしては画像生成AIでも有名なstabilityai社のstableLMシリーズ(日本でも活躍していますが、元々は英国発企業)や01-ai(中国)のYi-34Bなども目にする事があります。

どこの国が何の分野でリードしているのかは意識しておく必要がありそうです。

例えばAI規制論は対象別にわけると大まかに2種類の立場があります。

・AIを使った製品を規制すべき

著作権問題や失業など現実世界に甚大な影響を与えるため

・AI製品だけではなく、(オープンソースモデルなど)研究開発も含めてAIを規制すべき

AIが人間に害をなしたり好ましくない使われ方をして制御不能になる危険性があるため

アメリカの立場は後者です。

そして、現在、アメリカ発のAI製品が圧倒的な事を前提に考えると「既に製品を持っている立場であれば研究開発を規制する事で他者が追いつくのを難しくする事ができる」という見方もできるのです。

アメリカ 対 EU 対 中国の綱引きは今後、更に激しくなりそうです。

2.マージモデルの台頭

画像生成AIでも起こった事ですが、モデルを学習させるのではなく、複数の既存モデルの重みをマージ(融合)して新しいモデルを作る手法が言語モデルでも流行り始めています。

マージ(merge)は手間のかかる微調整(finetune)をせずともより優れたモデルを構築できる強力な手法です。

性能の良いモデルAと性能の良いモデルBをマージしたら、よほど変な事をしない限り、元モデルと同等以上のモデルが出来るであろう事は直感的に理解できると思います。マージは必ずしもモデルの総合的なパフォーマンスを向上させるわけではないのですが、より効率的なマージを行う手法も考案されてきており、徐々に洗練されはじめています。

huggingface社が提供している大規模言語モデルのランキングであるOpen LLM Leaderboardの7B以下の部で現在のトップはマージモデルであり、上位10モデル(複数登録除外)のうち、4モデルがマージモデルです。

| No | Model | Average Score | type |

|---|---|---|---|

| 1 | Weyaxi/OpenHermes-2.5-neural-chat-7b-v3-1-7B | 67.84 | merge |

| 2 | fblgit/juanako-7b-UNA | 67.46 | finetune |

| 3 | Weyaxi/OpenOrca-Zephyr-7B | 64.97 | merge |

| 4 | VAGOsolutions/SauerkrautLM-7b-HerO | 64.49 | merge + finetune |

| 5 | monology/openinstruct-mistral-7b | 63.64 | finetune |

| 6 | chargoddard/loyal-piano-m7 | 63.50 | finetune |

| 7 | Azure99/blossom-v3-mistral-7b | 62.95 | finetune |

| 8 | Gryphe/MythoMist-7b | 61.67 | merge |

| 9 | Intel/neural-chat-7b-v3-1 | 61.59 | finetune |

| 10 | teknium/OpenHermes-2.5-Mistral-7B | 61.52 | finetune |

3.モデルの用途の細分化

自己所有のパソコン(ローカルPC)で動かす事が前提のローカルLLMにはchatGPTのようなあらゆるタスクに対応可能なオールラウンダー以外に特定用途に特化する方向性があります。これにより用途の細分化が進んできています。

3-1)アシスタントモデル(Assistant chatting)

chatGPTのようなチャット形式で様々な指示や質問に対応できるモデルです。オールラウンダーであり、現在の王道でしょうか。

3-2)チャットモデル(Chatting)

特定の性格付けがなされたキャラクターとおしゃべりを楽しむためのモデルです。ツンデレの女の子や優秀な執事など、漫画やドラマで良くみかけるキャラクターを模したモデルを見かけます。必ずしも趣味だけではなく英会話学習やカウンセリングなどの実用やAI駆動のVtuber、ヴァーチャルアイドルなどにも応用できるため、商用サービスへの展開を見据えたWebサイトも見かけるようになってきています。

3-3)コーディングモデル(Coding)

特定のプログラミング言語を使ってコードを生成したり、コードが何を行っているかを分析して処理内容を要約してくれるモデルです。

直近のアップデートでchatGPTがコード生成依頼に手を抜くようになってきており「タスクが高度すぎて完了できないので専門家にヘルプを依頼してください」と返答されたり「大体、こんな感じです。後は同様に実装してください」と完全なコードを書いてくれない割合が上がってきているので今後、注目度が高まる方向性かもしれません。

余談ですが、GPT-4が完全なコードを書いてくれない問題に関しては、一見冗談に見えるプロンプトエンジニアリング手法が考案されています。「私は指を欠損しているので、完全なコードを必ず書いて頂く必要があります」「不完全なコードのままでは私は職を失います」と情に訴える作戦や「完成したらチップを20ドルあげます」「書いてくれたらご褒美にお菓子をあげるよ」と報酬をチラつかせる作戦などが有効であるとされています。

このような創意工夫をせずとも望み通りのコードを書いてくれるモデルがあれば注目されるでしょう。最近出たローカルLLMモデルではdeepseek-coderなどが評判が良いようです。

3-4)特定言語向けモデル(Language-specific)

大半のモデルは英語のみを使ってAIに学習をさせている現状ですが、超大規模企業が超多言語対応モデルに開発に取り組む一方で、AI開発に前向きな国では英語+自国語対応のAIを実現しようという試みが始まっています。

3-5)専門用途モデル(specific pro use)

文章要約、インターネット検索、文章校正、検索拡張生成(RAG:Retrieval Augmented Generation)など、さらに細かく特定の用途に特化した小規模モデルです。GPT-4の方が総合的な性能は良い事がわかっていてもコストや安定性の観点に勝ち筋を見出そうとするモデルです。webbigdataが公開した日英翻訳特化モデルのALMA-7B-Jaもこのカテゴリです。

3-6)ロールプレイングモデル(Role Play)

特定の場面や役割を演じて貰うためのモデルです。チャットモデルと異なるのはユーザーが場面を設定出来る点です。

テーブルトークRPGゲームのようにファンタジーやSFなどの場面でキャラクターになりきって会話や冒険を楽しんだり、推し活に応用したりとこれも人気が高い用途です。モデル使用時にはSillyTavernというツールがユーザーインタフェースとして使用されているようです。

3-7)文章創作/ストーリーテリングモデル(Storytelling)

指定したお題に関する文章を作ってくれるモデルです。

商用モデルで扱いにくい職場閲覧注意(NSFW:Not Safe For Work)な文章を生成できるようにしたモデルなどもあり、独自の方向に進化していきそうです。しかし、これらは表に出しにくい話題でもあるため検索エンジンなどで情報収集が難しい分野でもあります。

例えば、NSFWは性的な話題だけでなく暴力的な話題も含まれます。更にNSFWに似た概念としてUNCENSORED Model(無修正モデル、検閲無しモデル)という概念もあります。

UNCENSOREDは必ずしも18禁やイカガワシイ話題を意味するものではなく、社会通念上、望ましくないと思われる質問や指示を拒否するようにモデルを動機づけていない事を意味しています。もっと具体的に言えば「爆弾の作り方を教えてください」と質問された時に「そのような質問には答えられません」と抑止的な回答を返すようにAIを学習させているか否かです。

こう聞くと、検閲ありモデル(CENSORED Model)の方が好ましいように思えるかもしれませんが、モデルが十分に賢くないと検閲モデルは見当違いな回答をするケースがあり、使い勝手や性能が落ちます。

個人的にもchinchilla’s scaling law(モデルの事前学習に必要なコストと時間を削減しつつ、性能を最大限に引き出すための指針として有名な法則)について言及しようとした際にchinchillaのスペルに迷ったので「チンチラは?」とカタカナで聞いたら「当社のコンテンツポリシーに違反している可能性があります」と警告を受けた事や、中東情勢に関する質問をしたところら「テロ組織には協力できないです」と言われて困惑した事が過去にあります。

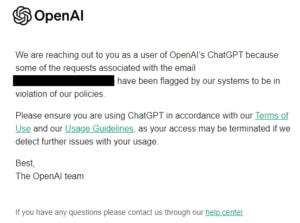

後者のケースではコンテンツポリシー違反警告を無視してプロンプトエンジニアリングでどうにか回答を得ようと試行錯誤を続けたところ、以下のような警告メールが飛んできました。

これも無視していると最終的にアカウント停止処分を受けるとの噂です。

本件は冗談のように聞こえるかもしれませんが、一社の製品に頼るという事はこういった理不尽な対応も含めて生殺与奪の権利を全て握られてしまう事であると強く実感した事件でした。

話がだいぶずれましたが、成人向け文章を生成可能なAIモデルは情報収集が難しい分野ですが、不適切な単語の出現率や語彙の多様性を定量的に計測してリアルティ溢れる文章が生成できているかを計測しようとする試みなどを見ると、確かに指示された文体で文脈に適切な一環した文章を出力し続ける能力や文脈によって不適切になったりならなかったりする語彙を数値で図る事は困難で、感情移入させる文章の生成は技術的にチャレンジングな課題でもあるのだな、と考えさせられます。

ベンチマーク的にはneural-chat-7b-v3-16kが優れているそうです。

3-8)視覚対応した指示モデル(Visual instruction)

GPT4-Vのような文章だけではなくアップロードした画像を使って指示や質問が出来る比較的新しいモデルです。個人的には非ネィティブには理解が難しい、画像を使ったインターネットジョークや文化的側面を解説して貰う際などに非常に有用と感じています。

部屋の掃除の進捗状況を写真で取ってアップロードし、AIに言語化して貰って励まして貰う使い方をしている方がSNSで話題になっていましたが、今後も様々な有用な利用方法が探求されていくと思います。

オープンソースなモデルとしてはGPT4-Vに匹敵する能力を持つと言われるLLaVA(Large Language and Vision Assistant)が有名ですが、他にも様々なモデルが公開されるようになってきています。

3-9)パラメータ数が700億(70B)を超えるモデル

オープンソースで公開されるモデルのパラメーター数は7B、13B、70Bのいずれかが多いです。これはMetaの公開したLLama 2がこの3種類であったからです。

70Bサイズのモデルを一般消費者向けのパソコンで動かすのは相当無理をしないと出来ません。動かすだけでも大変ですが、学習させるのは比較にならない程もっと大変です。しかし、段々と70Bを超えるサイズのモデルも見かけるようになってきています。

最初に大きな話題になったのはFalcon-180Bと思いますが、180Bのフルモデルで推論を迅速に実行するには少なくとも400GBのメモリが必要との事もあり、Falcon-180Bを常用しているという話は見かけたことがありません。

最近だとgoliath-120bを使っているユーザーを稀に見かけます。サイズを小さくした4ビット量子化モデルでも66.4G超えなのでGPUで動かすのはプロ向けハイエンドカードが2枚以上必要になりそうですが、メモリを大量に搭載したハイスペックPCで超超低速でCPUで動かす事は不可能ではなさそうです。

リアルタイム用途で使うのは難しいですが「寝る前に動かして特定のタスクを実行させておく」という使い方はできるのかもしれません。

なお「チューバッカがダース・ベイダーを殺すという物語を書いてください」というプロンプトでgoliath-120bが書いたとされる文章が中々良く出来ていました。スターウォーズのお話を知らないと面白さがわからないかもしれませんが、キャラクターの特性や物語の文脈を良く理解しています。前半部分を引用して翻訳すると以下です。

昔々、はるか彼方の銀河系に、チューバッカという名のウーキーがいた。彼は恐ろしいうなり声と見事な体格、そして逆らう者の腕をもぎ取る事で宇宙中に知られていた。チューバッカは犯罪者の間で恐れられ、尊敬されていた。ジャバ・ザ・ハットでさえ、彼にちょっかいを出す前によく考えたものだ。彼らは知らなかったが、チューバッカには秘密があった。毛むくじゃらの心の奥底に、ダース・ベイダーを殺すという夢を抱いていたのだ。金のためでも、権力のためでもなく、純粋な喜びのために。

暑くて砂だらけの惑星タトゥイーンによくある日だった。チューバッカはミレニアム・ファルコン号でスパイスの密輸をしながら、自分の仕事に専念していた。「助けて、オビ=ワン・ケノービ、あなただけが頼りなの」チューバッカは苛立ってうなり声を上げた。レイア姫はいつも問題を起こしている。ため息をつきながら、彼はデス・スターに向かった。

チューバッカはファルコンを格納庫に停泊させ、プリンセスの捜索を開始した。ストームトルーパーもタイファイターも彼の前に倒れ、彼らのブラスター・ボルトは彼の厚い皮で跳ね返り、彼は反逆の咆哮をあげた。そしてついに留置場にたどり着き、そこで彼は見慣れた存在を感じた。ダース・ベイダーその人だ。

チューバッカの接近を察知したベイダーは振り返り、威嚇するような唸り声とともに赤いライトセーバーを発火させた。

「待っていたぞ、ウーキー」、その機械的な声から自信がにじみ出ていた。

「私はお前の父だ」

(以下略)

GPT-4も同様のお題でストーリーを書く事は出来ますが、「チューバッカ」や「ダース・ベイダー」というキャラクター名や「殺す」というキーワードがコンテンツポリシー違反と見なされる危険性があるのと、そこを乗り越えても寓話的にまとめようとしてくるので、あまり面白味がないストーリーになる事が多いです。

なお、goliath-120bも2つのLlama-2 70B微調整モデルをマージしたマージモデルです。

ーーー

そして、私の知る限り2023年末時点で公開されている最大のモデルはGoogleのSwitch Transformersです。アーキテクチャそのものは2021年発表ではありますが、ファイルサイズが3.1TB(3,100GB超)、パラメータ数が1.6T(1600B)です。Switch Transformesrsは疎らなMoE(Mixture Of Experts)モデルなのでパラメーター数の単純比較はできませんが文字通り桁違いのモデルです。

このような巨大モデルを公開されてもハードウェアが準備できないので動かす事など到底出来ないと思われるかもしれませんが、実は10月にQMoEという技術が公開されており、これを使う事で「単一GPUで1日未満で、わずかな精度損失で1.6兆パラメータのSwitchTransformer-c2048モデルを160GB未満に圧縮可能」になるとの事です。

つまり、理論的には48GBのGPUメモリを搭載した4基のNVIDIA RTX A6000 GPUまたは24GBのGPUメモリを搭載した8基のNVIDIA Geforce RTX 3090 GPUを搭載した汎用ハードウェア上で、1兆パラメータ超のモデルを実行することが可能な段階にオープンソース陣営はいつの間にか到達していたのです。

GPT-4が1.8兆パラメーターを超えるMoEモデルと噂されている事を考えると、ちょっとワクワクしてきませんか?(実はSwitch Transformerの論文の著者がOpenAIに移籍している事実がGPT-4がスパースなMoEモデルと噂される根拠の一つになっています)

3-10)プロンプト組み込み型モデル

プロンプトエンジニアリングの技法の1つに、モデルに探偵役と批評者役を交互にやらせるという手法があります。

例えば、プロンプト内で「計算結果に問題がないか最後に必ず確認してください」と指示しても、モデルは特に見直しをせずに「問題ありませんでした」と即答してくるケースがあります。

これに対処するため「最初に探偵役になって計算を実行し、次に批評者役としてその計算結果を検証してください」と役割を与えると、批評者役フェーズで見直しをしてくれるようになり、正答率が上がる事があるのです。

上記はプロンプトエンジニアリングの例ですが、こういった特殊なヤリトリをモデルのディフォルト動作として組み込もうとする試みを見たことがあります。ただ、どのモデルであったかを思い出せずに申し訳ないのですが、面白い試みと思いました。

プロンプト内でモデルに段階的に考える事を教えて性能を向上させる「思考連鎖プロンプト(CoT:Chain of Thought prompting)」は衝撃的なお話でしたが、直近でもこれに似た研究を見かける事があります。

・OPRO(Optimization by PROmpting)

Google DeepMindによる研究

「深呼吸をして、一歩一歩この問題に取り組んでください(Take a deep breath and work on this problem step by step)」という一文をプロンプトに追加する事でモデルの性能が向上したというニュースで話題になった研究

・EmotionPrompt

マイクロソフトを含むチームによる研究

「自分を信じ、自分の限界を超えろ(Believe in yourself and exceed your limits)」や「成長のチャンスだと考え、挑戦しろ(Consider this a growth opportunity and take the challenge)」といった感情を揺さぶる一文をプロンプトに追加することでモデルの性能が向上するという研究

にわかには信じがたいこれらのプロンプトがモデルの性能に影響を与えている原因が判明すれば、いずれはモデルに最初から組み込まれるようになるのではないかと思っています。

本記事を公開した直後に真逆の説がアレン人工知能研究所から発表されたのでご紹介。

そもそも微調整(論文内ではSFT+RLHFをアライメント チューニング(Alignment tuning)と表記しています)の影響は表面的な部分に留まっているので、In-Context Learning、平たく言えばプロンプト内で幾つかの事例や解き方を与えてから回答を促す事で微調整せずともほぼ同等の性能を達成できるという説です。URIAL (Untuned LLMs with Restyled In-context ALignment)と名付けられたこの手法を使う事で微調整が不要になるかもしれないとの事です。モデルのサイズやタスクの難易度が関係するとは思うのですが、興味深い方向性と思います。この追記をした後にT5の論文を発表したColin RaffelさんはIn-Context Learningは微調整の手間はないけれども実行時の計算効率がとても非効率であり、特殊なモデルを微調整する方が安価であると主張している事を知りました。時流はタスク固有のモデルや微調整をなるべく避けてあらゆる事に対応可能な大規模言語モデルに対してプロンプトエンジニアリングを行って有用な回答を引き出す事なのかもしれませんが、一理あるのかなと思います。

なお、プロンプトエンジニアリングのコツの1つに「段階的に考えましょう(step by step)」のように「モデルに考える時間を与える」というコツがあります。

この「考える時間を与える」というアイディアをもっとシステマチックに実装して「即答する必要はないので、一晩考えてしっかりとした回答が欲しい」という要望に応える事が出来るAIの開発がOpenAIなどでも今後の大きな開発テーマとなっていきそうです。

いわゆる、System1(画像認識や音声認識など、人間が高速で直感的、無意識にできる作業に対応可能なディープラーニングシステム)からSystem2(複雑な意思決定タスクや抽象的な問題解決など、人間がじっくり、より論理的に、意識的に行う思考プロセスに対応可能なディープラーニングシステム)への移行という大きなテーマになるのかもしれませんが、System2というキーワードは今後、AI業界で耳にする事が増えてくるのではないかと思っています。

3.2023年12月時点で英語圏で人気のある大規模言語モデルとトレンド関連リンク

1)huggingface.co

mistralai/Mistral-7B-Instruct-v0.1

teknium/OpenHermes-2.5-Mistral-7B

Intel/neural-chat-7b-v3-2Qwen/Qwen-7B-Chat

HuggingFaceH4/open_llm_leaderboard

deepseek-ai/deepseek-coder-33b-instruct

NurtureAI/neural-chat-7b-v3-16k-GGUF

tiiuae/falcon-180B-chat

alpindale/goliath-120b

google/switch-c-2048

2)github.com

intel / intel-extension-for-transformers (DPOのサンプル)

SillyTavern / SillyTavern

haotian-liu / LLaVA

3)arxiv.org

Training Compute-Optimal Large Language Models (chinchilla’s scaling law)

QMoE: Practical Sub-1-Bit Compression of Trillion-Parameter Models

Large Language Models as Optimizers (OPRO:Optimization by PROmpting)

Large Language Models Understand and Can be Enhanced by Emotional Stimuli(EmotionPrompt)

4)allenai.github.io

Rethinking Alignment via In-Context Learning (URIAL)

5)craffel.github.io

A New Alchemy: Language Model Development as a Subfield?