1.インターネット上の画像から三次元構造を再構築するコンペの開催まとめ

・一連の二次元画像から三次元データとして物体を再構築する事をStructure-from-Motion(SfM)と言う

・SfMでは、窓枠の角部分など「局所的な特徴(local features)」を確実に識別できる事が需要となる

・局所的な特徴は従来は評価が難しかったがImage Matching Benchmarkが発表されコンペも開催

2.Image Matching Challenge 2020とは?

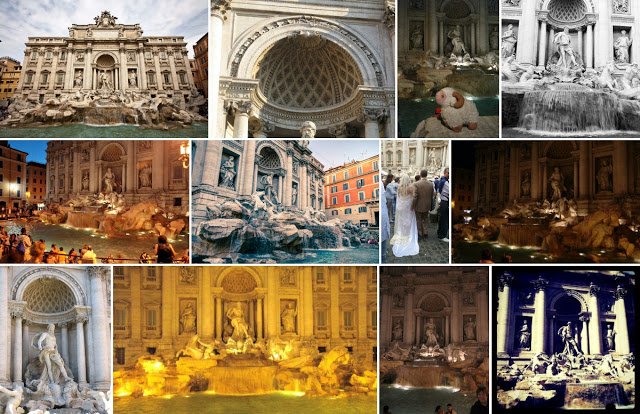

以下、ai.googleblog.comより「Announcing the 2020 Image Matching Benchmark and Challenge」の意訳です。元記事の投稿は2020年4月2日、Eduard Trullsさんによる投稿です。トレビの泉って名前だけは聞いた事があって、単なる泉と思っていましたが建物が壮大なんですね。サンプル画像に泉が全く写ってなくて困惑したのでちゃんと泉が写っている写真として選んだアイキャッチ画像のクレジットはPhoto by Andrey Omelyanchuk on Unsplash

一連の二次元画像から三次元データとして物体や建物を再構築する事をStructure-from-Motion(SfM)と言います。

SfMはコンピュータービジョン分野の良く知られた問題で、文化遺産の保存(例えば、イースター島のモアイをブラウザで三次元表示できるようにする事)など、写真を様々な形で応用する事ができます。

Googleマップの多くのサービスも、ストリートビューや航空写真から作成された3Dモデルなど、SfMによって機能強化を実現しています。

こういったケースでは、画像は通常、制御された条件下で専門のオペレーターによって撮影されます。これにより、画像と最終的に再構成された物体が均一で高品質な外観を持つ均一なデータになる事が保証されますが、対象物の外観の多様性と視点も制限されます。

厳密に制御された状態で撮影された画像を使用する代わりに、SfM手法を適用して、インターネットで無料で入手できる膨大な量の画像を使用して、世界の豊かさをより良く捉えられるようになるとしたらどうでしょうか?

このトピックの研究を加速し、すでに公開されている大量のデータをより有効に活用するため、UVIC、CTU、EPFLとコラボレーションして「Image Matching across Wide Baselines: From Paper to Practice」を発表します。これは三次元データの再構成法を評価するための新しいパブリックベンチマークで、これは、CVPR 2019で開催された最初の「Image Matching: Local Features and Beyond」に続くものです。

このプロジェクトには現在25,000枚を超える画像が含まれており、それぞれに正確なポーズ情報(位置と向き)が含まれています。このデータは、オープンソースのベンチマークとともに公開されており、CVPR 2020で開催される2020 Image Matching Challengeの元データとなっています。(注:新型コロナウイルスパンデミック下ではありますが、CVPR 2020は2020年4月2日時点では開催予定に変更はありません。しかし、スケジュールは2020 Image Matching Challengeのウェブサイトでご確認ください)

現実世界のデータを用いて3D構造を回復

Googleマップでは、ユーザーから提供された画像を使用して、人気のある場所をユーザに知らせたり、営業時間を更新したりしています。

ただし、このタイプのデータを使用して3Dモデルを構築することは、提供された写真に様々な視点、照明と気象条件、人や車両などの遮蔽物、および時折ユーザーが適用する画像効果があるため、はるかに困難です。

以下の例は、ローマのトレビの泉の画像の多様性を強調した例です。

Image Matching Challengeデータセットから抽出したくつかのサンプル画像

トレビの泉を様々な視点から見ています。

一般に、3D構造を再構築するSfMでは、窓枠の角部分など、個々の画像のどの部分が再構築したい風景内で同一物理ポイントを示しているのか識別する事から始まります。

これは、「局所的な特徴(local features)」、つまり、異なった視点であっても確実に識別できる画像内の目立つ場所を使用して実現されます。「局所的な特徴(local features)」には、関心のあるポイントの周りの外観を捕えるshort description vectors(model representations)なども含みます。これらの特徴を比較することにより、2つ以上の画像間で特定画素同士の座標を対応付けて、三角測量の原理によって3D位置を復元できます。

次に、画像が撮影された場所からのポーズと、観測された物理点の3D位置(例えば、窓枠の角部分がカメラの位置に対してどこにあるかを識別)の両方を一緒に推定できます。以上を多くの画像と点に対して行うと、非常に詳細な再構成を取得できます。

前述のサンプル画像を含む、3000を超える画像から再構築されたトレビの泉の3D構造

このアプローチの課題は、たとえば建物の窓など、非常に類似した構造が繰り返されていると、誤った対応付けが行われるリスクです。また、トレビの泉を眺めている群衆など、特定の画像にしか現れない一時的な要素も考慮が必要になります。

これらを除外する1つの方法は、複数の画像を使用して対応関係を推論することです。

更に強力なアプローチは、例えば人物などの一時的な要素を無視するために、「局所的な特徴」を識別および分離するより良い方法を設計することです。

ただし、SfMの既存の局所的な特徴抽出アルゴリズムの欠点をよりよく理解し、将来の研究の有望な方向性を洞察するには、パフォーマンスを測定するための信頼できるベンチマークが必要です。

「3D再構成を行うための局所的な特徴」の評価用ベンチマーク

局所的な特徴を見つける技術は、画像検索やGoogle Lensの製品認識など、多くのGoogleサービスを支えています。GoogleマップのLive Viewなどの複合現実アプリケーション(mixed reality applications)でも使用されていますが、手動で設計された伝統的なアルゴリズムも使っています。そのため、局所的な特徴を識別および説明するためのより優れたアルゴリズムを設計すると、全体的なパフォーマンスが向上します。

ただし、従来は「本当の局所的な特徴」をデータとして収集する方法が明確でないため、局所的な特徴を捉えるアルゴリズムのパフォーマンスを比較する事は困難でした。

一部のコンピュータービジョンタスクはインターネット上で作業者を募るクラウドソーシングにデータ収集を依存しています。GoogleのOpen Imagesデータセットは、機械学習技術と人間の注釈作業者を組み合わせて、境界ボックスやまたは画素レベルで識別対象の物体にラベルを付けています。局所的な特徴の場合、この手法は不可能です。何が「優れた局所的な特徴」であるのか、普遍的なルールがわかっていないため、ラベル付けが不可能なためです。

更に、HPatchesなどの既存のベンチマークは、多くの場合、小規模であるか、変換範囲が限定されているため、評価にバイアスがかかる可能性があります。

重要なのは3D再構築された結果の品質であり、望ましいベンチマークは、新しいアプローチを開発する機会を強調するために、現実世界の規模と課題を反映する必要があります。

この目的のために、学習と評価のための大規模な画像データセットを含む最初のベンチマークであるImage Matching Benchmarkを作成しました。

データセットには、25,000を超える画像(YFCC100mパブリックデータセットからの提供)が含まれており、それぞれの画像には正確な姿勢情報(位置と向き)が追加されています。

この正確で安定したポーズを「疑似的な局所的な特徴」として、を大規模なSfM(シーンごとに数百~数千の画像)で提供します。そして、小さなサブセット(数十の画像)で評価を実行します。これははるかに難しい問題となります。

このアプローチは、高価なセンサーや人間によるラベル付けを必要とせず、小規模で均一なデータセットに制限されていた以前のベンチマークよりも優れた代替評価基準を提供します。

ベンチマークとするアルゴリズムによる可視化

様々な局所的な特徴アルゴリズムによって生成されたポイントツーポイントの一致を示します。

左からSIFT、HardNet、LogPolarDesc、R2D2。 詳細は下部のbenchmarkリンクをご覧ください。

このベンチマーク、データセット、および課題が、不均質な画像を使って3D構造を再構成する最先端技術の進歩に役立つことを願っています。チャレンジへの参加に興味がある場合は、2020 Image Matching Challenge のウェブサイトで詳細をご覧ください。

謝辞

このベンチマークは、Yuhe Jin and Kwang Moo Yi(University of Victoria), Anastasiia Mishchuk(EPFL), Pascal Fua(EPFL), Dmytro Mishkin(Czech Technical University), Jiří Matas(Czech Technical University), Eduard Trulls(Google)による共同作業です。

CVPRワークショップはVassileios Balntas(Scape Technologies / Facebook), Vincent Lepetit(Ecole des Ponts ParisTech), Dmytro Mishkin and Jiří Matas(Czech Technical University), Johannes Schönberger(Microsoft), Eduard Trulls(Google), そしてKwang Moo Yi(University of Victoria)が共同で主催しています。

3.インターネット上の画像から三次元構造を再構築するコンペの開催関連リンク

1)ai.googleblog.com

Announcing the 2020 Image Matching Benchmark and Challenge

2)vision.uvic.ca

Image Matching Challenge 2020

Benchmark

3)arxiv.org

Image Matching across Wide Baselines: From Paper to Practice

コメント