1.GPUの需要と供給から考える2024年以降のAI開発の傾向と対策まとめ

・アメリカの対中国の半導体輸出規制の影響は価格を落ち着かせるのではなく高騰に拍車をかけそう

・法人/データセンター向けGPUは品不足が続きそうだが個人向けが同様に盛り上がるかはわからない

・しばらくは耐える時と考えて大量のGPUがなくても出来る事を模索するのも戦略として有効かもしれない

2.GPU不足はいつまで続きそうか?

最近、日本でもAI開発者/企業がGPUを思う通りに確保できないと嘆く声を見かける事がよくあります。

確かに、私自身も以前に比べて、クラウドでGPUが確保しにくくなったと感じています。使いたいのにクラウドで空いているGPUを見つける事ができない、もしくは以前より時間単価が高くなっているのです。

有料版のGoogle ColabではA100を指定してもV100が割り当てられる事が増えてきており、GoogleクラウドのSpot GPU(割り込みを受けるが通常より安い価格の契約)の価格表からA100が消えました。

この状況は何時まで続くのか?現在の状況をまとめつつ取りうる戦略について考えてみました。

まず、現在の状況整理から

1.アメリカの対中国の半導体輸出規制の影響

過去の経緯

2022年10月。先端半導体および半導体製造装置の中国への輸出を制限する規制措置が導入され特定の性能を超えるGPUは輸出に許可が必要になりました。

NVIDIAのデータセンター向けの最先端GPUであるH100とA100がこの規制にひっかかり、NVIDIAはわざと性能を落としたA800とH800というGPUを発表してこの規制を回避しました。

中国企業の対応は以下でした。

・アリババ、バイドゥ、バイトダンス(TikTok運営企業)等の大企業は何十億ドル分ものA800チップを発注

・第三国にクラウドサービスを立ち上げてそこでGPUを購入して利用する事で回避する動きもあった

つまり、規制はされたけれども簡単に回避できるレベルだよね、と思われていました。

今年、2023年10月に更にこの半導体規制が強化されました

中国および国グループ D1、D4、および D5(サウジアラビア、アラブ首長国連邦、ベトナムを含むがこれらに限定されませんがイスラエルを除く)への輸出に追加の許可要件が課されます。特定の性能しきい値を超える集積回路 (A100、A800、H100、H800、L40、L40S、および RTX 4090 を含みますがこれらに限定されません)。

今回、個人向けの最先端GPUであるRTX 4090も規制対象になったという事が話題になっていましたが、原文には「~を含むがこれらに限定されない(including but not limited)」と表現が二回でてきます。

そう、今回対処になったのは中国だけではないのです。

グループ D1は旧共産圏の国、グループ D4は大量破壊兵器(ミサイル)の懸念国、グループ D5は一般的な武器禁輸対象国群です。

具体的にはサウジアラビア、アラブ首長国連邦、パキスタン、イラン、ロシア、ベラルーシ、ベトナム、カンボジア、エジプトなども対象になります。

特にサウジアラビアやアラブ首長国連邦は今年の夏頃にGPU争奪戦に参入したという報道があったくらいなので、購入の意思があり、お金も持っていそうな国です。

サウジアラビアはエヌビディアのH100チップを1個あたり4万ドル(約582万円)で少なくとも3000個購入し、一方、UAEは自国の大規模言語モデル(LLM)を強化するために新たな半導体を発注したという。

そして今回の規制は2023年10月17日(火)に発表され、当初、施行日は通常通り発表から30日後と思われていましたが、23日(月)に突然「即時発効する」とNVIDIAに通知があったとの事。

早まった理由は不明との事ですが「駆け込みは許さない」というアメリカの強い意志を感じます。

NVIDIA CFOのColette Kress氏は、証券取引委員会(SEC)への提出書類の中で、米国政府が月曜日に暫定最終規則が「即時発効する」とNVIDIAに通知…

つまり

・規制対象になった国には中国以外にもお金持ちの国が含まれています

・おそらく駆け込みに失敗した大口需要先がいます

2.今後のGPU市場で起こりそうな事

欲しいものが買えなかったお金持ちは我慢するのではなくて非正規の流通手段に頼る可能性が高いです。

NVIDIAの既存売上の中国向け割合は2割程度と言われていますが、2割が規制対象外の国に出回って価格が落ち着く可能性より、規制対象国が札束ビンタ作戦を開始し、その結果、非正規市場でGPU価格が高騰し、その影響が正規市場にも影響を及ぼしてGPU高騰は来年まで続く可能性が高いと思われます。実際、中国では既にRTX 4090の価格が高騰したというニュースもあります。

これにより

・世界中からアクセスが容易なパブリッククラウドはまだしばらく混雑と値上げが続く

・通貨が安い国(我が国等)にGPU買占めツアーが起きる

事などが考えられます。

上記理由により、高性能GPUの数を揃えるのが更に難しくなるので多数のGPUを必要とする大規模モデルの開発は困難な時期が続くと予想されます。

しかし、個人向けGPUはそうでもないだろうな、とも考えています。「2024年は生成AIがパソコンやスマートフォンの新しい需要を牽引し、AI搭載のパソコンやスマートフォンが売れる!」という予想を見かける事がありますが、世間一般がイメージしている凄いAI、話題のAIは動かすためにGPUが数十~数千台必要な大規模モデルでありご家庭のパソコンでは動かす事はできません。

凄いAI、話題のAIはインターネット経由でクラウドに接続して使うようになっている事が多いので、所有しているパソコン自体にGPUが搭載されている必要はないのです。

もちろん、Llama2やStable Diffusionなど個人向けパソコンで動く素晴らしい生成AIはありますが、一般の人はchatGPTと雑談したり、DALL E3でイラストを無料で生成できれば十分満足するでしょう。

最近のイラスト生成AIはGPUメモリを従来より多く要求するので新しいPCが欲しいという人は多少は増えるかもしれません。しかし、昨年まで存在した仮想通貨マイニング需要の代替になるほどの規模ではなさそうですし、通常のパソコンより高い15万~50万円程度の高性能パソコンを購入してまで、生成AIをやろうとする人がどれだけいるか?と考えると、(買占めツアーの影響で多少は値上がりするかもしれませんが)私は少し懐疑的です。

また、現在、独自の大規模AIを作ろうと計画している企業/団体/国は少なくないとは思うのですが、最終的に完成した後の運用フェーズで本当にビジネスとして成立させる事が出来るのかと言う点もやや疑問があります。

既存のchatGPTを代表とするAIサービス群は、価格が安すぎて、性能が良すぎて、進化が早すぎるのです。

原価割れしているという噂も聞く事があるので、超大企業群が収支度外視で覇権争いをしている中に割って入るためにはかなりの体力とマーケティング力が必要になる事が予想されます。

後述のB100が発表される来年中頃には諦める人達も増えてきて、4世代前扱いになるA100等のGPUには空きが出てくるのではないでしょうか。

3.最新のNVIDIAのGPU発売ロードマップから未来を考える

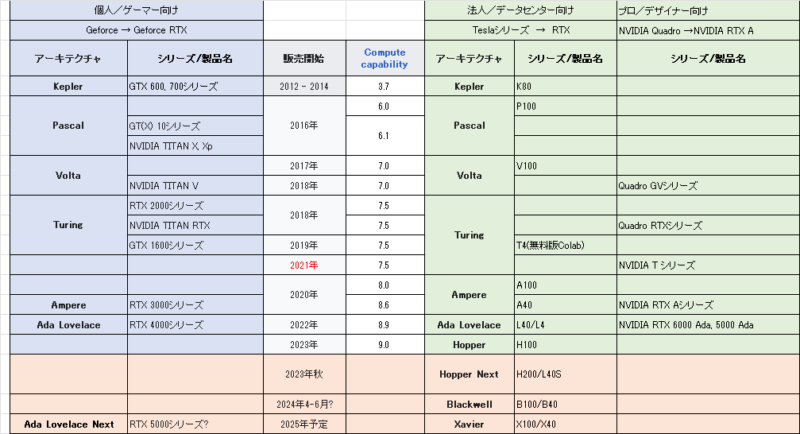

改めて現在のNVIDIAのGPUのロードマップをまとめてみると以下です。

NVIDIAの製品群は大別すると3つ。個人向け、法人(データセンター)向け、プロ向けです。

何度かリブランドが行われているため、製品名を見ただけではそれがどの市場向けなのか不明なケースもあり、わかりにくく、確定していない情報も含まれていますが、並べると意外に気づきがあります。

・以前は法人向け製品と個人向け製品のアーキテクチャは同一だったが、今後は分かれる

・データセンター向けの次期GPUであるBlackwell、B100は2024年前半に前倒しされるという噂

・V100はクラウドでは未だに結構お高いですが世代でいうと消費者向けRTX 2000シリーズより更に前の世代のVoltaアーキテクチャ

・大規模言語モデル(LLM)系AIだとアーキテクチャがAmpere以降か否かで効率に違いが出るのでA100は人気がある

・Compute Capabilityはあまり意識した事ないかもですが、CUDA固有の命令セットを使ってるソフトウェア(autoAWQなど)では特定のCompute Capability値以上でないと使えない時がある。そのため安易に古い中古GPUを買うのは危険

・同じ名前であっても搭載メモリ量/種類が異なる場合などもあり、よくよく確認する事が必要

・稀に見かけるA40は実はA100よりCompute capabilityが上

・NVIDIA Tシリーズは2021年発売だがアーキテクチャはAmpereではなくTuring

改めてNVIDIAのGPUの各ラインナップを説明すると以下です。

1.個人/ゲーミング市場向け製品

主に個人向け。ゲーム、グラフィックデザイン、実況配信、少し前は仮想通貨マイニングなどにも使われたラインナップ。昔はGeForce、現在はGeForce RTXシリーズと呼称されており、最新は2022年に発表された4000シリーズ。一世代前は3000シリーズ、二世代前は2000シリーズとなる。高価格モデルが必ずしもGPUメモリが多いわけではありませんが、搭載メモリは高価格帯の方が速度が速い種類のメモリを使っています。

下二桁がシリーズ内の位置づけ/性能を表す

4090 24GB フラグシップモデル 20万円~30万円くらい

4080 16GB ハイエンドモデル 10万円台後半から20万円くらい

4070 12GB ハイエンドモデル 10万円台後半くらい

4060 8GB/16GB ミドルエンドモデル 7~10万円くらい

4050 ローエンドモデル まだ未発売だがおそらく5万前後

従来は2年毎に新しいラインナップが発表されていましたが、次世代GeForce RTX 5000シリーズは一年延びて2025年以降の発売になりそうとの事。また、規制発効後の中国向けを意識したのかRTX 4080のメモリを増設した派生版を4080 SUPERとして新しく発売するという噂もあります。

イラスト生成AIを使って各GPUの性能を比較した記事は「イラスト生成AIのStable DiffusionはどのGPUで実行するのが最速か?」にあります。

なお、複数枚のGPUを使用する際にはNVLinkやSLI(Scalable Link Interface)という仕様に対応しているGPUカードが必要と誤解されている方がいます。NVLinkやSLIはグラフィック用途で使用する際に必要になる技術で、機械学習/AI用途で利用する場合は「対応しているGPUカードだと効率が上がる」くらいで使えないというわけではないです。

2.法人/データセンター市場向け製品

主に法人向け。データセンターやクラウド/サーバー用途向けのラインナップだがクラウド経由でGPUを使っている人には馴染みがある製品群。個人向け製品と異なりグラフィックス関連の機能が削除されています。

高度な計算処理能力が必要な場合、特に人工知能(AI)や高性能計算(HPC)の研究でよく使用されます。以前はNVIDIA Teslaシリーズと呼称していましたが、最近はTeslaがつかない事が多いです(例:A100 Tensor Core GPU)。

個人向け製品群のGeForce RTXシリーズが仮想通貨マイニング需要が消えたのと価格高騰のためあまり売れなくなったためか、今後はこちらのデータセンターやクラウド用途のラインナップに今後は力を入れていく模様。価格は数百万円規模。

V100 16G/32G (16G版はColab有料版で選択可能なGPU)。ちょっと前までは憧れだった。

T4 16GB (Colab無料版で使われているGPU)。比較的お安く利用できるので有能。

A100 40GB(Colab有料版で選択可能なGPU)。現在大人気。

A100 80GB 一部クラウドで利用可能だが空きを見かける事は少ない。

L4/L40 24G/48G まだあまり存在自体を見かけない。しかしねらい目な気はする。

H100 80GB 一番新しい。現在、沢山確保できている会社は「ウチにくればH100が沢山使えるよ~」と求人に使っていたりする。空きを見かける事は少ない。空きがあっても高い。

ちなみにOpenAIの次世代大規模言語モデルであるGPT-5の学習にはH100が50万台必要になるかもしれないというかなり根拠がアヤシイ噂話があります。50万台は流石におおすぎと思いますが次世代超大規模言語モデルは数万~数十万台規模のGPUを必要とする作業になる可能性はあります。

3.プロ/デザイナー市場向け製品

主にプロ向け。プロフェッショナルなデザイン、エンジニアリング、医療画像処理、3Dレンダリング、データサイエンス、AI研究などを想定したラインナップ。

・個人向けのGeForce RTXシリーズと比べるとメモリが多め(24GB~48GB)だがお値段もかなり高めで70万円~200万円くらいです

・自分の持っているGPUを使ってない時に時間貸しする仕組みであるコミュニティクラウドなどでは時間貸しされているGPUをよく見かけます

・個人向けのGeForce RTXシリーズはNVIDIAがお手本となるGPU搭載グラフィックカードを発表し、各メーカーがそれを参考に独自設計を行いGPU搭載グラフィックカードを作って販売していますが、プロ向けはNVIDIAだけが発売しています

・以前はQuadroシリーズとして知られていた製品群は、RTX Aシリーズ(例:NVIDIA RTX A6000)としてリブランドされましたが、直近ではAがつかない命名(例:NVIDIA RTX 6000 Ada)も発表されており、個人向け製品群ととても見分けがつきにくくなっています。

敢えていうなら以下で見分ける事が出来ます。

・個人向け製品群は製品名にGeForceが付く事が多い

・個人向け製品群は40X0のように下二桁に何らかの数値が付く

GPU Poorについて

英語圏では持つものと持たざるものの差を自嘲してGPU Poor(GPU貧者)という表現を目にする事があります。

とはいえ、自らをGPU Poorと自嘲する人が普通に前世代のフラグシップモデルであるRTX 3090を複数枚使っていたりプロ向けのNVIDIA RTX A6000を使っていたりするので、私がメインで使っている前世代のミドルスペックモデルのRTX 3060 12GBではGPU Poor仲間にすら入れて貰えないのではないかという気はします。

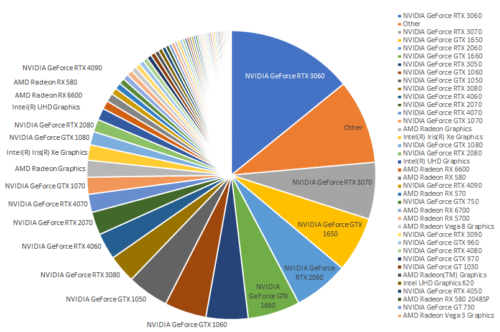

しかし、AIをやってると高性能GPUを持っているのが当然に思えてきますが、パソコン用ゲームの配信プラットフォームであるSteamの2023年9月度のハードウェアシェア調査を引用すると以下です。

高性能版であるTIやSUPER、ノートPC向けであるLaptopなどの細かい派生モデルを1つにまとめた結果です。

SteamはコアなPCゲーマーに人気のあるサイトなので一般の方よりパソコンにお金をかけている人が多いと思うのですが、それでも比較的安価なRTX 3060が実はシェア一位であり、7年前のGTX 1000シリーズがまだトップ10に入っています。RTX 4000シリーズも価格が安いので性能が低く比較的評判の悪い4060がトップです。

コアなPCゲーマーがこれなのですから、一般の人がAI搭載パソコンにこれ以上のスペックを求めるかというとやっぱり、何らかのキラーAIアプリケーションが出ない限り難しいでしょう。自己所有パソコンで動かす前提のAIを開発する方はこれらの現実を念頭に置いた方が良いのではないかと思っています。

NVIDIA以外の選択肢

NVIDIAがGPUの世界で絶対王者なのは昔からソフトウェアに投資をしていたからです。

具体的にはCUDA(Compute Unified Device Architecture)というソフトウェアでGPUの性能を引き出す事が出来るのと、AI関連のツールはNVIDIAを前提にしているケースが多いのでノウハウの蓄積が多いのです。

しかし、CUDAの牙城はそんなに盤石ではないのかな、という気が最近してきています。

実は大規模言語モデル(LLM)を動かす際の主要なボトルネックはメモリ帯域帯と言われていて、遅いメモリを搭載しているGPUはCUDAがあろうがなかろうが、パフォーマンスで負けます。

CUDA固有の機能を使うと凄い事が出来る!という話を聞く事もありますが、Compute Capabilityの問題で古いGPUでは使えなかったり、超高速というフレコミであっても実は別途コンパイルなどの作業が必要で手間がかかったりするのです。

pytorchやhuggingface等のフレームワークが他社製品を積極的にサポートしはじめたらNVIDIAでなくてはならない理由はほぼなくなります。実際pytorchのリード開発者も以下のように言っています。

その他、直近、目についたGPU関連のニュースは以下です。

AMD Scores Two Big Wins: Oracle Opts for MI300X, IBM Asks for FPGAs

・OracleクラウドがAMDのInstinct MI300Xシリーズの導入を決定

NVIDIAのH100が十分に確保できなかったからだとは思いますが、AMDのInstinctシリーズは結構性能良さそうで、トレーニング時間を比較してNVIDIA製品同等以上の性能がありそうだと感じた事があります。NVIDIAのCUDAに相当するAMDのROCm(Radeon Open Compute platform)はツールを使ってCUDAのコードを変換する事が出来るとの話なので代替手段としての存在感は今後、増していくかもしれません。

・IBMがAMDが買収したXilinx社のFPGA(Field-Programmable Gate Array)をAI関連処理に採用

FPGAはユーザーがプログラム可能なデジタルロジックチップなので、特定の計算タスクに特化したハードウェアを設計してAI関係の処理を高速化しようという考えだと思います。

インテル、Meteor Lakeの発売に先立ってブランドの大幅なアップデートを発表

15年ぶりの大幅なブランド・アップデートにより、インテル® Core™ ブランド、インテル® Evo™ ブランド、インテル® vPro® ブランドの新時代が到来・・・

2023年後半より前評判が高いMeteor Lakeが搭載された製品が出荷されます。

GPU(Graphics Processing Unit)はその名の通り、元々はグラフィックを処理する装置ですが、Meteor Lakeでは、「NPU(Neural Processing Unit)」として、AI向けの行列演算器がグラフィックス処理から完全に切り離され、CPUと同一半導体チップに組み込まれます。

通常、CPUでAIを動かすとGPUに比べて莫大な時間がかかります。そのため、上記の発表を胡散臭く感じる人もいるかもしれませんが、現在でもINTELのサーバー向けハイグレードCPUはStable Diffusionや7B(70億)くらいの大規模言語モデルならば十分高速に動かす事ができ、これはHuggingFaceのINTEL社のSpaceなどで体感する事ができます(末尾リンクあり)。とはいえ、サーバー向けハイグレードCPUは、個人向けフラグシップモデルのGPUが買えてしまうくらいのお値段なのと、必要メモリが大きくなると非常に処理が遅くなるらしいので、現時点ではGPUの代替選択肢になるとまでは言えませんでした。

しかし今回、INTELも15年ぶりの大幅ブランドアップデートという事で、Meteor Lakeが従来製品よりどれだけ優れており、具体的にどんなアプリケーションが動かす事が出来るようになるのか期待は高まります。

「エヌビディアもアームも不要」、CPU設計の大御所がAI専用機を開発中

・日本にも支社があるカナダのチップ設計スタートアップ、テンストレント社(Tenstorrent)が、先行する巨大半導体企業を逆転すると張り切っているとのお話。Tesla、Apple、AMD、Intelなどを渡り歩いた有名なCPUアーキテクトが設立した会社との事で注目度は高いようです。

このようにNVIDIA以外の選択肢、選択する事例は増えてきており、AMD、Intelは当然の事ながらGoogleは既にTPUとして製品化、Amazonもかなり前から自社チップに関する発表はしており、Microsoftも2019年から、OpenAIも独自の半導体の開発に乗り出すと報じられています。AIチップ開発用のベンチャーも沢山いるので選択肢は今後も段々と増えてくると思われます。

・・・

結論としてGPUの価格高騰はもうしばらくは続きそうですが、一強状態が永遠に続くというわけでもなさそうです。そのため、現在取り得る戦略は

・(下手をしたら国家間レベルの争いになる)札束ビンタ合戦に乗り出す

・NVIDIA以外の選択肢を検討する

・耐える時と考えて他の事をする

・小規模モデルに集中する

・大量の高性能GPUを必要としない手法に集中する

事ではないかと考えています。

色々と調べたり書いているとやっぱり高性能GPUが欲しくなってきますが、人間の欲望には限りがないので究極的には3つの環境が欲しくなるはずです。

1)普段使い用

2)モデルのトレーニング用

3)トレーニングしたモデルの性能を確認するベンチマーク用

更に言うと、Abration Study、つまり「今回はAとBとCという改良を行ったけれども、どの仕組みがどれだけ性能アップに貢献したのだろうか?」を調べる為には「BとCだけやったモデル」や「AとCだけやったモデル」など沢山のモデルを作って比較する事が必要になるため2)と3)のペアはあればあるだけ良いです。

しかし、現実的にはどこかで妥協をしなければなりません。

私は1)の用途限定として考えればシェア No1のRTX 3060は悪い選択肢ではないので、買い替えは先送りし、焦って血眼になって安いクラウドサービスを探すのではなく、空いているのを見つけたらラッキーくらいに考えて肩の力を抜こうかな、と今は考えています。

本記事がGPU不足に悩む皆さんにとって何らかのヒントになれば幸いです。

3.GPUの需要と供給から考える2024年以降のAI開発の傾向と対策関連リンク

1)www.sec.gov

UNITED STATES SECURITIES AND EXCHANGE COMMISSION WASHINGTON, DC 20549( NVIDIA向けの半導体輸出規制の原文 )

2)www.bis.doc.gov

Supplement No. 1 to Part 740 – Country Groups Popular (カントリーグループDの対象国)

3)store.steampowered.com

Steamハードウェア&ソフトウェア 調査: September 2023

4)huggingface.co

Chat with Intel Labs optimized Large Language Models (INTEL社のCPUでLLMを動かすデモ)