1.BLEURT:人工知能が生成した文章の品質を評価(1/3)まとめ

・人工知能が生成した文章を評価する手法は「人間による手動評価」と「機械による自動評価」の2つがある

・手動評価は正確だが手間がかかり自動評価は気軽にできるが高度な言い換えに対処できない

・BLEURTは堅牢で、かつてないレベルの品質で、人間の解釈に非常に近い、新しい自動評価を目指した

2.BLEURTとは?

以下、ai.googleblog.comより「Evaluating Natural Language Generation with BLEURT」の意訳です。元記事の投稿は2020年5月26日、Thibault SellamさんとAnkur P. Parikhさんによる投稿です。

比較対象として出て来るBLEUはフランス語で「青」の意味らしいのですが、BLEURTが何を意識した命名なのかはちょっとわかりませんでした。青を意識して選んだ素敵なアイキャッチ画像のクレジットはPhoto by Hrvoje_Photography ?? on Unsplash。クロアチアのクルカ国立公園にあるヴィソヴァツ修道院だそうです。

ここ数年で、自然言語生成(NLG:Natural Language Generation)の研究は目覚ましい進歩を遂げ、人工知能は文章を翻訳し、記事を要約し、チャットに参加し、そして、どんどん高度になるアプローチを使用して、前例のない精度で写真に対してコメントを付ける事ができるようになりました。

現在、これらのNLGシステムを評価する際には、「人間による手動評価」と「機械を使った自動評価」の2つの方法があります。人間による評価では、人間の作業者がモデルを評価します。モデルの新しいバージョンが開発される毎に大規模な品質調査を実行する必要があるなど、この手動アプローチは非常に労働集約的で大変な作業になる可能性があります。

対照的に、一般的な自動評価(BLEUなど)を使用する事もできますが、これらは「人間による解釈や評価」の信頼できない代用品と見なされる事が良くあります。

NLGの急速な進歩と既存の評価手法の欠点により、NLGシステムの品質と成功を評価する新しい手法の開発が求められています。

論文「BLEURT: Learning Robust Metrics for Text Generation」(ACL 2020で発表)では、堅牢で、かつてないレベルの品質で、人間の解釈に非常に近い、新しい自動評価基準を紹介します。

BLEURT(Bilingual Evaluation Understudy with Representations from Transformers)は、転移学習の最近の進歩に基づいており、言い換えなど、広範囲にわたる言語的な事象を捕捉します。BLEURTはGithubで入手可能です。

NLGシステムの評価

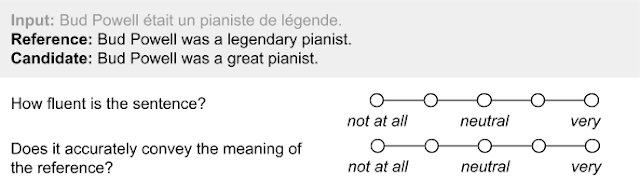

人間による評価では、生成された文章の一部が評価者に提示されます。評価者は、文章の流暢さと趣意に関して品質を評価します。文章評価時は通常、人間によって作成された文章、もしくはインターネットから取得された文章が並べて表示され参照されます。

機械翻訳の品質を人間が評価する際に使用されるアンケートの例

この方法の利点は、正確であることです。文章の品質を評価することに関しては、人間はまだ他の手法の追随を許しません。 ただし、この評価方法は数千程度の文章量であっても数十人が関与するため、開発をする際の作業フローが複雑になり、容易に数日規模の時間がかかることがあり、簡単にはできませんん。

対照的に、「機械を使った自動評価」の背後にあるアイデアは、「人間による手動評価」を代替する安価で素早く実行できる手段を提供することです。

自動評価を行う際は、2つの文を入力として使用することが多いです。すなわち、評価対象の文章と評価の際に参照する文章です。通常は、この2つの文章の字句の重複を使用して、前者が後者にどの程度似ているかを示すスコアを返します。人気のある従来の評価基準はBLEUです。BLEUは、評価対象文にも参照文にも存在する単語の並びを数えます。(BLEUスコアは適合率(precision)と非常に似ています)

自動評価の利点と欠点は、人間による手動評価と逆です。自動評価は気軽に実行できます。トレーニング実行中にどのタイミングでもリアルタイムで計算できます。(例:Tensorboardでグラフ表示なども可能)

しかしながら、表面的なレベルの類似性に重点を置いているため、不正確であることが多く、人間の言語の多様性を捉える事はできません。自然言語には多くの場合、同じ意味を伝える事ができる完全に文法的に正しい文が沢山あります。

語彙の一致のみに依存した重複部分の量をベースに判断する評価基準は、意味を正確に捉えていなくても、参照文に似ているものに不当に高いスコアを与え、言い換え文には不当なペナルティを課してしまいます。

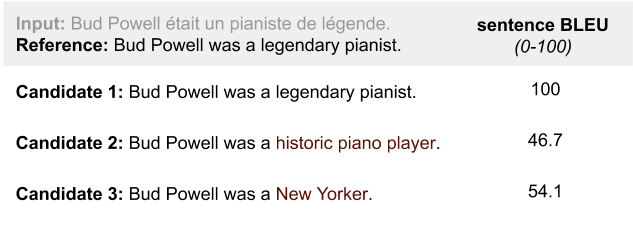

3つの候補文のBLEUスコアの比較

候補2「Bud Powellは歴史的なピアニストでした」は、候補3「Bud Powellはニューヨーカーでした」より意味的に参照文「Bud Powellは伝説的なピアニストでした」に近いのですが、BLEUスコアは候補3よりも低くなります。

理想的なNLGの評価手法は、「人間による手動評価」と「機械による自動評価」の両方の利点を組み合わせる必要があります。すなわち、比較的簡単に計算可能で、自然言語の多様性に対処するために十分な柔軟性を持つ事が必要です。

3.BLEURT:人工知能が生成した文章の品質を評価(1/3)関連リンク

1)ai.googleblog.com

Evaluating Natural Language Generation with BLEURT

2)arxiv.org

BLEURT: Learning Robust Metrics for Text Generation

3)github.com

google-research/bleurt

4)www.statmt.org

ACL 2019 FOURTH CONFERENCE ON MACHINE TRANSLATION (WMT19)

コメント