1.視覚タスクで学習した重みをロボット操作タスクに転移学習する試み(1/3)まとめ

・ロボットが「物体に対して何が出来て何が出来ないのか?」を直接知覚できるようになると学習効率が良い

・これをアフォーダンスベースの操作と言い入力画像にアクション値を割り当てる事で実装される

・入力画像処理部分に関してはロボットと関係ない全く別の画像処理タスクの重みを転移できないだろうか?

2.affordance-based manipulationとは?

以下、ai.googleblog.comより「Visual Transfer Learning for Robotic Manipulation」の意訳です。元記事の投稿は2020年3月20日、Yen-Chen LinさんとAndy Zengさんの投稿です。

大変訳しにくい概念である「アフォーダンス(affordance)」が出てきます。

例えば、人間はボタンを見れば押せそうって思うし、レバーを見れば引けそうって思うじゃないですか。

このように「~が出来そう」と認識させる物体の属性を「アフォーダンス(affordance)」といいます。人工知能が「アフォーダンス(affordance)」を感じとれれば、ランダムに試行錯誤するのではなく、自ら能動的に可能性の高い行動に対して試行錯誤出来るのではないかってアイディアが「アフォーダンスベースの操作(affordance-based manipulation)」です。でも、そのためにはまず視覚による認識をしないといけないですが、それは他の視覚タスク(画像分類など)で学習した重みを転移学習させれば効率的に学習させる事が出来るのではないだろうか?ってのが今回のお話です。

アフォーダンス → 阿呆のダンス → 踊る阿呆に見る阿呆 → 阿波踊りって事から連想したアイキャッチ画像のクレジットはWikipediaより阿波踊り By Rosino

阿波踊りは何となくロボットっぽい動きでもあるので、affordanceは阿波踊りからのロボット研究を連想すると覚えやすいですね。

ロボットがアフォーダンスを知覚、つまり「物体に対して何が出来て何が出来ないのか?」を直接知覚するようにし、その知覚を利用して操作する事ができないかと言うアイディアは、アフォーダンスベースの操作(affordance-based manipulation)と呼ばれます。

アフォーダンスベースの操作は物体を拾い上げる、押す、投げるなど、視覚に基づいて複雑な操作スキルを学習する研究で調査対象となっています。

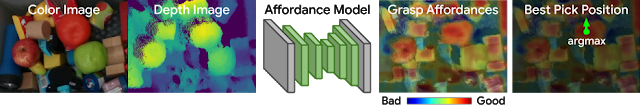

これらの操作システムでは、アフォーダンスは入力画像に画素単位にアクション値を割り当てて表現されます。

このアクション値は、ロボットが各位置で事前定義された動作を実行する事がどれだけ成功率が高いかを推定しています。

たとえば、RGB-D画像が与えられた場合、アフォーダンスベースの把握モデルは、畳み込みニューラルネットワークを使用して画素毎に把握のアフォーダンスを推測します。各画素の把握アフォーダンス値は、対応する動作(物体を把握する動作など)の実行の成功率を表します。そして、最も高い値を持つ位置でロボットによって動作が実行されます。

アフォーダンスベースの操作(affordance-based manipulation)の概要

このような手法の場合、物理的ロボットを使った試行錯誤によるデータ収集には時間がかかり、費用もかかるため、少ないデータでより多くのことを実行できる事が非常に重要です。

ただし、転移学習における最近の発見により、大規模なコンピュータービジョンデータセットから学習した視覚的特徴表現をディープラーニングエージェントに再利用できるため、ビデオゲームやシミュレーション環境でより速く学習し、より一般化することができます。

もし、画素をアクションに割り当てるエンドツーエンドのアフォーダンスベースのロボット学習モデルが、同様に視覚的特徴表現から恩恵を受ける事が出来るのであれば、現在利用可能な膨大な量のラベル付けされたビジュアルデータを活用して、より少ないトレーニングで実際のやり取りに役立つスキルをより効率的に学習できます。

ICRA 2020で発表されるMITの研究者とのコラボレーションである論文「Learning to See before Learning to Act: Visual Pre-training for Manipulation」では、既存の事前学習済みディープラーニングの視覚的特徴表現が、物体把握などのロボット操作タスクの学習効率を向上できるかどうかを調査します。

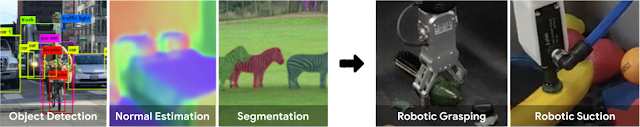

視覚モデルとアフォーダンスベースの操作モデルの間でニューラルネットワークの重みをインテリジェントに転送する方法を研究することで、様々な視覚的特徴表現が探索プロセスにどのように役立つかを評価する事が出来るようになり、その結果、ロボットが様々なロボットアームを使用して操作スキルをすばやく習得できるようになります。ディープラーニングモデルを事前トレーニングする実用的なテクニックを紹介します。これにより、ロボットが揺らぎのある状況で10分未満の試行錯誤で任意の物体を選択して把握できるようになります。

最初に見ることを学ぶことで、ロボットが行動する事を学習する速度を向上させる事ができるでしょうか?このプロジェクトでは、視覚タスク(左)から学習した知識をロボット操作タスク(右)に転移する方法を研究します。

3.視覚タスクで学習した重みをロボット操作タスクに転移学習する試み(1/3)関連タスク

1)ai.googleblog.com

Visual Transfer Learning for Robotic Manipulation

2)yenchenlin.me

Learning to See before Learning to Act: Visual Pre-training for Manipulation

コメント