1.2022年のGoogleのAI研究の成果と今後の展望~言語・視覚・生成モデル編~(4/5)まとめ

・画像、映像、音声用の生成モデルの品質と能力は、2022年に本当に驚くべき、驚異的な進歩を見せた

・GoogleはImagen VideoとPhenakiという2つの取り組みで文章に基づいた動画を生成可能な事を示した

・生成ツールは創造的作業を支援する可能性を秘めるが様々な懸念もあるので公開タイミングは慎重に検討

2.Google AIの2022年の振り返り~生成モデル編~

以下、ai.googleblog.comより「Google Research, 2022 & Beyond: Language, Vision and Generative Models」の意訳です。元記事の投稿は2023年1月18日、Google AIのトップのJeff DeanがGoogle Research communityを代表しての執筆です。

Googleの生成モデルは非公開であるためか、やや影が薄くなってしまっている印象がありますが、Googleもやってるんだよ!と主張したい気持ちがあるのか、他の章と比べて特に長文です。

ちょっと前にMetaのLeCun教授が、chatGPTと同レベルのものは既にあるとおっしゃってましたが、実際、GoogleやMeta内には影響範囲が広すぎるので非公開になっているモデルが沢山あるのだろうな、と思います。

アイキャッチ画像はstable diffusionのカスタムモデルによる生成

生成モデル(Generative Models)

画像、映像、音声用の生成モデルの品質と能力は、2022年に本当に驚くべき、驚異的な進歩を見せました。

自然画像など複雑なデータセットのモデリングを学習しなければならない生成モデルには、多種多様なアプローチがあります。

2014年に開発された敵対的生成ネットワーク(GAN:Generative Adversarial Networks)は、互いに作用し合う2つのモデルを設定します。

1つは生成モデル(generator)であり、(おそらく、生成対象のカテゴリなどを条件として与えられて)リアルな画像を生成しようとします。

もう1つは識別モデル(discriminator)であり、生成された画像と実画像が与えられ、どちらが生成されどちらが本物かを判断しようとします。2つのモデルは、それゆえ、互いに敵対する側面を持ちます。

それぞれのモデルは相手との競争に勝つためにどんどん良くなろうとし、その結果、両方のモデルが自分のタスクでどんどん良くなり、最終的には生成モデルが単独で画像生成に使用できるレベルに達するのです。

過去10年間の画像生成モデル機能の進歩

左:I.Goodfellow等による2014の研究

中央:M.Lucic等による2019の研究

右:2022年のImagenで生成された画像

2015年に「Deep Unsupervised Learning using Nonequilibrium Thermodynamics」で発表された拡散モデル(Diffusion models)は、反復的な順拡散プロセス(forward diffusion process)を通じて、データ分布の構造を系統的にゆっくりと破壊していきます。

その後、高レベルのノイズが与えられた場合でも、失われたデータの構造を復元することができる逆拡散プロセス(reverse diffusion process)を学習します。

順方向プロセスでは、どの画像にノイズを加えるかを制御し、条件づける事ができます。そのため、逆拡散(生成)過程を制御にすることが可能です。

つまり、モデルに「グレープフルーツの画像を生成せよ」と要求することが可能であり、グレープフルーツの画像を生成する事が目的であれば、単に「画像を生成せよ」よりもはるかに有用な機能となります。

また、様々な形式の自己回帰モデル(autoregressive models)が画像生成のタスクに適用されています。2016年の「Pixel Recurrent Neural Networks」では、リカレントアーキテクチャであるPixelRNNと「Conditional Image Generation with PixelCNN Decoders」でも調査した、似ていますがより効率の良い畳み込みアーキテクチャであるPixelCNNが紹介されました。この2つのアーキテクチャは、ディープニューラルネットワークを用いた画素レベルでの生成の基礎を築くのに貢献しました。

2017年には、「Neural Discrete Representation Learning」で提案された、ベクトル量子化変分オートエンコーダ(vector-quantized variational autoencoder)であるVQ-VAEがこれに続きました。これをPixelCNNと組み合わせることで、高画質な画像を得ることができました。そして2018年のImage Transformerでは、自己回帰型Transformerモデルを使って画像を生成しています。

比較的最近まで、これらの画像生成技術はすべて、実世界の画像と比較すれば比較的低品質な画像を生成する能力でした。しかし、最近のいくつかの進歩により、画像生成の性能が格段に向上する扉が開かれました。

一つは、CLIP(Contrastic Language-Image Pre-Training)という、画像エンコーダとテキストデコーダを共同で学習させ、[画像、テキスト]のペアを予測させる事前学習手法です。この事前学習は、どの画像にどの説明文が適切かを予測するもので、画像特徴表現を学習する効率的で規模拡大可能な方法であり、ImageNetなどのデータセットで優れたゼロショット性能が得られることが証明されています。

CLIPに加え、最近では生成的な画像モデルのツールキットも増えてきました。

大規模な言語モデルエンコーダは、あらかじめ設定された限られた数の画像カテゴリではなく、長い自然言語記述に基づく画像生成を効果的に行うことが示されています。

画像とそれに付随する説明文の学習データセットが大幅に増え、これらはテキストから画像を導き出すためにも使用できるため、全体的なパフォーマンスが向上しています。これらの要因が相まって、非常に詳細且つ、とてつもないプロンプトであっても、プロンプトに忠実に高解像度の画像を生成することができる様々なモデルが生み出されています。

本稿では、Google Researchのチームによる2つの最近の進歩、ImagenとPartiに焦点を当てます。

Imagenは、前述の拡散(Diffusion)に関する研究をベースにしています。2022年の論文「Photorealistic Text-to-Image Diffusion Models with Deep Language Understanding」において、著者らは、テキストのみの指標で事前学習した汎用型の大規模言語モデル(例えば、T5)が、画像合成用にテキストを符号化する際に驚くほど有効であることを示しています。

驚くべきことに、Imagenの言語モデルのサイズを大きくすると、画像拡散モデル(image diffusion model)のサイズを大きくするよりも、生成画像の忠実度と画像とテキストの一致度の両方が向上するのです。

この研究は、Efficient U-Netと呼ばれるメモリ効率の良い新しいアーキテクチャや、学習中に条件付け情報を時々「ドロップアウト」することで性能を向上させるClassifier-Free Diffusion Guidanceなど、拡散ベースの画像生成にいくつかの進歩をもたらしています。

分類器不要のガイダンス(Classifier-free guidance)により、モデルは入力データのみから生成するよう学習するため、条件付け情報に過度に依存することで発生する問題を回避することができます。「Guidance: a cheat code for diffusion models」に素晴らしい解説があります。

Partiは自己回帰Transformerアーキテクチャを用いて、テキスト入力に基づいた画像画素を生成します。

2021年に公開された「Vector-quantized Image Modeling with Improved VQGAN」では、Vision Transformerに基づくエンコーダが、ベクトル量子化GANモデルであるVQGANの出力を大幅に改善することが示されています。

これは2022年にリリースされた「Scaling Autoregressive Models for Content-Rich Text-to-Image Generation」で拡張され、Transformerエンコーダーデコーダーを200億パラメータに規模拡大することではるかに良い結果が得られました。

また、Partiは生成された画像を鮮明にするために、上述の分類器不要のガイダンスを使用しています。言語モデルであることを考えれば当然かもしれませんが、Partiはプロンプトの微妙な手がかりを拾うことに特に長けています。

左:以下の複合プロンプトから生成されたImagenの生成画像

「王城内の壁。壁には2枚の絵が描かれている。左側は王家のアライグマの王様の詳細な油絵。右側はアライグマの女王の詳細な油絵(A wall in a royal castle. There are two paintings on the wall. The one on the left is a detailed oil painting of the royal raccoon king. The one on the right a detailed oil painting of the royal raccoon queen.)」

右:以下のプロンプトから生成されたPartiの画像

「ニューヨークのタクシーで、バイクのヘルメットとマントを着たテディベアがカーサーフィンをしています。デジタル一眼レフカメラの写真(A teddy bear wearing a motorcycle helmet and cape car surfing on a taxi cab in New York City. dslr photo.)」

ユーザによる制御

以上の経緯で、テキストの記述からリアルな静止画を生成することができるようになりました。

しかし、「浜辺でユニコーンに追いかけられる犬」と「浜辺でユニコーンに追いかけられる私の犬」の違いのように、文字だけでは貴方の思い通りにならないこともあります。

そこで、私たちは、ユーザーが生成プロセスをコントロールする新しい方法を提供するために、その後の研究を行いました。

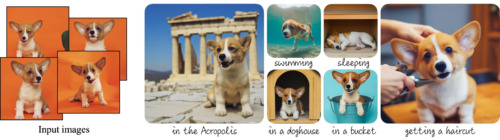

「DreamBooth: Fine Tuning Text-to-Image Diffusion Models for Subject-Driven Generation」では、

、ImagenやPartiなどの学習済みモデルを微調整して、テキストとユーザーが提供した画像の組み合わせから新しい画像を生成できます。(下図やDreamBoothのサイトに詳細と例が掲載されています)

これにより、ユーザーは自分自身(または自分自身のペットなど)の画像を、生成する画像内に配置することができ、より多くのユーザー制御が可能になります。

例えば、「車を自転車にしてください(make the car into a bicycle)」といったテキストプロンプトで画像を編集できる「Prompt-to-Prompt Image Editing with Cross Attention Control」や、テキストプロンプトでマスク部分を埋めることで画像を繰り返し編集できる「Imagen Editor」などがこれにあたります。

DreamBoothは、入力画像とテキストプロンプトの両方を使用して、画像生成プロセスの制御を可能にします。

動画の生成

私たちが取り組んでいる次の研究課題の一つは、高解像度、高品質、時間的に一貫した動画を高い制御性で生成できる動画用生成モデルを作ることです。

これは非常に難しい分野です。というのも、画像では生成した画素と望ましい画像の特性を一致させることが課題でしたが、動画では時間という次元が追加されるからです。

各フレームの画素は、その瞬間に映像で起こっていることと一致していなければならないだけでなく、他のフレームとも一致していなければなりません。

非常に細かいレベル(動きが滑らかで自然に見えるように、数フレーム先)でも、粗いレベル(飛行機が離陸、旋回、着陸する2分間のビデオを要求した場合、このハイレベルな映像目的に一致する数千のフレームを作成しなければなりません)でも一致させなければならないのです。

今年は、Imagen VideoとPhenakiという2つの取り組みを通じて、この高い目標を達成するために、それぞれ異なるアプローチで、かなりエキサイティングな進展を遂げました。

Imagen Videoは、Cascaded Diffusion Modelsを用いて高解像度の動画を生成します。(詳細は論文「Imagen Video: High Definition Video Generation from Diffusion Models」で詳しく説明しています)

まず、入力テキストプロンプト「誕生日の帽子をかぶった幸せな象が海中を歩いている(A happy elephant wearing a birthday hat walking under the sea)」を受け取り、T5テキストエンコーダーでテキストembeddings にエンコードします。

次に、ベースとなるビデオ拡散モデル(video diffusion model)が、40 x 24の解像度と3フレーム/秒の非常に粗いな16フレーム映像を生成します。

その後、複数の時間超解像(TSR:Temporal Super-Resolution)と空間超解像(SSR:Spatial Super-Resolution)モデルでアップサンプリングし、最終的に解像度1280 x 768、24フレーム/秒の128フレームビデオを生成します。(5.3秒の高解像度ビデオに仕上がります)。その結果、高解像度で、空間的・時間的に一貫したビデオが得られますが、それでも5秒程度と非常に短い映像となっています。

2022年に発表された「Phenaki: Variable Length Video Generation From Open Domain Textual Description」はビデオ表現を学習するための新しいTransformerベースのモデルを導入し、ビデオを離散トークンの小さな特徴表現に圧縮しています。

Phenaki(フェナキ)のテキストを使った条件付けは、双方向のTransformerモデルを学習させ、テキスト記述に基づきビデオトークンを生成することで実現されます。

この生成されたビデオトークンをデコードして、実際のビデオを作成します。このモデルは時間的な因果関係を知っているため、可変長のビデオの生成に使用することができます。これにより、以下のビデオに示されるように、複数プロンプトを使った物語生成への扉を開くことができるのです。

複雑なプロンプトからPhenakiが生成したビデオ

「サンフランシスコの海で泳ぐフォトリアリスティックなテディベア。テディベアは水中に潜っていきます。テディベアはカラフルな魚たちと一緒に水中を泳ぎ続けます。パンダが水中を泳いでいます(A photorealistic teddy bear is swimming in the ocean at San Francisco. The teddy bear goes under water. The teddy bear keeps swimming under the water with colorful fishes. A panda bear is swimming under water.)」

Imagen VideoとPhenakiのモデルを組み合わせることで、Imagenの高解像度な個々のフレームとPhenakiの長尺なビデオの両方の利点を享受することが可能です。

最も簡単な方法は、短いビデオの断片の超解像化をImagen Videoで処理し、長い時間のビデオ情報を生成するために自動回帰型のPhenakiモデルに依存することです。

音声用の生成モデル

視覚用の生成モデルに加え、私達は音声用の生成モデルについても大きな進展をしました。

「AudioLM, a Language Modeling Approach to Audio Generation」(および添付論文)では、言語モデリングの進歩を利用して、注釈付きデータで学習することなく音声を生成する方法を説明します。

テキストデータではなく、生の音声データに対して言語モデリングアプローチを用いることで、解決しなければならない課題がいくつか生じます。

第一に、音声のデータ率は著しく高く、より長いデータ長になります。文章は数十文字で表現できますが、音声波形には通常数十万個の値が含まれます。第二に、文章と音声の間には一対多の関係があります。つまり、同じ文章でも、話し方や感情表現など、音声の背景となる条件が異なる話者によって、異なる文章が発せられる可能性があるということです。

そこで、音声生成処理を2つのステップに分けます。

1つ目は、音声信号を大きくダウンサンプリングし、局所的な依存関係(発話における調音、ピアノ音楽における局所的な旋律など)と大域的な長期構造(発話における言語構文や意味内容、ピアノ音楽における調和やリズムなど)の両方を捉える粗い意味トークンの列を生成して、長い音声データをモデル化できるようにします。

モデルの一部は、過去のそのようなトークンの並びを条件として、粗い意味的なトークンの並びを生成します。次に、粗いトークンの並びを使用して、最終的に生成される波形に近い細かいオーディオトークンを生成できるモデルの一部に頼ります。

AudioLMは、書き起こしや注釈のない音声に対して学習させると、構文的・意味的に妥当な音声の連続を生成し、初見の話者に対しても話者の特定と韻律を維持することができます。また、AudioLMは、音楽の象徴的な表現がない状態で学習しても、首尾一貫したピアノ音楽の連続を生成することができます。その他のサンプルはAudioLMのWebサイトで聴くことができます。

生成モデルに関する結論

2022年は、メディア生成にエキサイティングな進歩をもたらしました。コンピュータは自然言語と対話し、ユーザーの創作過程や作りたいものをよりよく理解できるようになりました。これにより、従来のツールの限界を超える方法で、ユーザーが画像、ビデオ、オーディオを作成するのをコンピューターが支援する、エキサイティングな新しい方法が解き放たれたのです!

このため、ユーザーが生成過程をどのように制御するかという点で、より多くの研究が行われるようになりました。文章を使った画像生成、文章を使ったビデオ生成の進歩により、言語が生成を制御する強力な手段となり、 Dream Boothのような作品では、ユーザーが自分の画像で生成を開始することが可能にしました。

2023年以降、メディア生成の質とスピードが向上することは間違いないでしょう。それとともに、より創造的な表現を可能にする新しいユーザー体験も生まれてくるはずです。

また、これらのクリエイティブツールは、人間の創造的な作業を支援する大きな可能性を秘めていますが、一方で、さまざまな有害コンテンツの生成や、現実との区別がつきにくい偽の画像や音声を生成する可能性など、さまざまな懸念があることも知っておく必要があります。 これらの問題は、いつ、どのように、責任を持ってこれらのモデルを展開するかを決定する際に、慎重に検討されるものです。

3.2022年のGoogleのAI研究の成果と今後の展望~言語・視覚・生成モデル編~(4/5)関連リンク

1)ai.googleblog.com

Google Research, 2022 & Beyond: Language, Vision and Generative Models

2)arxiv.org

Large Language Models Encode Clinical Knowledge

Deep Unsupervised Learning using Nonequilibrium Thermodynamics

Pixel Recurrent Neural Networks

Neural Discrete Representation Learning

Image Transformer

Vector-quantized Image Modeling with Improved VQGAN

DreamBooth: Fine Tuning Text-to-Image Diffusion Models for Subject-Driven Generation

3)benanne.github.io

Guidance: a cheat code for diffusion models

4)research.google

Imagen : unprecedented photorealism × deep level of language understanding

Phenaki : Realistic video generation from open-domain textual descriptions

5)google-research.github.io

AudioLM : A Language Modeling Approach to Audio Generation

6)ai.google

2022 AI Principles Progress Update(PDF)