1.LFNRとGPNR:反射するCDを含む場面の視線合成が可能な新手法(1/2)まとめ

・ある風景の複数の写真から新しい視点を合成する視点合成タスクは長年の課題

・LFNRではCDの光彩のような視点に依存する効果を再現する課題に取り組んだ

・GPNRでは新しい風景の視点を合成する事で未見の風景への汎化に取り組んだ

2.LFNRとは?

以下、ai.googleblog.comより「View Synthesis with Transformers」の意訳です。元記事は2022年9月21日、Carlos EstevesさんとAmeesh Makadiaさんによる投稿です。

アイキャッチ画像はstable diffusionでプリズムで遊ぶトトロ

コンピュータビジョンとコンピュータグラフィックスの交差点における長年の問題である視点の合成は、ある風景の複数の写真から風景の新しい視点を作成するタスクです。

これは、ニューラル・ラジアンス・フィールド(NeRF:Neural Radiance Fields)の紹介以来、注目されるようになりました。

この問題は、風景の新しい視点を正確に合成するために、モデルがその詳細な3D構造、材料、および照明など、多くの種類の情報を少ない参照画像セットから取得する必要があるため困難です。

本投稿では、最近発表された視点合成のためのディープラーニングモデルを紹介します。CVPR 2022で発表した「Light Field Neural Rendering(LFNR)」では、参照画素の色の組み合わせを学習するtransformersを用いて、視点に依存する効果を正確に再現する課題に取り組んでいます。

次に、ECCV 2022で発表予定の「Generalizable Patch-Based Neural Rendering(GPNR)」では、一連の風景で学習可能な正規化位置エンコーディング(canonicalized positional encoding)を持つtransformersを用いて、新しい風景の視点を合成することにより、未見の風景に汎化するという課題に取り組みます。

これらのモデルにはいくつかのユニークな特徴があります。このモデルは画像ベースのレンダリングを行い、参照画像から色と特徴を組み合わせて、新しい視点をレンダリングします。また、4次元ライトフィールド表現を用いて位置のエンコーディングを行うため、視界に依存する効果をモデル化することができます。

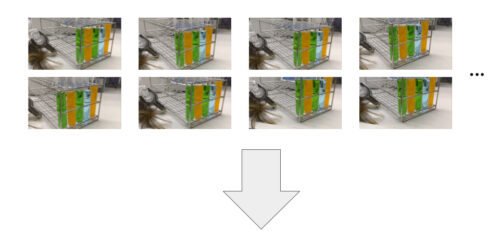

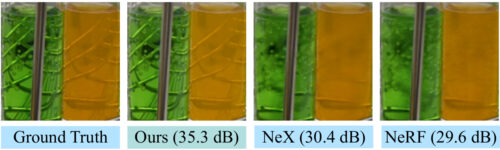

ある風景の数枚の画像が与えられたときに、その風景の新しい視点を生成することができる深層学習モデルを訓練します。これらのモデルは、試験管の屈折や半透明のような視点に依存する効果を扱うときに特に効果的です。このアニメーションは圧縮されています。オリジナル品質のレンダリングは元サイトでmp4でご覧ください。ソースはこちら NeX/Shinyデータセットの研究所の風景です。

概要

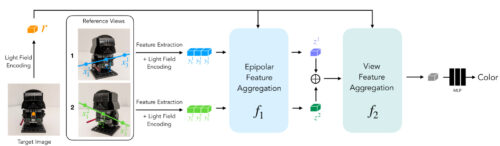

モデルへの入力は、参照画像とそのカメラパラメータ(焦点距離、位置、空間における向き)、および色決定に使うターゲット光線の座標で構成されます。新しい画像を生成するためには、入力画像のカメラパラメータから始めて、ターゲット光線(それぞれが画素に対応します)の座標を取得し、それぞれについてモデルに問い合わせをします。

各参照画像を完全に処理するのではなく、ターゲットとなる画素に影響を与える可能性のある領域のみを調べます。この領域はステレオビジョンを扱う際に用いられるエピポーラ幾何(epipolar geometry)によって決定され、各ターゲット画素を各基準フレーム上の線に対応させます。

堅牢性を高めるために、エピポーラ線上のいくつかの点の周辺に小さな領域を取ります。この結果、モデルによって実際に処理される画像断片の集合が得られます。そして、この断片集合にtransformersを作用させ、対象画素の色を求めます。

transformersは、その自己attentionメカニズムが自然にこのセットを入力として取るので、この設定で特に有用であり、attentionの重み自体は、出力ピクセルの色を予測するために、参照視点による色と特徴を組み合わせるために使用することができます。これらのtransformersはViTで紹介されたアーキテクチャを踏襲しています。

1画素の色を予測するために、モデルは各参照視点のエピポーラ線周辺に抽出された断片のセットを使用します。画像の出典は LLFFデータセットです。

ライトフィールド・ニューラル・レンダリング

ライトフィールド・ニューラル・レンダリング(LFNR:Light Field Neural Rendering)では、2つのtransformersを用いて、断片の集合をターゲット画素の色に対応付けます。

1つ目のtransformersは各エピポーラ線に沿った情報を集約し,2つ目のtransformersは各参照画像に沿った情報を集約します。

最初のtransformers は各参照フレーム上のターゲット画素の潜在的な対応関係を見つけると解釈でき、2番目のtransformersは画像ベースレンダリングの共通の課題である視点が隠れる部分と視点依存の効果に関する推論を行うと解釈できます。

LFNRは、エピポーラ線に沿って抽出された画像断片のセットをターゲット画素の色にマッピングするために、2つのtransformersの並びを使用します。

LFNRは、最も一般的な視点合成ベンチマーク(NeRFのBlenderとReal Forward-Facing scenes、NeXのShiny)において、ピーク信号対雑音比(PSNR)5dBという大きな幅をもって最先端を改善したのです。

これは、画素単位の誤差を1.8倍低減することに相当します。以下に、Shinyデータセットの困難なシーンにおける定性的な結果を示します。

LFNRは、CDの光彩や反射、ボトルの反射、屈折、半透明など、視点に依存する難しい効果を再現します。このアニメーションは圧縮されています。オリジナル品質のレンダリングはこちらで元サイトでご覧ください。ソースはこちら NeX/ShinyデータセットからのCDを含む風景

NeXやNeRFなどの先行手法は、NeX/Shinyデータセットの研究室風景の試験管内の半透明や屈折などの視点依存の効果を再現することができません。このシーンの動画(記事冒頭)、およびオリジナルの品質出力は元サイトもご覧ください。

3.LFNRとGPNR:反射するCDを含む場面の視線合成が可能な新手法(1/2)関連リンク

1)ai.googleblog.com

View Synthesis with Transformers

2)light-field-neural-rendering.github.io

Light Field Neural Rendering

3)mohammedsuhail.net

Generalizable Patch-Based Neural Rendering