1.LFNRとGPNR:反射するCDを含む場面の視線合成が可能な新手法(2/2)まとめ

・LFNRの制限の1つは狭い範囲から情報を取得しているため汎化できない事

・GPNRでは同じ深度のポイント間で情報を交換するtransformerを追加した

・GPNRは初見風景の視点合成を微調整なしで従来手法より高い精度で実現

2.GPNRとは?

以下、ai.googleblog.comより「View Synthesis with Transformers」の意訳です。元記事は2022年9月21日、Carlos EstevesさんとAmeesh Makadiaさんによる投稿です。

アイキャッチ画像はstable diffusionを使った生成画像

新しい風景への汎化

ライトフィールド・ニューラル・レンダリング(LFNR:Light Field Neural Rendering)の制限の1つは、最初のtransformerが各エピポーラ線に沿った狭い範囲の情報を取得しているため、各基準画像から独立していると言う事です。

これは、各参照画像からの出力光線座標と画像断片のみに基づいて保存する情報を決定することを意味し、(ほとんどのニューラルレンダリング手法がそうであるように)単一の風景で学習する場合はうまくいきますが、風景間で汎化することはありません。汎化可能な手法は、再トレーニングの必要なく新しい風景に適用できるため重要です。

私たちは、LFNRのこの制限を克服するために、Generalizable Patch-Based Neural Rendering(GPNR)を開発しました。

GPNRでは、他の2つのtransformerの前に実行され、すべての参照画像にわたって同じ深度のポイント間で情報を交換するtransformerを追加します。

例えば、この最初のtransformerは、上に示した公園のベンチの画像断片の列を調べ、2つの視点で対応する深度に現れる花のように、一致する可能性を示す手がかりを利用することができます。

この研究のもう一つの重要なアイデアは、ターゲット光線に基づいて位置のエンコードを正規化することです。なぜなら、風景間で一般化するためには、絶対的な参照フレームではなく相対的なフレームで量を表現することが必要であるためです。以下のアニメーションは、モデルの概要を示しています。

GPNRは、エピポーラ線に沿って抽出された画像断片の集合を画素の色に対応付ける3つのtransformerの並びで構成されます。画像断片は、線形射影層を介して初期特徴(青と緑の四角で示されています)にマッピングされます。その後、これらの特徴はモデルによって順次精緻化・集約され、最終的に灰色の四角で表される特徴・色になります。公園のベンチの画像出展元はLLFFデータセットです。

汎化性能を評価するために、GPNRをある風景で学習させ、新しい風景でテストしました。GPNRは、いくつかのベンチマーク(IBRNetおよびMVSNeRFプロトコルに準拠)において、平均0.5~1.0dBの範囲で最先端技術を向上させました。

IBRNetベンチマークでは、GPNRは学習シーンの11%しか使用していないにもかかわらず、比較対象手法を上回りました。以下の結果は、微調整を行わずにレンダリングした初見シーンの新しい視点を示しています。

GPNRで生成された学習用データセット内に含まれていなかった風景の視点(微調整なし)。このアニメーションは圧縮されています。オリジナルの品質のレンダリングは元サイトでご覧ください。出典IBRNet collectedデータセット。

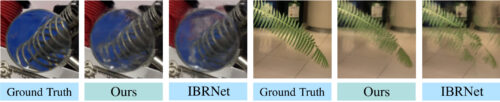

NeX/Shiny(左)とLLFF(右)の風景で、GPNR が生成した視点の詳細(微調整なし)。IBRNetと比較すると、GPNRは葉の細部やレンズの屈折をより正確に再現していることがわかります。

今後の課題

私たちの手法を含め、多くのニューラルレンダリング手法の限界の一つは、各入力画像に対してカメラの姿勢が必要であることです。

姿勢の取得は容易ではなく、汎用的にオフラインで最適化するため時間がかかり、モバイル機器などでの応用には限界があります。

視点合成と入力ポーズを共同で学習する研究は、将来的に有望な方向性です。私達のモデルのもう一つの限界は、訓練に計算コストがかかることです。

より高速なtransformersに関する研究が活発に行われており、私達のモデルの効率を向上させるのに役立つかもしれません。論文やその他の結果、オープンソースのコードについては「Light Field Neural Rendering」と「Generalizable Patch-Based Neural Rendering」のプロジェクトのページをご覧ください。

悪用の可能性について

私達の研究では、既存の風景の画像を用いて正確に再現することを目指しているため、偽の風景や存在しない風景を生成する余地はほとんどありません。また、静止画を想定しているため、人物などの動くものを合成することはできません。

謝辞

すべてのハードワークは、UBCの博士課程の学生である素晴らしいインターンのMohammed Suhail、Google ResearchのCarlos EstevesとAmesh Makadia、そしてUBCのLeonid Sigalと協力してによって行われました。このプロジェクトをサポートし、励ましてくれたCorinna Cortesに感謝しています。

私たちの研究は、最近の視点合成への関心の火付け役となったNeRFと、新しい風景への汎化を最初に考慮したIBRNetに触発されたものです。光線位置のエンコーディングはLight Field Renderingの論文に触発され、transformersの使用はViTに倣ったものです。

映像は、LLFF、Shiny、IBRNetの収集データセットから風景を抽出したものです。

3.LFNRとGPNR:反射するCDを含む場面の視線合成が可能な新手法(2/2)関連リンク

1)ai.googleblog.com

View Synthesis with Transformers

2)light-field-neural-rendering.github.io

Light Field Neural Rendering

3)mohammedsuhail.net

Generalizable Patch-Based Neural Rendering