1.Weak Supervision:機械学習のための新しいプログラミングパラダイム(4/4)まとめ

・Snorkelの研究は続けられており、ラベル付け関数の自動生成!など、様々な場面での活躍が見込まれる

・マルチタスクラーニング(MTL)を拡張する大規模マルチタスク管理機構のヴィジョンは壮大

・大規模マルチタスク管理機構は、数十から数百の弱い教師タスクが複雑で多様に相互作用する事を可能にする

2.弱い教師をまとめて管理する大規模システム

以下、ai.stanford.eduより「Weak Supervision: A New Programming Paradigm for Machine Learning」の意訳です。元記事は2019年3月10日、Alex Ratnerさん, Paroma Varmaさん, Braden Hancockさん, Chris RéさんとHazy Labの皆さんによる投稿です。

次のステップ:大規模でマルチタスクな弱い教師

私達の研究室では、Snorkelで想定されている弱い教師による相互作用モデルを、情報量の多いデータや画像、自然言語によるタスクの教師、ラベル付け関数の自動生成!など、様々な使用場面に拡張するための様々な取り組みがすでに行われています。

技術面では、Snorkelの中心部のコアデータプログラミングモデルを拡張し、自然言語などのより高度なインタフェースでラベル付け関数を指定しやすくすること、および他の種類の弱い教師(data augmentationなど)と組み合わせることの両方に関心があります。

マルチタスクラーニング(MTL:multi-task learning)シナリオの普及もまた疑問を投げかけます。

ノイズが多くおそらく相関関係を持つラベル付用データが、複数の関連タスクでラベルを付けされるようになったらどうなりますか?これらのタスクの教師を共同でモデル化することによって私たちは利益を得ることができるでしょうか?

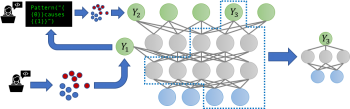

これらの問題に対処するために、新しいマルチタスク対応バージョンのSnorkelである、Snorkel MeTaLで取り組んでいます。論文、Training Complex Models with Multi-Task Weak Supervisionで発表されたSnorkel MeTaLは、マルチタスクの弱い監視ソースをサポートする事ができ、1つまたは複数のタスクにノイズの多いラベルを提供する事に対応できます。

私たちが考慮している1つの例は、異なる粒度を持つラベルソースの設定です。例えば、特定のタイプの人々や場所に関してタグ付けする、きめ細かい(Fine-Grained)名前付きエンティティ認識(NER)モデルを訓練することを目的としたラベルがあるとします。(例:この人は法律家なのか医者なのか、またはこの建物は銀行なのか病院なのか?)そして、粗い(Coarse-Grained)のラベルもあるとします。(例:これは人なのか場所なのか?)これらのラベルを、階層的に関連するさまざまな粒度のタスクのラベルとして表現する事により、私達はこれらのラベルが持つ異なる粒度の的確さを統合する事ができます。そして、マルチタスク用にラベルの再重み付けと結合を行って、MTLモデルのパフォーマンスを向上させる、よりクリーンでインテリジェントに集約されたマルチタスクトレーニングデータを最終的に作成する事が可能です。

MTL用のデータ管理システムを構築する上で最もエキサイティングな側面は、私たちが大規模マルチタスク管理機構(massively multi-task regime)と呼んでいるものを中心に展開すると私たちは信じています。大規模マルチタスク管理機構では、数十から数百の弱い教師タスク(従って頻繁に変更が発生する)が複雑で多様な方法で相互作用します。

これまでのほとんどのMTL作業は、静的なラベル付きトレーニングセットを使ったせいぜい一握りのタスクに同時に取り組む事でしたが、世界は急速に組織化の方向に進んでいます。大企業、学術研究室、またはオンラインコミュニティのいずれであろうと、数十から数百の弱い教師により、急速に変化し、相互依存するモデリングタスクを維持しています。更に、これらのタスクは弱い教師タスクなので、開発者は数ヶ月または数年のスパンではなく数時間または数日の短期スパンでタスク(例えばトレーニングデータ)を追加、削除、または変更してモデル全体を再訓練する事が潜在的に必要になります。

最近の論文では、上記の質問に対する最初の考えを概説しました。異なる開発者によって弱くラベル付けされたトレーニングデータを、統合レポジトリとして効果的に機能する中央の「マザー」マルチタスクモデルに組み合わせるのです。そして、MLモデルがこの大規模マルチタスク環境を利用可能になる未来を私達は見据えています。

厳密にどのような形態で実現されるかに関わらず、今後のMTL技術に多くのエキサイティングな進歩をもたらす事は明らかです。新しいモデルアーキテクチャだけでなく、転移学習アプローチ、新しい弱い教師アプローチ、新しいソフトウェア開発とシステムパラダイムによる統一の強化などが考えられます。

snorkel.stanford.eduに私たちの考えやコードを投稿し続けるつもりです – フィードバックはいつでも歓迎です!

3.Weak Supervision:機械学習のための新しいプログラミングパラダイム(4/4)関連リンク

1)ai.stanford.edu

Weak Supervision: A New Programming Paradigm for Machine Learning

2)arxiv.org

Training Complex Models with Multi-Task Weak Supervision

3)cidrdb.org

The Role of Massively Multi-Task and Weak Supervision in Software 2.0

コメント