1.BERTは文法を理解しているのか?頻度を見ているだけなのか?(2/2)まとめ

・BERTは主語と動詞の一致ルールで単純な経験則モデルより良い性能である

・主語と動詞が一致すべき事と高頻度の単語がより可能性が高い事を知っている

・一致が従うべき規則で頻度は単なる好みであることまでは理解していない

2.BERTは文法を規則としては理解していない

以下、ai.googleblog.comより「Evaluating Syntactic Abilities of Language Models」の意訳です。元記事の投稿は2021年12月2日、Jason WeiさんとDan Garretteさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Ashes Sitoula on Unsplash

初見の主語と動詞のペア

まず、「事前学習中に出現した主語と動詞のペア」と、「事前学習中に同じ文の中で主語と動詞が同時に使われなかったペア」で、モデルがどの程度うまくいくかを調べました。

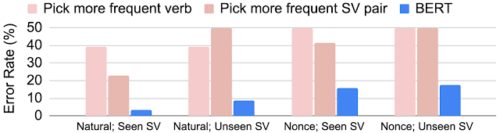

自然文(natural sentences)とノンス文(nonce sentences)を使って評価した際のBERTのエラー率

特定の「主語と動詞のペア(SV)」が訓練中に同じ文中に出現したかどうかで分けられています。初見のSVペアに対するBERTの性能は、より頻度の高い動詞を選ぶモデル、より頻度の高いSVペアを選ぶモデルといった単純な経験則に基づくモデルよりはるかに優れています。

動詞の頻度

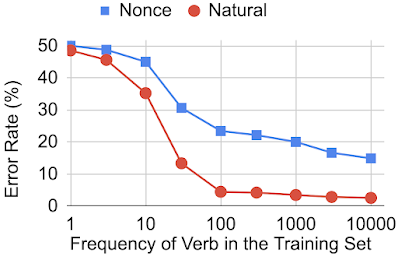

次に、見た事があるかないかだけでなく、単語の頻度が主語と動詞の一致ルールを正しく使用するBERTの能力にどのような影響を与えるかを検討しました。

この研究では、60個の動詞を選び、それぞれ特定の頻度で60個の動詞を含むように設計された複数のバージョンの事前学習データを作成し、単数形と複数形が同じ回数だけ出現するようにしました。そして、これらの異なるデータセットからBERTモデルを学習させ、主語と動詞の一致タスクで評価しました。

主語と動詞の一致規則を守るBERTの能力は、トレーニングセット内の動詞の出現頻度によって変わります。

この結果から、BERTは主語と動詞の一致ルールをモデル化することはできますが、そのルールに確実に従って動詞を使用するようになるためには、約100回動詞を見る必要があることがわかりました。

動詞の単数形と複数形の相対出現頻度の影響

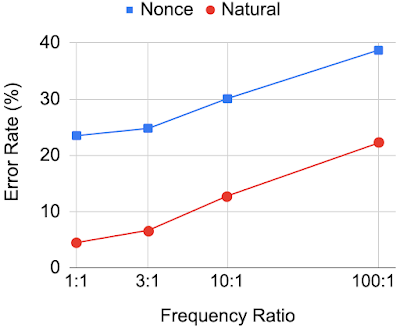

最後に、動詞の単数形と複数形の相対的な頻度がBERTの予測にどのような影響を与えるかを理解したいと思いました。例えば、ある動詞の形(例:combat)が他の動詞の形(例:combats)よりもずっと頻繁に事前学習データに現れた場合、BERTは、それが文法的に正しくない場合でも、より頻繁に現れる形に高い確率を割り当てる可能性が高くなる場合があります。

そこで、同じ60個の動詞を使用し、動詞の頻度比を1:1から100:1まで変化させた事前学習データを作成し、評価しました。下図は、このように頻度の不均衡を変化させた場合のBERTの性能を示しています。

学習データにおける動詞の形態間の頻度比が不均衡になると、それらの動詞を文法的に使用するBERTの能力が低下します。

これらの結果から、BERTは、事前学習で2種の動詞形式を同じ回数見た場合、正しい動詞形を予測する精度が高くなりますが、頻度間のアンバランスが大きくなると結果が悪くなることがわかりました。

これは、BERTが主語と動詞の一致の適用方法を学習したとしても、必ずしもそれを「ルール」として使用せず、代わりに主語と動詞の一致制約に違反するかどうかに関係なく、高頻度に出現する単語を予測することを好むことを示唆しています。

結論

ターゲット構文評価(TSE:Targeted Syntactic Evaluation)を使用してBERTの性能を評価することにより、構文タスクにおけるBERTの言語能力が明らかになりました。

さらに、訓練データセットにおける単語の出現頻度と構文能力の関係を研究することで、BERTが優先順位が競合した際にそれを処理する方法が明らかになりました。

つまり、主語と動詞が一致すべきこと、高頻度の単語がより可能性が高いことを知っていますが、一致が従わなければならない規則で、頻度は単なる好みであることは理解していません。

本研究が、言語モデルが学習されたデータセットの特性をどのように反映するかについて、新しい洞察を与えることを期待しています。

謝辞

本プロジェクトでTal LinzenとEllie Pavlickと共同研究できたことは光栄でした。

3.BERTは文法を理解しているのか?頻度を見ているだけなのか?(2/2)関連リンク

1)ai.googleblog.com

Evaluating Syntactic Abilities of Language Models

2)arxiv.org

Frequency Effects on Syntactic Rule Learning in Transformers