1.ALIGN:ノイズの多い文章を教師に使って視覚と言語で共通する特徴表現を学習(3/3)まとめ

・ALIGNは風景の詳細な説明や固有地形や芸術作品などのきめ細かいレベル画像検索が可能

・ALIGN embeddingsを使って演算するとパンダに相当する動物をオーストラリアから探せる

・現実世界でモデルを責任を持って使用する前にデータとモデルの追加分析が必要

2.ALIGNを使った画像検索

以下、ai.googleblog.comより「ALIGN: Scaling Up Visual and Vision-Language Representation Learning With Noisy Text Supervision」の意訳です。元記事の投稿は2021年5月11日、Chao JiaさんとYinfei Yangさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by davide ragusa on Unsplash

画像検索での応用

上記の定量的な結果を説明するために、ALIGNによってトレーニングされたembeddingsを使用して単純な画像検索システムを構築しました。以下では1億6000万枚の画像に対してテキストを使って検索してTOPに表示された事例を少数紹介します。

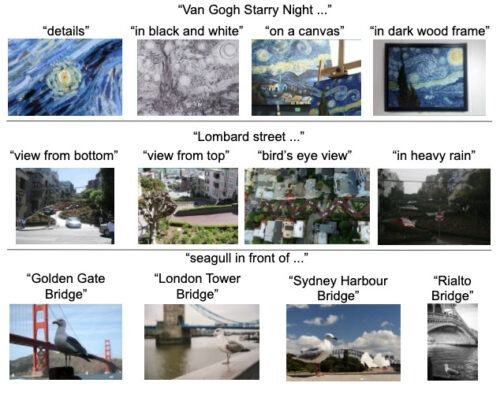

ALIGNは、風景の詳細な説明、または固有地形や芸術作品などのきめ細かいまたは実体レベルの概念を指定して、正確な画像を検索できます。これらの例は、ALIGNモデルが画像とテキストを同様の意味的観点に揃えることができ、ALIGNが新しい複雑な概念に一般化できることを示しています。

ALIGNのembeddingsを使用して、テキストを使ったきめ細かい画像検索を実現

複数の入力形式(画像+テキスト)を使って画像を検索

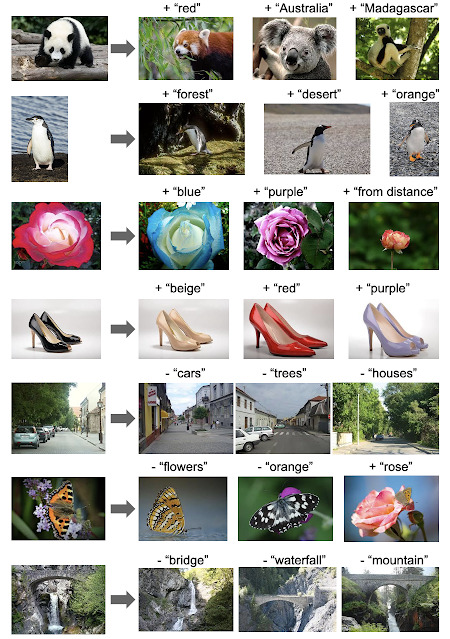

単語ベクトルの驚くべき特性は、単語の類似性がベクトル演算でも実現できるケースが多いことです。有名な例には単語を使った演算「王 - 男 + 女 = 女王」があります。

ALIGNでも画像とテキストのembeddingsの間にこのような線形関係が発生しました。

具体的には、入力に与えられた画像とテキスト文字列を指定して、それらのALIGN embeddingsを検索に追加し、それを使用して、以下に示すように、コサイン類似度を使用して関連する画像を取得します。これらの例は、視覚および言語領域全体でのALIGN embeddingsの構成性を示すだけでなく、画像とテキストを一緒に使用した検索(マルチモーダル検索)の実現可能性も示しています。

例えば、パンダに相当する動物を「オーストラリア」または「マダガスカル」から探したり、「黒い靴」を同じように見える「ベージュの靴」に色合いを変えたりすることができます。

また、以下に示すように、embeddings空間で減算を実行することにより、風景内から物体/属性を削除することもできます。

画像とテキストを使った画像検索

検索テキストのembeddingsを追加または削除すると、ALIGNは関連する画像を捜し出します。

社会的影響と将来の研究

本研究は、単純なデータ収集方法を使用した方法論の観点から有望な結果を示していますが、実際にモデルを責任を持って使用する前に、データと結果のモデルの追加分析が必要です。

例えば、altテキスト内に有害なテキストデータが存在し、その有害性が強化される可能性について検討する必要があります。公平性に関しては、Webデータがステレオタイプを強化することを防ぐために、データバランシングの取り組みが必要になる場合があります。

また、誤ってラベル付けされた可能性のあるデータからの影響を理解して軽減するために、注意を要する宗教的または文化的項目に関する追加のテストとトレーニングを行う必要があります。

人間および関連する文化的アイテム(衣類、食品、芸術など)の人口統計学的分布が、モデルのパフォーマンスを歪めないようにするために、更に分析を行う必要があります。このようなモデルを本番環境で使用する場合は、分析とバランス調整が必要になります。

結論

大規模だがノイズの多い画像とそのaltテキストデータを活用して、視覚および視覚対言語特徴表現学習をスケールアップする簡単な方法を紹介しました。結果として得られるモデルALIGNは、形式を跨いだ検索が可能であり、従来のSotAモデルを大幅に上回っています。視覚のみの下流タスクでは、ALIGNは、大規模なラベル付きデータでトレーニングされたSotAモデルに匹敵するか、それを上回ります。

謝辞

Google Researchの共著者であるYe Xia, Yi-Ting Chen, Zarana Parekh, Hieu Pham, Quoc V. Le, Yunhsuan Sung, Zhen Li, Tom Duerigに感謝します。

この作業は、Googleの他の同僚からの貴重な助けを借りて行われました。トレーニングインフラストラクチャに関して継続的にサポートしてくれたJan DlabalとZhe Li、ImageNetの亜種でゼロショットとロバストネスモデルの評価を構築してくれたSimon Kornblith、Xiaohua Zhaiは、VTAB評価の実施に協力してくれました。

EfficientNetトレーニングに関する提案については、Mingxing TanとMax Moroz、マルチモーダルクエリ検索の初期のアイデアについては、Aleksei Timofeev、Aaron MichelonyとKaushal Patellは、データ生成に関する初期の作業、洞察に満ちたフィードバックとディスカッションをしてくれたSergey Ioffe, Jason BaldridgeそしてKrishna Srinivasanに感謝します。

3.ALIGN:ノイズの多い文章を教師に使って視覚と言語で共通する特徴表現を学習(3/3)関連リンク

1)ai.googleblog.com

ALIGN: Scaling Up Visual and Vision-Language Representation Learning With Noisy Text Supervision

2)arxiv.org

Scaling Up Visual and Vision-Language Representation Learning With Noisy Text Supervision

さて、昨日のテキストプロンプトエンジニアリング実務検定3級の回答です。ハウル(howl)は、「20%の確率でhouse」と誤認識されていました。当初、背景部分を見て家(house)に注目してしまっているのかな、と思ったのですが、ハッと気づいて、ラベルに「howl」を追加したところ、「90%の確率でhowl」と分類してきました。つまり、ハウル(howl)を知っていて確信を持っていたために、howlとhouseのスペリング的な観点からの類似性?に着目してしまっているようでした。

しかし、howlを単純にラベルに追加すると「映画の略称としてのハウル」も含めてしまうようになるので、ハウル(人)が写っていなくても映画のタイトルが写っている画面やポスターに使われる場面、スタッフロール!などもhowlとして認識されるようになってしまい、テキストプロンプトエンジニアリングって、かなり専門性が求められるようになる可能性があるな、と実感しました。GPT-3を最も上手に使いこなせている人はコミュニケーション能力が高い人、という話は納得感があります。