1.The Impact Lab:Googleの責任あるAI(2/2)まとめ

・EARRはAI技術に関連する公平性や脆弱性をどのように概念化するかについて重要な視点とフィードバックを提供してきた

・データ分析をする際は属性間の相関や関係が原因や結果を意味するものではないことを注意深く理解することが必要

・教育から医療まで様々な場面でのMLの利用が不公平を悪化させた例は無数にあるので社会的、歴史的背景の理解が重要

2.The Impact Labの取り組み

以下、ai.googleblog.comよりResponsible AI at Google Research: The Impact Labの意訳です。元記事は2023年3月16日、Jamila Smith-LoudさんとResponsible AI and Human-Centered Technology Teamによる投稿です。

アイキャッチ画像はchatGPT先生に伝えて作って貰ったプロンプトを私が修正してカスタムStable Diffusion先生に作って貰ったイラスト

ある程度構造化されたワークショップ(semi-structured workshops)やディスカッションを通じて、EARRはAI技術に関連する公平性や脆弱性をどのように概念化するかについて、重要な視点とフィードバックを提供してきました。

私たちは、生成AI、アルゴリズムによる意思決定、透明性、説明可能性など、さまざまなテーマでEARRの貢献者と協力し、敵対的な検索分からフレームワークやケーススタディまで、幅広いアウトプットを提供してきました。確かに、分野を超えた研究の洞察を技術的なソリューションに変換するプロセスは必ずしも容易ではありませんが、この研究は実りあるパートナーシップとなっています。論文「The Equitable AI Research Roundtable (EARR): Towards Community-Based Decision Making in Responsible AI Development」では、このパートナーシップの初期評価を紹介しています。

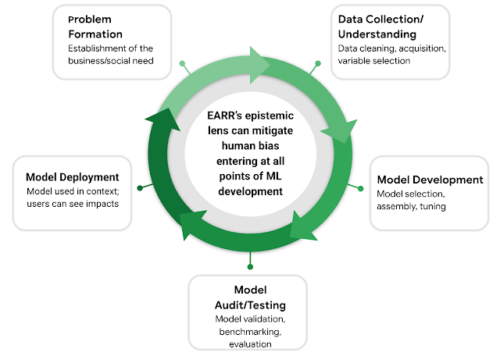

EARR:ML開発ライフサイクルの中で、人間の偏見を軽減するために、分野の枠組みを超えた学際的な知識が鍵となります。

市民的・人権的価値観に根ざす

市民権・人権プログラムとの連携により、私たちの調査・分析プロセスは、世界人権宣言や国連ビジネスと人権に関する指導原則など、国際的に認められた人権の枠組みや基準に基づいたものとなっています。

市民権と人権の枠組みを出発点として活用することで、技術がどのように展開され、地域社会にどのような影響を与えるかを考慮した、状況に応じた研究アプローチが可能になります。最も重要なことは、権利に基づく研究アプローチにより、日々の意思決定、製品設計、長期戦略により良い情報を提供するために、最も脆弱なユーザーと最も顕著な害を理解することの重要性を強調する概念的および応用的方法を優先することができることです。

現在進行中の作業

データセットの開発・評価に役立つ社会的文脈

私たちは、データセットの収集、モデル開発、評価において、公平性に根ざしたアプローチを採用し、不完全なデータの利用やデータセットに関連する歴史的・社会的文化的要因を考慮しないなど、迅速であるが潜在的にリスクの高いアプローチを避けることを目指しています。

責任あるデータ収集と分析には、データが作成された背景をさらに慎重に考慮することが必要です。

例えば、モデルを構築するために使用される人口属性によって結果に違いが見られることがありますが、いくつかの属性は最終的に歴史的、社会的、政治的な要因の反映である可能性があるため、構造的およびシステムレベルの要因が作用していることを疑う必要があります。

人種や民族、性別、郵便番号などの代理データを使うことで、多様な人々全体の生きた経験を体系的に融合させてしまう事に繋がり、集団全体で有害で不正確な人物像を再現・維持してしまうモデルの学習を引き起こすのです。

重大なデータ分析をする際には、属性間の相関や関係が原因や結果を意味するものではないことを注意深く理解することも必要です。私たちが目撃する関連性は、しばしばデータ追加された複数の属性によって引き起こされます。

社会的背景とモデルの出力の関係

このようにデータやデータセットの構築に関するニュアンスを拡大し、その社会的理解を基に、私達はMLモデルが実世界で使用されるようになった後の影響を予測したり改善したりする問題にもアプローチします。

教育から医療まで、様々な文脈でのMLの利用が、既存の不公平を悪化させた例は無数にあります。それは、これらのシステムの開発者や意思決定者が、関連する社会的理解や歴史的背景を持たず、関連する利害関係者を巻き込まなかったからです。これは、ML分野全般の研究課題であり、私たちのチームにとっても中心的な課題です。

世界的に責任のあるAIを中心としたコミュニティの専門家

私たちのチームは、社会技術的な背景をグローバルに理解することの重要性も認識しています。「世界中の情報を整理し、普遍的にアクセス可能で有用なものにする」というGoogleのミッションに沿って、私たちのチームはグローバルに研究パートナーシップを結んでいます。例えば、ウガンダのマケレレ人工知能研究所の自然言語処理チームや人間中心チームと協力し、言語モデル開発に関連する文化や言語のニュアンスについて研究しています。

結論

私たちは、社会技術的な研究をさらに進め、歴史的・世界的に権利を奪われたコミュニティの一員でもある外部の専門家を巻き込んで、実世界に展開されたMLモデルの影響に取り組み続けています。

インパクトラボは、社会科学、評価、人権の認識論を活用することで、応用問題の解決策の開発に貢献するアプローチを提供できることを嬉しく思っています。

謝辞

Impact Labチームの各メンバーに感謝します。Jamila Smith-Loud、Andrew Smart、Jalon Hall、Darlene Neal、Amber Ebinama、Qazi Mamunur Rashid。MLがコミュニティや世界中のユーザーや社会に対してより責任あるものであることを保証するために、彼らが行っているすべてのハードワークに感謝します。

3.The Impact Lab:Googleの責任あるAI(2/2)関連リンク

1)ai.googleblog.com

Responsible AI at Google Research: The Impact Lab