1.FRMT:複数地域で使われる共通言語の微妙な差異を扱う能力を測る機械翻訳用ベンチマーク(2/2)まとめ

・各地域の専門家である注釈付け作業者が、MQMフレームワークを用いて、翻訳の誤りを分類した所、地域間の言語差異が補足できていた

・人間の評価者の判断と最も相関があった自動評価指標はBLEURTであり注釈者間の整合性と同等であることがわかった

・PaLMは流暢な翻訳に必要な地域特有の単語の選択肢を記憶する事が出来ている可能性があるが人間との間には、まだ大きなギャップがあった

2.FMRTの性能

以下、ai.googleblog.comより「FRMT: A benchmark for few-shot region-aware machine translation」の意訳です。元記事は2023年2月17日、Parker RileyさんとJan Bothaさんによる投稿です。

アイキャッチ画像はstable diffusionのカスタムモデルによる生成

評価方法

FRMTデータセットで収集された翻訳が地域固有の違いを捉えていることを確認するため、その品質について人手による評価を実施しました。

各地域の専門家である注釈付け作業者が、MQM(Multi-dimensional Quality Metrics)フレームワークを用いて、翻訳の誤りを特定し、分類しました。このフレームワークには、特定されたエラーをカテゴリー毎に重み付けするスキームが含まれており、1文あたりの主要なエラーの数をほぼ表す1つのスコアに変換されます。

地域ごとに、MQMの評価者に、特定地域の言語の翻訳と、その言語の他の地域の翻訳の両方を採点するよう依頼しました。例えば、ブラジル・ポルトガル語の評価者は、ブラジル・ポルトガル語の翻訳とヨーロッパ・ポルトガル語の翻訳の両方を採点しました。

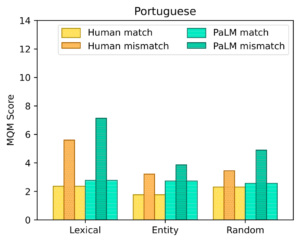

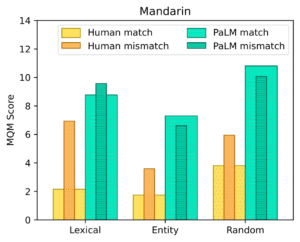

この2つの点数の差は、ある地域言語では受け入れられても、他の言語は受け入れられない言語現象(linguistic phenomena)が存在することを示します。ポルトガル語と中国語の両方で、評価者は、不一致の翻訳では、一致した翻訳よりも、1文あたり平均で約2つ多く主要なエラーを特定することがわかりました。このことは、このデータセットが地域特有の現象を捉えていることを示しています。

モデルの品質を確認する際に最も良い方法は、人間が評価する事ですが、多くの場合、時間と費用がかかります。そこで、研究者が私達のベンチマークでモデルを評価するために使用できる既存の自動指標を見つけたいと考え、chrF、BLEU、およびBLEURTを検討しました。MQMの評価者によって評価されたいくつかの比較対象モデルの翻訳を使用したところ、BLEURTが人間の判断と最も相関があり、その相関の強さ(ピアソン相関係数ρ)が、注釈者間の整合性(クラス内相関0.70)と同等であることを発見しました。

| Metric | Pearson’s ρ |

| chrF | 0.48 |

| BLEU | 0.58 |

| BLEURT | 0.65 |

FRMTのサブセットにおける、さまざまな自動評価指標と人間による翻訳品質の判断との間の相関。値は-1~1で、高いほど良い事を意味します。

システム性能

今回の評価では、小数事例による制御が可能な最近のモデルを対象としました。MQMを用いた人間による評価では、ベースライン方式はいずれもポルトガル語についてはある程度のローカライズ能力を示しましたが、中国語については、対象地域の知識を利用して本土や台湾の優れた翻訳を生成することができない場合がほとんどでした。

Googleの最近の言語モデルであるPaLMは、今回評価したモデルの中で総合的に最も優れていると評価されました。PaLMで地域をターゲットにした翻訳を行うには、指示的なプロンプトをモデルに入力し、そこからテキストを生成して空欄を埋めます。(下図の例を参照ください)。

English: [English example 1].

European Portuguese: [correct translation 1].

…

English: [input].

European Portuguese: _____”

PaLMは、1つの事例を与える事で強力な結果を得ており、10個に事例に増やすと、ポルトガル語の品質がわずかに向上しました。この結果は、PaLMが教師なし学習であることを考慮すると、印象的な結果です。

この結果は、PaLMのような言語モデルが、流暢な翻訳に必要な地域特有の単語の選択肢を記憶することに特に長けている可能性を示唆しています。しかし、PaLMと人間のパフォーマンスとの間には、まだ大きなギャップがあります。詳しくは論文をご覧ください。

人間とPaLMの翻訳のデータセットバケット別MQMパフォーマンス

太い棒は地域が一致する場合を表し、各地域の評価者が自分の地域を対象とした翻訳を評価した場合です。細い棒は、地域が不一致の場合を表し、各地域ンの評価者が他の地域を対象とした翻訳を評価した場合です。人間の翻訳では、すべてのケースで地域現象が見られます。PaLM翻訳では、すべてのポルトガル語バケットと北京語の語彙バケットのみで、地域現象が見られます。

結論

近い将来、言語生成システム、特に機械翻訳が、すべての話者のコミュニティをサポートできるような世界を実現したいと考えています。私たちは、ユーザーが今いる場所で、その土地や地域に適した流暢な言語を生成することを望んでいます。

そのために、FRMTデータセットとベンチマークを公開し、研究者が地域を考慮したMTモデルのパフォーマンスを簡単に比較できるようにしました。FRMTに収録されている言語には、地域を考慮したMTモデルの出力に反映されるべき大きな違いがあることが、徹底した人間評価研究によって検証されています。本ベンチマークを活用し、自然言語技術における公平性の向上につながるような、代表性の低い言語種やすべての話者コミュニティをサポートする新しいMTモデルの開発に、研究者がどのように取り組むか楽しみにしています。

謝辞

このプロジェクトに貢献してくれた論文共著者に感謝します。Timothy Dozat, Xavier Garcia, Dan Garrette, Jason Riesa, Orhan Firat, そして Noah Constant。論文に関する有益な議論とコメントを頂いたJacob Eisenstein、Noah Fiedel、Macduff Hughes、Mingfei Lauに感謝します。

地域による言語の違いに関する重要なフィードバックについては、Andre Araujo、Chung-Ching Chang、Andreia Cunha、Filipe Gonçalves、Nuno Guerreiro、Mandy Guo、Luis Miranda、Vitor Rodrigues、Linting Xueに感謝します。

人力による翻訳と評価を集めるための後方支援については、Google翻訳チームに感謝します。データセットを作成する上で役割を果たしたプロの翻訳者とMQM評価者に感謝します。また、この記事でアニメーションを提供してくれたTom Smallに感謝します。

3.FRMT:複数地域で使われる共通言語の微妙な差異を扱う能力を測る機械翻訳用ベンチマーク(2/2)関連リンク

1)ai.googleblog.com

FRMT: A benchmark for few-shot region-aware machine translation

2)arxiv.org

FRMT: A Benchmark for Few-Shot Region-Aware Machine Translation

3)github.com

google-research/frmt/

4)research.google

Few-shot Regional Machine Translation