1.iGibson Challenge:ロボットは人の邪魔にならないように建物内を移動出来るのか?(1/2)まとめ

・最近のコンピュータービジョン研究は動きのあるアクティブタスクの解決に取り組んでいる

・これらは知覚とアクションの両方を必要とするためembodied AIと呼ばれる事が多い

・第二回Embodied AI Workshopはロボットが人や物との相互作用を学習出来るかを競うコンペ

2.Embodied AIとは?

以下、ai.googleblog.comより「Presenting the iGibson Challenge on Interactive and Social Navigation」の意訳です。元記事の投稿は2021年4月14日、Anthony FrancisさんとAlexander Toshevさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Philippa Rose-Tite on Unsplash

画像分類用のImageNetや物体検出用のCOCOなど、モデルを評価するための膨大なデータセットと評価基準を提供する大規模なベンチマークのおかげで、コンピュータービジョンは過去10年間で大幅に進歩しました。ただし、これらの従来のベンチマークは、知覚のみに重点が置かれ、動きのない「パッシブタスク(passive tasks)」を評価していました。最近のコンピュータービジョンの研究では、知覚とアクションの両方を必要とする、動きのある「アクティブタスク(active tasks)」に取り組んでおり、これらは「具体化されたAI(embodied AI)」と呼ばれる事が多いです。

GoogleがCVPR2020で共催したFirst Embodied AI Workshopは、スタンフォード大学等とGoogleが共同で開催したiGibsonやSim2Realなどのチャレンジでは、アクティブなタスクに関するいくつかのベンチマークチャレンジを主催しました。

これは、写真のようにリアルな描写のシミュレーション環境でトレーニングされた案内用ポリシーをテストするための現実世界のセットアップ環境を提供しました。

チャレンジでのオープンソースのセットアップにより、コミュニティはシミュレーションでポリシーをトレーニングすることができ、それを繰り返し可能な実世界のナビゲーション実験で実行して、「シミュレーションと現実世界のギャップ(sim-to-real gap)」の評価を可能にしました。

多くの研究チームがパンデミック中に解決策を提出しました。そして、実際のロボットは組織委員会によって安全に取り扱いされ、勝者はワークショップで結果をバーチャル空間で発表しました。

今年、スタンフォード大学とGoogleは、インタラクティブおよびソーシャルナビゲーションに関するiGibsonチャレンジの新しいバージョンを発表できることを誇りに思います。これは、CVPR2021での第2回具体化されたAIワークショップ(Second Embodied AI Workshop)に関連する10のアクティブな視覚的チャレンジの1つです。

今年のEmbodied AI Workshopは、Googleと他の9つの研究機関が共同で開催し、シミュレーション、シミュレーションから現実世界への転移、視覚的ナビゲーション、セマンティックマッピングと変化の検出、物体の再配置と復元、聴覚的ナビゲーション、および案内指示に従う能力、対話タスクなどの問題を調査します。

更に、今年の「インタラクティブでソーシャルなiGibsonチャレンジ(interactive and social iGibson challenge)」では、インタラクティブナビゲーションとソーシャルナビゲーションについて説明します。

「これは、ロボットが環境内の人や物と相互作用することをどのように学習する事ができるか?」を試すチャレンジで、iGibsonシミュレーター、Google Scanned Objects Dataset、およびシミュレートされた歩行者を現実的な人間社会の環境として組み合わせることによって行われます。

案内の新しい課題

アクティブな知覚タスクは挑戦的な課題です。必要に応じて知覚と行動の両方を必要とするためです。

例えば、ポイントナビゲーションでは、人間に負担をかけないように設計された建物内でロボットを数キロメートルにわたって運転するなど、地図で与えられた空間を障害物を認識して回避しながら、案内する事が含まれます。

同様に、物体ナビゲーションには、建物内の物体の検索が含まれ、視点が変更されても不変の特徴表現と物体検索動作が必要です。更に、視覚言語指示ナビゲーション(visual language instruction navigation)には、自然言語の視覚画像とコマンドに基づいて建物内を案内する事が含まれます。これらの問題は、ロボットがはるかに動的で解決が難しいさまざまな物理的および社会的相互作用を処理できなければならない現実の環境では更に困難になります。 今年のiGibsonチャレンジでは、次の2つの設定に焦点を当てます。

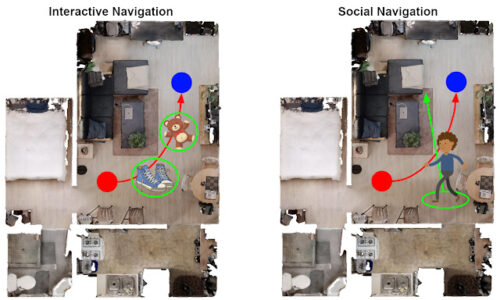

(1)インタラクティブナビゲーション(Interactive Navigation)

雑然とした環境では、目標に向かうエージェントは、成功するために物体と物理的に対話する必要があります。例えば、エージェントは靴は横に押しのける事ができますが、サイドテーブルは動かしてはならず、ソファは動かせないことを認識する必要があります。

(2)ソーシャルナビゲーション(Social Navigation)

人々も動き回っている混雑した環境では、目標に向かうエージェントは、できるだけ混乱を少なくして、存在する人々の周りを丁寧に移動する必要があります。

3.iGibson Challenge:ロボットは人の邪魔にならないように建物内を移動出来るのか?(1/2)関連リンク

1)ai.googleblog.com

Presenting the iGibson Challenge on Interactive and Social Navigation

2)svl.stanford.edu

iGibson Challenge 2021