1.URL2Video:Webページから自動でビデオを作成する実験(2/2)まとめ

・簡潔な情報提供と元ページと一致したデザインを目標としてビデオが作成されている

・経験則的な設計思想に従って、個々の場面の資産提示時間及び空間的配置が決定される

・今後はオーディオとナレーションをサポートする新しい技術を開発していく予定

2.URL2Videoのデモ

以下、ai.googleblog.comより「Experimenting with Automatic Video Creation from a Web Page」の意訳です。元記事の投稿は2020年10月29日、Peggy ChiさんとIrfan Essaさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by JESHOOTS.COM on Unsplash

制約ベースの資産選択

ビデオを作成するときは、2つの目標を考慮します。

(1)ビデオの各場面は簡潔な情報を提供する必要があります。

(2)ビジュアルデザインは元ページと一致している必要があります。

これらの目標と、意図したビデオの長さ(秒単位)や縦横比(通常は16:9、4:3、1:1など)など、ユーザーが提供するビデオの制約に基づいて、URL2Videoは、資産グループを自動的に選択して順序付けし、合計優先度スコアを最適化します。

コンテンツを簡潔にするために、見出しやいくつかのマルチメディア資産など、ページの主要な要素のみを表示します。視聴者がコンテンツを知覚できるように、各視覚要素の持続時間を制限します。このように、短いビデオではページの上部から最も重要な情報が強調表示され、長いビデオにはより多くのキャンペーンや製品が含まれます。

シーンの構成とビデオのレンダリング

DOM階層に基づいて資産の順序付きリストが与えられると、URL2Videoはインタビュー調査から得られた経験則的な設計思想に従って、個々の場面で資産を提示するための時間的および空間的配置の両方について決定を下します。各要素のグラフィックレイアウトをビデオの縦横比に転送し、フォントや色などのスタイルの選択を適用します。ビデオをよりダイナミックで魅力的なものにするために、資産の表示タイミングを調整します。最後に、コンテンツをMPEG-4コンテナ形式のビデオにレンダリングします。

ユーザーコントロール

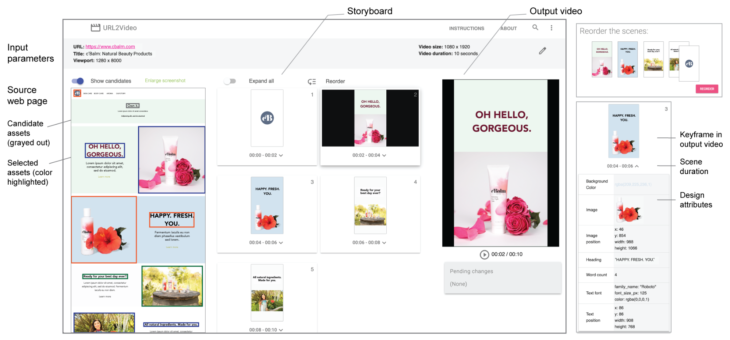

研究段階の試作品のインターフェースでは、ユーザーは元ページから抽出された各ビデオショットのデザイン属性を確認し、素材を並べ替え、色やフォントなどの詳細なデザインを変更し、制約を調整して新しいビデオを生成できます。

URL2Videoの設定画面(左)で、ユーザーは元ページへのURL、ターゲットページビューのサイズ、および出力ビデオのパラメーターを指定します。URL2Videoは、Webページを分析し、主要なビジュアルコンポーネントを抽出します。一連のシーンを構成し、キーフレームをストーリーボードとして視覚化します。

これらのコンポーネントは、入力の時間的および空間的制約を満たす出力ビデオに構成されます。ユーザーは、ビデオを再生し、デザイン属性を調べ(右下)、シーンの並べ替えなどのビデオバリエーションを生成するための調整を行うことができます(右上)。

URL2Videoの使用例

様々な既存のWebページに直接URL2Videoを実行した際のパフォーマンスを示します。

以下は、URL2Videoが複数の短いビデオクリップが埋め込まれたページを12秒のビデオ出力に変換する例を示します。URL2Videoがソースページ内で捕捉されたビデオのフォントと色の選択、タイミング、およびコンテンツの順序について自動編集決定を行う方法に注意してください。

URL2Videoは、見出しや動画コンテンツなど、Google検索の紹介ページ(上図)から重要なコンテンツを識別します。プレゼンテーションフロー、ソースデザイン、出力の制約を考慮して、それらをビデオに変換します。(下図:12秒の横向きビデオ)。

以下のビデオで更なるデモンストレーションを見る事ができます。

自動生成された動画を評価するために、Googleのデザイナーと共にユーザー調査を実施しました。

私達の調査結果は、URL2Videoにビデオ作成プロセスの一部を自動抽出させる事により、Webページからデザイン要素を効果的に抽出し、デザイナーをサポート出来ている事を示しています。

次のステップ

この現在の研究は視覚的表現に焦点を当てていますが、ビデオ編集時にオーディオとナレーションをサポートする新しい技術を開発しています。全体として目指している事は、クリエイターが高レベルの意思決定に集中し、MLモデルが複数のプラットフォームに対応した動画を自動で作成できるようにし、時間的およびグラフィック編集を詳細に操作可能な形で提案する未来を想定しています。

謝辞

論文の共著者であるZhengSun(Research)とKatrina Panovich(YouTube)に心から感謝します。また、URL2Videoに貢献してくれた同僚にも感謝します。(以下、姓のアルファベット順)

Jordan Canedy、 Brian Curless、 Nathan Frey、 Madison Le、 Alireza Mahdian、 Justin Parra、 Emily Ryan、 Mogan Shieh、 Sandor Szego、 そして Weilong Yang。

リーダーシップを発揮し、サポートをしてくれたTomasIzo、Rahul Sukthankar、JayYagnikに感謝します。

3.URL2Video:Webページから自動でビデオを作成する実験(2/2)関連リンク

1)ai.googleblog.com

Experimenting with Automatic Video Creation from a Web Page

2)research.google

Automatic Video Creation From a Web Page

3)material.io

Accessibility