1.グラフニューラルネットワークのわかりやすい紹介(3/3)まとめ

・GNNにAttentionを加えるのは容易でTransformerと同じものを利用可能

・GNNはグラフ上に存在しグラフ上で動作するディープラーニングにすぎない

・様々な構築手法があるが「近隣集約」と「状態更新」の基本的な手順は同じ

2.GNNの次に来るもの

以下、www.kdnuggets.comより「A Friendly Introduction to Graph Neural Networks」の意訳です。元記事の投稿は2020年11月、Kevin Vuさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by NASA on Unsplash

グラフニューラルネットワーク(GNN)の次は何が来るのでしょうか?

Attentionは、機械学習モデルに「様々な入力に様々な重みを割り当てる方法」を学習する機能を提供する概念です。言い換えると、モデルが重要な情報に注意(Attention)を払う事が出来る仕組みです。

この分野での最近の独創的な研究の例として、Vaswani等による「Attention is All You Need」を上げる事ができます。この論文では、Attentionのみを使ったTransformerを全てを実行可能な言語モデルと断定しています。これは、近年、自然言語研究を支配するBERTやGPT-3などの大規模なTransformerモデルが開発された事によってほぼ事実となっています。

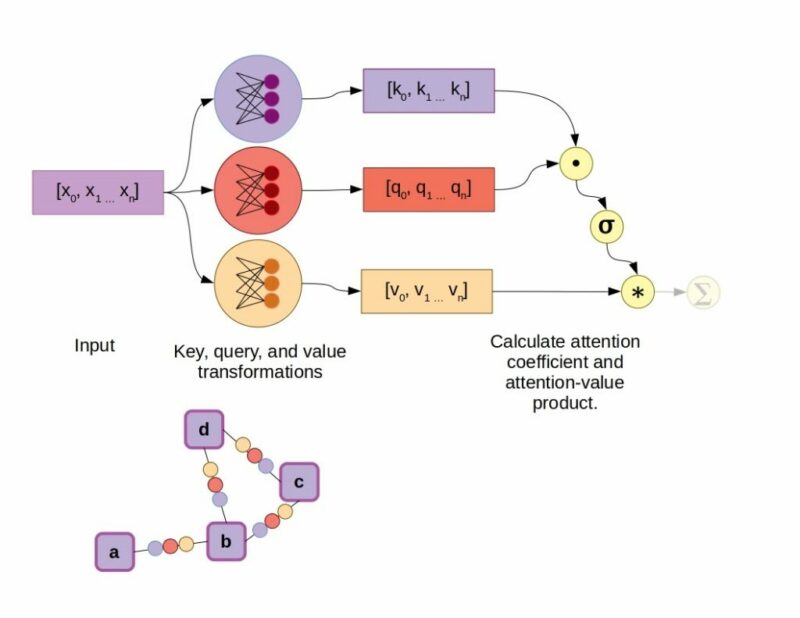

前半に説明した既存のGNNアルゴリズムにAttentionを加えるのは、かなり簡単です。近隣集約中に、エッジで構成されるフィードフォワードネットワークを介して隣接ノードの状態を変換することに加えて、ベクトルの重み係数を計算するためのAttentionメカニズムを含めます。

元のTransformerモデルで使用されていた内積(dot-product)Attentionなど、いくつかのAttentionメカニズムが利用可能であり、Jay Allamarによっても示されています。

このやり方では、完全接続されたレイヤーは、各入力の値ベクトルに加えて、キーとクエリのベクトルを生成します。この場合、値ベクトルはグラフのエッジによってノードに接続されます。

キーベクトルとクエリベクトルの内積を取ると、スカラー定数が生成されます。この定数は、グラフ近傍の他の全てのキーとクエリの内積と共にソフトマックス活性化関数の対象になります(これはraw attention coefficients、生のAttention係数として知られています)。

最後に、全ての値ベクトルを直接合計する代わりに、最初にAttention係数によって重み付けします。

内積Attentionメカニズムを使用したGraph Attention Networkの例

この場合、σはソフトマックス関数を表します。

量子グラフニューラルネットワーク

量子化学について推論する場合、GNNのニューラルネットワークを仮説または量子回路アーキテクチャとして定義すると、モデルを予測および学習しているシステムに更に近づけることができます。

量子グラフニューラルネットワーク(QGNNs:Quantum Graph Neural Networks)は、Verdon等によって2019年に紹介されました。著者は更に、彼らの研究を2つの異なるクラスに細分しました。量子グラフリカレントニューラルネットワーク(quantum graph recurrent neural networks)と量子グラフ畳み込みネットワーク(quantum graph convolutional networks)です。

QGNNで使用される特定のタイプの量子回路は、「変分量子アルゴリズム(variational quantum algorithms)」のカテゴリに分類されます。要するに、これらは勾配降下法によって訓練できるパラメータを備えた量子回路であり、これらの訓練可能なパラメータは、量子回路において重みとバイアスに相当するものです。

変分量子アルゴリズム/回路のトレーニングにおける既知の問題は、「不毛な台地(barren plateaus)」の存在です。これは、勾配がほとんどないため学習があまり進展しない領域です。QGNNは、不毛な台地の存在を改善するために、変分量子回路に構造情報を与える手段として考案されました。Verdon等は、量子ダイナミクス、グラフクラスタリング、およびグラフ同型分類の学習に適用されるQGNNを実証しました。

ニューラルネットワークはグラフニューラルネットワークに置き換わりますか?

データセットをグラフに変換し、全てのニューラルネットワークをグラフニューラルネットワーク(GNNs)に置き換える必要があるのでしょうか?

答えは、もちろん、貴方の抱えている問題がグラフに適合するかによって異なります。

線形または二次元でより適切に表現出来るデータセットを強制的にグラフに適合させても、実装がより困難になり、トレーニングが遅くなるだけです。GNNは、今後数年間、分子を対象とした機械学習の主要なモデルタイプになるように見えます。従って、計算化学で作業する場合は、知っておくべき重要なツールです。それは新薬の発見と開発効率を2倍にします。

GNNは、ソーシャルメディアの関係性や、グラフとして自然に表現できる他のタイプの関係ネットワークにも適しているようです。

GNNは画像および自然言語に間するタスクにも使用されてきましたが、transformerと古いが信頼性の高い畳み込みネットワークは、今のところこれらの領域をかなりカバーしているようです。

最後に、GNNは、ディープラーニングニューラルネットワークを「古き良きAI(GOFAI:Good Old-Fashioned AI)」と組み合わせて説得力のあるフレームワークを作成する可能性もあります。

これは、ニューラルシンボリックAIに関するJCAI調査論文でレビューされたトピックです。このハイブリッドアプローチは、全体的な柔軟性をいくらか犠牲にして、解釈可能性と制御の点でいくつかの利点を提供する可能性があります。

GNNを未来にもたらす

グラフニューラルネットワークについて聞いたことがあっても、その複雑さに学習を先送りしていた場合は、この記事がその最初のハードルを克服するのに役立つことを願っています。GNNは、グラフ上に存在し、グラフ上で動作するディープラーニングモデルにすぎないことを忘れないでください。

構築手法には十分な柔軟性がありますが、それらは全て、「近隣集約」とそれに続く「状態更新」と言う2つの基本的な手順を共有しています。

GNNの世界に飛び込む前に注目に値する商業的成功を見たいと待っていたのなら、今後数年間における計算化学と創薬に対する影響以上のものを探す必要はありません。GNNは精通する事に価値のあるモデルです。そして、今後10年の間に、ますます魅力と影響力が高まっていくでしょう。

3.グラフニューラルネットワークのわかりやすい紹介(3/3)関連リンク

1)www.kdnuggets.com

A Friendly Introduction to Graph Neural Networks

2)blog.exxactcorp.com

5 Types of LSTM Recurrent Neural Networks and What to Do With Them