1.DVRL:強化学習を使って学習用データの影響を推定(1/2)まとめ

・全てのデータサンプルがディープラーニングを学習させる際に等しく役立つわけではない

・低品質データを削除することでパフォーマンスを向上させる事が出来る場合もある

・DVRLは強化学習を使用してデータの価値を定量化し最も価値のデータを推定する手法

2.DVRLとは?

以下、ai.googleblog.comより「Estimating the Impact of Training Data with Reinforcement Learning」の意訳です。元記事の投稿は2020年10月28日、Jinsung YoonさんとSercan O. Arikさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Leslie Jones on Unsplash

最近の研究では、全てのデータサンプルがトレーニング、特にディープニューラルネットワーク(DNN)に等しく役立つわけではないことが示唆されています。

実際、データセットに低品質または誤ってラベル付けされたデータが含まれている場合、トレーニングサンプルのかなりの部分を削除することでパフォーマンスを向上させることができます。

更に、学習時に利用するデータとテスト時に利用するデータの間に不一致がある場合(例えば、学習とテストが行われる場所または時間が違うなど)、学習セット内のサンプルデータをテストシナリオに最も関連性の高いサンプルデータだけに慎重に制限することで、より高いパフォーマンスを実現する事もできます。

これらのテストシナリオは広く普及しているため、学習時に使うトレーニングサンプルの値を正確に定量化することは、現実世界のデータセットでモデルのパフォーマンスを向上させる手法として、大きな可能性を秘めています。

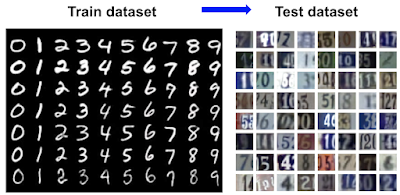

上:低品質なサンプルの例(間違った画像が多い/クラウドソーシングで収集)

下:学習データとテストデータの不一致の例

個々のデータに品質値を割り当てる事は、モデルのパフォーマンスを向上させるだけでなく、新しい用途で使う事ができます。

例えば、データ収集のより良い方法を提案するために使用できます。どのような種類の追加データが最も有益であるか、大規模なトレーニングデータセットをより効率的に構築するために使用できます。他にも、ラベルをキーワードとして使用してWeb検索を行い、価値の低いデータを除外する事などもできます。

ICML 2020で受理された論文「Data Valuation Using Deep Reinforcement Learning」では、メタラーニングに基づく新しいアプローチを使用して、トレーニングデータの価値を定量化するという課題に取り組みます。

私達の方法は、データ評価を予測モデルのトレーニング手順に統合します。予測モデルは、特定のタスクにとってより価値のあるサンプルを認識することを学習し、予測とデータ評価のパフォーマンスを両方向上させます。

また、DVRLの使用例を例示し、ドメイン適応(domain adaptation)、破損したサンプルの発見、堅牢な学習(robust learning)、画像データとデータ評価用の転移学習、など、他のタスクやデータセットに便利に適応するように設計された4つのAI Hub Notebooksを公開しました。

データの価値を定量化

全てのMLモデルで全てのデータが等しい価値を持つわけではありません。いくつかのデータは、やろうとしているタスクと関連性が高いか、他のデータよりも有益なコンテンツが豊富です。

では、単一のデータの値をどのようにして評価すれば良いのでしょうか?

完全なデータセットの単位で考えるならば、それは簡単です。データセット全体でモデルをトレーニングし、テストセットでのパフォーマンスを値として使用するだけです。

ただし、単一のデータの値を推定することは、特に大規模なデータセットに依存する複雑なモデルの場合、考えられる全てのサブセットでモデルを再トレーニングおよび再評価する事は計算機資源の制約上実行不可能であるため、はるかに困難です。

これに取り組むために、研究者は順列ベースの方法(例:influence functions、個々のデータの有無が予測に与える影響を関数化する試み)とゲーム理論ベースの方法(例:Data Shapley、データポイントの価値を表す評価指標)を調査しました。

ただし、現在の最良の方法でさえ、大規模なデータセットや複雑なモデルに対して計算上実行可能とはほど遠いものであり、それらのデータ評価パフォーマンスには制限があります。

同時に、メタ目的を使用して重み値を推定するために、メタ学習ベースの重み割り当てアプローチが開発されました。

ただし、価値が高いデータサンプルからの学習を優先するのではなく、それらのデータ値の割り当ては通常、勾配降下学習またはその他のヒューリスティックアプローチに基づいています。

これにより、従来の予測モデルのトレーニング過程が変更され、個々のデータポイントの値とは関係のないパフォーマンスの変化が発生する可能性があります。

DVRL:強化学習を使用したデータ評価

データ値を推測するために、データ値を推定し予測モデルをトレーニングするために最も価値のあるサンプルを選択するデータ値推定器(DVE:Data Value Estimator)を提案します。

最も価値のあるサンプルを選択する操作は基本的に微分不可能であるため、従来の最急降下法に基づく方法は使用できません。

代わりに、DVEの教師に強化学習(RL:Reinforcement Learning)を使用する事を提案します。強化学習の報酬は、小さな(しかしクリーンな)検証セットでの予測のパフォーマンスを定量化したものを利用します。

報酬は、状態とサンプルデータが与えられた際に、最適なデータ評価を行うようにポリシーを仕向けます。

ここでは、予測モデルの学習と評価のフレームワークを環境として扱います。これは強化学習支援機械学習の新しい応用シナリオです。

強化学習(DVRL)を使用したデータ値推定トレーニング

精度を報酬としてデータ値推定器をトレーニングする場合、最も価値の高いサンプル(緑点で示されています)がより沢山使用されますが、最も価値の低いサンプル(赤点)はあまり使用されません。

3.DVRL:強化学習を使って学習用データの影響を推定(1/2)関連リンク

1)ai.googleblog.com

Estimating the Impact of Training Data with Reinforcement Learning

2)proceedings.icml.cc

Data Valuation using Reinforcement Learning(PDF)

3)aihub.cloud.google.com

Domain Adaptation using DVRL

Corrupted Sample Discovery & Robust Learning using DVRL

Robust Transfer Learning on Image Data with DVRL

Data Valuation using DVRL