1.KeyPose:ステレオ画像で透明物体の三次元ポーズ推定を更に改良(1/2)まとめ

・透明な物体に対しては既存の深度センサーはうまく機能せず距離が測定できない

・以前紹介したClearGraspはニューラルネットで深度センサーの出力した情報を修復する手法

・KeyPoseはステレオ画像から三次元のキーポイントを直接予測して透明な物体の深度を推定

2.KeyPoseとは?

以下、ai.googleblog.comより「KeyPose: Estimating the 3D Pose of Transparent Objects from Stereo」の意訳です。元記事の投稿は2020年9月2日、Kurt Konoligeさんによる投稿です。

透明な物体を認識可能なアルゴリズムとしてはClearGraspが既に紹介されていますが、今回はステレオ画像を利用する事によりもっと精度を上げた手法のお話です。それと、まぁ、少し前から感じていましたが「ラベル付きデータが不足しているならロボットを使って好きなだけ撮影すれば良いじゃない時代」が到来した事を感じます。

アイキャッチ画像のクレジットはPhoto by Markus Spiske on Unsplash

三次元物体の位置と方向を推定することは、拡張現実(AR:Augmented Reality)やロボット操作などの物体単位での知覚を必要とするコンピュータビジョンアプリケーションの中心的な問題の1つです。

これらのアプリケーションでは、環境内の物体の三次元位置を知ることが重要です。これにより、物体に直接影響を与えたり、物体の周辺に正確に実験体を配置する事などが出来ます。

機械学習(ML:Machine Learning)技術、特にディープネットを使用してこのトピックについて多くの研究が行われてきました。しかし、ほとんどの場合、物体までの距離を直接測定するMicrosoft社のKinectなどの深度センサー搭載デバイスに依存してきました。

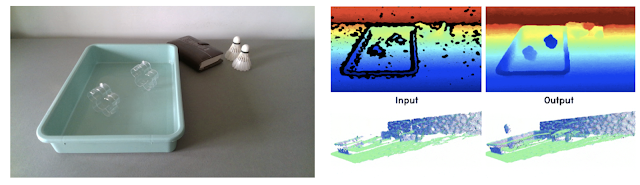

しかし、光沢のある物体や透明な物体に対しては、これらの直接深度を検出するセンサーはうまく機能しません。例えば、下図にはいくつかの物体(左)が含まれており、そのうち2つは透明な星型物体です。深度デバイスは、星型物体への適切な深度値を見つけられず、実際の三次元再構成が非常に貧弱になります(右)。

左図:透明な物体のRGBイメージ

右図:左図の再構成された深度を示す4つのパネル画像。

上段には深度画像、下段は三次元の点群が表示されています。

左側のパネルは深度カメラを使用して再構築されたもので、右側のパネルはClearGraspモデルからの出力です。ClearGraspは星の深さ情報を修復していますが、一番右の星型物体の実際の深さを間違えていることに注目してください。

ClearGraspによって提案されたこの問題の1つの解決策は、ディープニューラルネットワークを使用して、透明な物体の破損した深度マップを修復することです。ClearGraspは、透明なオブジェクトの単一のRGB-D画像が与えられると、深い畳み込みネットワークを使用して、面法線(surface normals)、透明な物体の表面形状を示すマスク、およびオクルージョン境界(occlusion boundaries)を推測します。これらを使用して、風景内の全ての透明な物体のセンサーによる表面形状の初期深度推定を修復します(上の図の右端)。

このアプローチは非常に有望であり、透明な物体を含む風景を、深度情報に依存するポーズ推定アルゴリズムで処理する事が出来るようになります。ただし、特に合成画像を使ってトレーニングされている場合、修復はトリッキーになる可能性があり、更に深度情報にエラーが発生する可能性があります。

CVPR 2020でスタンフォードAIラボと共同で発表した論文「KeyPose: Multi-View 3D Labeling and Keypoint Estimation for Transparent Objects」では、三次元のキーポイント(3D keypoints)を直接予測することで透明な物体の深度を推定するMLシステムについて説明します。

システムをトレーニングするために、現実世界から半自動的に透明な物体の画像のデータセットを収集し、手動で付けた3Dキーポイントを使ってそれらのポーズに効率的にラベルを付けました。

次に、深いモデル(KeyPoseと呼んでいます)をトレーニングして、深度を明示的に計算する事なしに、単眼画像(monocular image)またはステレオ画像(stereo image)から直接3Dキーポイントを推定します。

モデルは、個々の物体と物体が属するカテゴリの両方において、トレーニング中に出現した物体と出現しなかった物体の両方で機能します。

KeyPoseは単眼画像で機能しますが、ステレオ画像から利用できる追加情報(物体に応じて5mmから10mm程度の一般的な視差)単眼画像入力に対して2倍の性能が得られます。

これは、従来の最先端手法に学習用データとして本当の奥行情報ラベルが提供されていても、物体ポーズ推定で最先端のスコアを大幅に改善します。研究コミュニティに提供するために、キーポイントにラベル付けした透明な物体のデータセットをsites.google.comで公開しています。

3Dキーポイントラベル付きの現実世界の透明な物体データセット

実世界の大量の画像を簡単に収集できるように、ステレオデータカメラとKinect Azure深度カメラという2つのデバイスでビデオを撮影しながら、ロボットアームが軌道を移動するロボットデータ収集システムをセットアップしました。

ステレオカメラとAzure Kinectデバイスを備えたロボットアームを使用して自動的に画像を撮影

対象に付与したAprilTags(訳注:プリンターで印刷できる標識印で、設置している箇所をカメラで映すと正確な3D位置、方向の計算に利用できる)により、カメラのポーズを正確に追跡できます。二次元のキーポイントを使用して各ビデオの少数の画像のみに手動でラベル付けすることにより、マルチビュージオメトリを使用してビデオの全てのフレームの3Dキーポイントを付与できるため、ラベリング効率が100倍になります。

5つのカテゴリで15種類の透明な物体の画像を撮影し、各物体は10種類の背景画像と4種類のポーズを使用して、48,000のステレオ画像と深度画像で構成される合計600ビデオ動画を生成しました。

また、物体の不透明バージョンを使用して同じ画像を撮影し、正確な本当の深度画像を提供しました。全ての画像は三次元キーポイントでラベル付けされています。この実世界の画像のデータセットを公開し、同様な物体を共有する合成ClearGraspデータセットを補完します。

3.KeyPose:ステレオ画像で透明物体の三次元ポーズ推定を更に改良(1/2)関連リンク

1)ai.googleblog.com

KeyPose: Estimating the 3D Pose of Transparent Objects from Stereo

2)openaccess.thecvf.com

KeyPose: Multi-View 3D Labeling and Keypoint Estimation for Transparent Objects

3)sites.google.com

KeyPose: Multi-View 3D Labeling and Keypoint Estimation for Transparent Objects

3D Datasets for Transparent Objects

4)april.eecs.umich.edu

AprilTag

5)arxiv.org

DenseFusion: 6D Object Pose Estimation by Iterative Dense Fusion

6)bmvc2019.org

End-to-End 3D Hand Pose Estimation from Stereo Cameras(PDF)

コメント