1.KeyPose:ステレオ画像で透明物体の三次元ポーズ推定を更に改良(2/2)まとめ

・ステレオKeyPoseの重要な側面の1つはEarly fusionを使用してステレオ画像を融合する事

・Late fusionまたは単眼入力と比較すると、Early fusionステレオ入力の精度は通常2倍

・5msの推論速度で透明ボトルはMAE5.2mmマグカップ10.1mmの精度で予測可能

2.KeyPoseの性能

以下、ai.googleblog.comより「KeyPose: Estimating the 3D Pose of Transparent Objects from Stereo」の意訳です。元記事の投稿は2020年9月2日、Kurt Konoligeさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Markus Spiske on Unsplash

キーポイントの推定にステレオ画像を直接使用するというアイデアは、このプロジェクトのために独自開発しました。最近では、ハンドトラッキングの研究分野(End-to-End 3D Hand Pose Estimation from Stereo Cameras)でも使用されています。

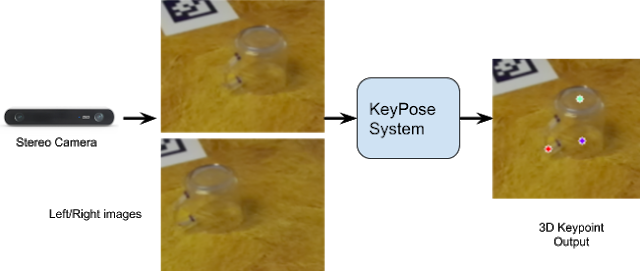

以下の図は、基本的な考え方を示しています。

Early fusionとLate fusionはbeforeディープラーニング時代から画像研究分野に存在する概念で、様々な特徴表現を学習してから融合するのか、様々な特徴表現を融合してから学習するかの違いです。KeyPoseはステレオ画像についてのお話なので、

Early fusion : ステレオ画像を融合してから特徴表現を学習

Late fusion : 個々のステレオ画像の特徴表現を学習してから融合

の理解で良いと思われます。

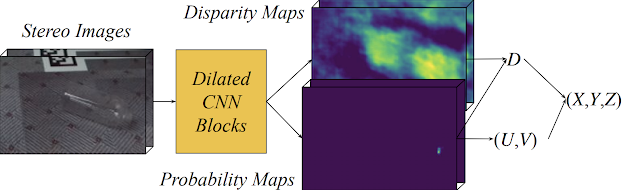

Keyposeシステム図

ステレオ画像はCNNモデルに渡され、各キーポイントの確率ヒートマップが作成されます。確率ヒートマップは、キーポイントの2D画像座標(U, V)を生成します。CNNモデルは、各キーポイントの視差(逆深度)ヒートマップも生成します。これを(U, V)座標と組み合わせると、3D位置(X, Y, Z)になります。

| Method | Dense Fusion | Dense Fusion | KeyPost | |||

| Input Modality | Monocular RGBD + opaque depth | Monocular RGBD + real depth | Stereo RGB | |||

| Metrics | <2cm | MAE | <2cm | MAE | <2cm | MAE |

| Bottles | 88.4 | 34.2 | 71.0 | 26.4 | 97.8 | 5.8 |

| Bottles + cups | 93.4 | 10.5 | 70.3 | 24.5 | 97.8 | 6.6 |

| Mugs | 72.8 | 17.6 | 41.5 | 26.5 | 92.6 | 9.9 |

カテゴリレベルのデータについて、KeyPoseと最先端のDenseFusionシステムの定量的な比較

DenseFusionには2つのバージョンの深度を提供します。1つは透明オブジェクトから、もう1つは不透明オブジェクトからです。 <2cmは、誤差が2cm未満の推定値のパーセントです。MAEは、キーポイントの平均絶対誤差(mm)です。

3.KeyPose:ステレオ画像で透明物体の三次元ポーズ推定を更に改良(2/2)関連リンク

1)ai.googleblog.com

KeyPose: Estimating the 3D Pose of Transparent Objects from Stereo

2)openaccess.thecvf.com

KeyPose: Multi-View 3D Labeling and Keypoint Estimation for Transparent Objects

3)sites.google.com

KeyPose: Multi-View 3D Labeling and Keypoint Estimation for Transparent Objects

3D Datasets for Transparent Objects

4)april.eecs.umich.edu

AprilTag

5)arxiv.org

DenseFusion: 6D Object Pose Estimation by Iterative Dense Fusion

6)bmvc2019.org

End-to-End 3D Hand Pose Estimation from Stereo Cameras(PDF)

コメント