1.Open Images V7:新たに疎らなラベルであるポイントラベルを採用(2/2)まとめ

・Open Images v7は注釈データを視覚化する仕組みも従来より充実している

・ポイントレベル注釈を含む全ての注釈を確認できるオールインワンビューを実装

・今後は優先度が低かった視覚的概念に対する注釈付け作業を行っていく予定

2.Open Images V7の可視化

以下、ai.googleblog.comより「Open Images V7 — Now Featuring Point Labels」の意訳です。元記事は2022年10月25日、Rodrigo Benensonさんによる投稿です。

アイキャッチ画像はstable diffusionの1.5版の生成

新しいビジュアライザー

新しいデータの公開に加え、Open Imagesの注釈を視覚化も充実させました。Open Imagesのウェブサイトには、物語化した注釈(localized narratives)、新しいポイントレベル注釈、そして新しいオールインワンビューを探索するための専用ビジュアライザーが追加されました。

この新しいオールインワンビューは、190万の密な注釈画像のサブセットで利用でき、Open Imagesが過去7回のリリースで蓄積した豊富な注釈を探索することができます。これらの画像には、平均して1枚あたり6.7個の画像レベルのラベル(クラス)、8.3個の境界ボックス、1.7個の関係、1.5個のマスク、0.4個の局所化されたナラティブ、34.8個のポイントラベルに対する注釈があります。

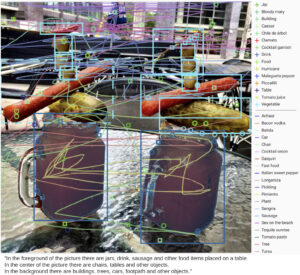

以下、オールインワンビジュアライザーで様々なアノテーションを施した2つの画像例を示します。図は、画像レベルのラベル、境界ボックス、ボックスの関係、インスタンスマスク、localized narrativesのマウストレースとキャプション、およびポイントレベルのラベルを示します。クラスはポジティブな注釈(あらゆる種類のもの)を持ち、-クラスはネガティブな注釈(画像レベルまたはポイントレベル)のみを持ちます。

オールインワンビジュアライザーで様々な注釈を加えた2つの画像例。

画像はJason ParisとRubén Viqueによるもので、すべてCC BY 2.0ライセンスに準拠しています。

まとめ

今回のデータ公開により、コンピュータビジョンの研究がより多様で困難なシナリオに対応できるようになることを期待しています。自動のセマンティックセグメンテーションモデルの品質が汎用的なクラスよりも向上するにつれて、私達は視覚的概念のロングテールに向かって進みたいと考えており、疎な点のアノテーションはその方向への一歩となります。

このような疎なアノテーションをどのように利用するか(例えば、インスタンスセグメンテーションやセマンティックセグメンテーションのスーパービジョンとして)検討する研究が増えており、Open Images V7はこの研究の方向性に貢献するものです。私たちは、あなたが次に何を作ってくれるのか、楽しみにしています。

謝辞

Vittorio Ferrari, Jordi Pont-Tuset, Alina Kuznetsova, Ashlesha Sadras, and the annotators team for support creating this new data releaseに感謝します。

3.Open Images V7:新たに疎らなラベルであるポイントラベルを採用(2/2)関連リンク

1)ai.googleblog.com

Open Images V7 — Now Featuring Point Labels

2)storage.googleapis.com

From colouring-in to pointillism:revisiting semantic segmentation supervision(PDF)

Open Images Dataset V7 and Extensions