1.Zari:事前トレーニング済みNLPモデル内の性別決めつけを緩和(2/2)まとめ

・モデルの品質を精度のみの観点でチェックするのは危険で性別相関もチェックが必要

・ハイパーパラメーターの変更は一見無害に見えても慎重に評価をする必要がある

・タスク固有の変更をせずともモデルを性別相関を改善できる可能性がある

2.性別相関をチェックする効率の良い手法

以下、ai.googleblog.comより「Measuring Gendered Correlations in Pre-trained NLP Models」の意訳です。元記事の投稿は2020年10月14日、Kellie Websterさんによる投稿です。

性別相関をチェックする効率のよい手法

事前トレーニングされたモデルが持つ特徴表現内の意図しない性別相関が、実際のタスクで推論に影響を与える可能性がある事を考えると、新しいNLPモデルを開発する際にこれがもたらすリスクを軽減するために何ができるでしょうか。

(1)意図しない相関を測定することが重要

モデルの品質は精度測定基準を使用して評価できますが、特にテストデータがトレーニングデータと同じ分布から取得されている場合、これらはパフォーマンスの1つの次元のみを測定しています。

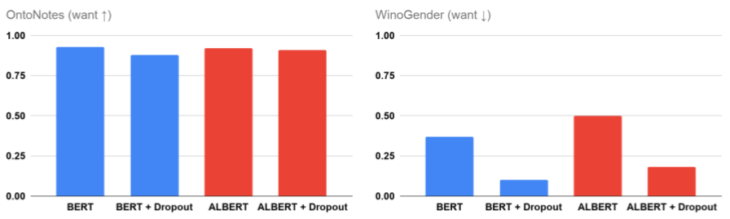

例えば、BERTチェックポイントとALBERTチェックポイントの精度は双方共に1%以内ですが、共参照の解決に性別相関を使用する程度は相対的に26%異なります。

この違いは、一部のタスクにとって重要な場合があります。WinoGenderスコアが低いモデルを選択した方が、男性看護師など、歴史的な社会規範に準拠していない可能性のある職業の人々に関するテキストに特化しているアプリケーションで望ましい場合があります。

(2)一見無害に見える構成変更を行う場合でも注意が必要

ニューラルネットワークモデルは、トレーニング時に特定の目的を最大化するように取捨選択される多くのハイパーパラメーターによって制御されます。

このハイパーパラメーターの設定選択は無害に見えることがよくありますが、性別の相関関係に、良い面と悪い面の両方で大きな変化を引き起こす可能性があることがわかりました。

例えば、ドロップアウト正則化は、大規模モデルによる過剰適合を減らすために使用されます。BERTとALBERTの事前トレーニングのドロップアウト率を上げると、微調整した後でも、性別の相関が大幅に減少することがわかります。

設定を変更するだけで性別相関リスクが少ないモデルをトレーニングできるため、これは有望ですが、モデルの設定を変更する場合は注意して慎重に評価する必要があることも示しています。

BERTおよびALBERTでのドロップアウト正則化の増加の影響

(3)汎用的に性別相関を緩和可能なタイミングが存在

性別の相関に対するドロップアウトの予期していなかった効果は、更に、意図しない相関を減らすための汎用的な手法に関する可能性の扉を開きます。

私達の調査ではドロップアウトを増やすことにより、タスクを手動設定したり、微調整段階を全く変更したりすることなく、WinoGenderの事例についてモデルが推論する方法を改善しました。

残念ながら、OntoNotesの精度は、ドロップアウト率が高くなるにつれて低下し始めます。(BERTの結果で確認できます)

しかし、事前トレーニングでこれを軽減できる可能性がある事に興奮しています。つまり、タスク固有の変更をせずともモデルを改善できる可能性があります。

論文では、様々なトレードオフを伴う別の緩和戦略として、反事実データの水増し(counterfactual data augmentation)について検討しています。

次に目指すもの

今回発表した効率のよい手法は、可能な限り幅広い言語とアプリケーションで適切に機能する堅牢なNLPシステムを開発するための出発点になると考えています。もちろん、これらの手法だけでは、全ての潜在的な問題を把握して取り除くのに十分ではありません。

現実世界の環境で展開されるモデルは、その使用方法を考慮した厳密なテストを受け、GoogleのAI原則などの倫理基準と整合性を確保するための安全装置を実装する必要があります。

私達は、評価フレームワークとデータの発展を楽しみにしています。これが、より広範で包括的なものになれば、言語モデルが活躍する場が増え、モデルを有効活用する人々の数も増えていくでしょう。

謝辞

これは、Xuezhi Wang, Ian Tenney, Ellie Pavlick, Alex Beutel, Jilin Chen, Emily Pitler, and Slav Petrovの共同研究です。

Fernando Pereira, Ed Chi, Dipanjan Das, Vera Axelrod, Jacob Eisenstein, Tulsee Doshi, and James Wexlerとの話し合いから、プロジェクト全体を通して大きな恩恵を受けました。

3.Zari:事前トレーニング済みNLPモデル内の性別決めつけを緩和(2/2)関連リンク

1)ai.googleblog.com

Measuring Gendered Correlations in Pre-trained NLP Models

2)arxiv.org

Measuring and Reducing Gendered Correlations in Pre-trained Models

3)www.aclweb.org

OntoNotes: The 90% Solution

4)catalog.ldc.upenn.edu

OntoNotes Release 5.0

5)openreview.net

What do you learn from context? Probing for sentence structure in contextualized word representations

6)github.com

rudinger / winogender-schemas