1.次世代のオンデバイス用ニューラルネットワークMobileNetV2まとめ

・Googleが昨年公開したMobileNetの改良版MobileNetV2を公開

・MobileNetはオンデバイスで通信機能がなくとも人工知能機能が利用可能

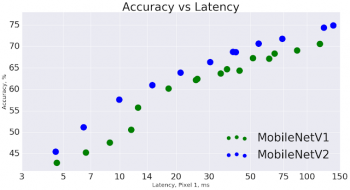

・MobileNetV2は速度だけ見ても30-40%程度の性能アップを実現

2.オンデバイス用ニューラルネットワークMobileNetV2とは?

「オンデバイス用」は「機器搭載用」とでも訳せば良いだろうか。昨今の人工知能機能はクラウドで実現されている事が多く、例えば 、スマホで写真を撮るとスマホは写真をクラウドに送信し、クラウド内で人工知能が画像解析などを実施している。

従来はネットワーク機能がないカメラなどではクラウドに接続できないので人工知能関連機能の実現は難しかったが、MobileNetはオンデバイスを目的としているのでカメラに直接搭載できる。昨年6月に、Googleはクラウドに接続せずとも画像解析、顔認識、物体認識、ランドマーク認識、ロゴや文章認識などを実現できるMobileNetをリリースした。これにより、どんな時でも、例えば圏外であってもスマホに搭載されたMobileNetを使って上記機能に加えて、セキュリティ、プライバシー、バッテリー使用量、など様々な機能を人工知能で最適化できるようになった。

本日、GoogleはMobileNetを大幅に強化したMobileNetV2を発表。強化された内容には最新の画像分類機能や物体認識、画素レベルの境界認識などが含まれる。MobileNetV2はTensorFlowのライブラリやJupyterなどの様々な形式で提供される。

MobileNetV2はMobileNetV1のアイディアである分割した畳み込み層を元に実現されたが、2つの改良を施している。1つは各層(レイヤー)間にボトルネックを設けた事、もう1つはボトルネック間をショートカットで接続した事である。ボトルネックにより下位レベル(画素)の認識を上位レベル(画像)の認識に変換させ、ショートカットにより、より速い学習と正確な認識を実現している。

また、MobileNetV2はMobileNetV1に比べて同じ認識精度をより早く実現できる。Google Pixelでのテストによれば、30%少ないパラメータで30~40%動作が早く、正確性も高かった。物体認識と境界認識ではMobileNetV1より35%早く同じ正確性を実現できた。DeepLabV3と組み合わせて実現した画素レベルの境界認識では、1/5のパラメーターと1/5の計算量で同等のパフォーマンスを実現できた。

MobileNetV2は、多くの画像認識機能をモバイル端末単独で非常に効率的に実現する。GoogleはMobileNetV2をより幅広く、学術界やオープンソースコミュニティと共有し、研究とアプリケーション開発を進める上で助けになる事を願っている。

3.次世代のオンデバイス用ニューラルネットワークMobileNetV2関連リンク

1)research.googleblog.com

MobileNetV2: The Next Generation of On-Device Computer Vision Networks

2)arxiv.org

MobileNetV2: Inverted Residuals and Linear Bottlenecks

コメント