1.強化学習でニューラルネットワークの最適化手法を発見する試みまとめ

・Googleが自動でニューラルネットワークの最適化手法を発見するNeural Optimizer Searchを発表

・成果物としてPowerSignとAddSignの2つの最適化手法が公開された

・Neural Optimizer Searchは人間が直観的に解釈可能な新たな恩恵をもたらしてくれるかもしれない

2.Neural Optimizer Searchとは?

ディープラーニングは検索や翻訳、写真など様々なGoogle製品に使われている。重要な事はディープラーニングの学習をどのように最適化させるか、つまり最適化手法である。例えば、確率的勾配降下法(SGD)は様々なケースで非常に有効な手法である。しかし、より先進的な最適化手法を使うとより早くより効率的に学習させる事が出来る。これは特に多数の隠れ層を持つ巨大なディープラーニングで重要になってくる。

しかし、新しい最適化手法は簡単には発見する事はできない。学習エラーをグラフ化してもグラフが必ずしも凸状にならない、つまり最も学習エラーを低くするパラメーターが簡単にわからない事が問題になるのだ。Google Brain Teamでは新しい最適化手法を自動で発見する事に挑戦している。これは、別プロジェクトであるAutoMLが新しいニューラルネットワーク構造を自動で発見するチャレンジである事に似ている。

Googleが発表した論文、「Neural Optimizer Search with Reinforcement Learning」では、ディープラーニングの最適化手法を見つける方法について論じている。この方法(Neural Optimizer Search)を使って我々は、PowerSignとAddSignの2つの最適化手法を発見した。これらは画像認識や翻訳などの様々な異なったタスクの異なったニューラルネットワークで有望な手法である。Googleはこの成果をTensorFlowで利用可能なライブラリとして公開した。

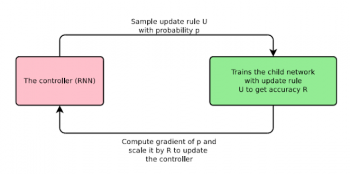

Neural Optimizer Searchは強化学習の仕組みを使って学習する。再帰型ニューラルネットワーク(RNN)のコントローラーが更新ルールを指示し、畳み込みニューラルネットワーク(CNN)がそれを用いた検証結果の正確性を戻す。これを繰り返す事で学習を進めていく。

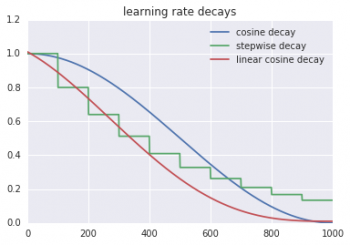

興味深い事は、Googleが見つけた最適化手法が人間が解釈可能な事だ。例えば、PowerSign法は勾配のsignとその移動平均を使ってステップサイズを調整する。2つの値によって勾配の方向が正しいか確信し、ステップサイズを調整していると直観的に理解できる。我々は、学習係数の最適化手法(learning rate decay scheme)も新しく発見した。linear cosine decayは従来手法より早く学習を収束させる事ができる。

Neural Optimizer Searchが見つけた最適化手法は、現在一般的に使われている最適化手法より良い性能を発揮する事が画像認識や翻訳で実際に確かめられている。Googleは、Neural Optimizer Searchが機械学習の学習効率を向上するだけでなく、人間が解釈可能な新しい数式や発見に導いてくれる事に興奮している。そしてまた、TensorFlowのライブラリとして公開された新しい最適化手法が機械学習の実務家にとって有用なものになる事も期待している。

3.強化学習でニューラルネットワークの最適化手法を発見する関連リンク

1)research.googleblog.com

Using Machine Learning to Discover Neural Network Optimizers

2)arxiv.org

Neural Optimizer Search with Reinforcement Learning

3)tensorflow.org

A module containing optimization routines.

コメント