1.BLEURT:人工知能が生成した文章の品質を評価(2/3)まとめ

・BLEURTは単語の重複度合に関わらず文章間の意味的類似性を捕捉できる新しい自動評価基準

・内部的にはBERTの「文脈を意識した単語表現(contextual word representations)」を使用している

・人間の評価データを介して回帰モデルを直接トレーニングすることはあまり上手くいかなかった

2.BLEURTの特徴

以下、ai.googleblog.comより「Evaluating Natural Language Generation with BLEURT」の意訳です。元記事の投稿は2020年5月26日、Thibault SellamさんとAnkur P. Parikhさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Hrvoje_Photography ?? on Unsplash。

BLEURTの紹介

BLEURTは、文章間の重要な意味的類似性を捕捉できる、新しい機械学習ベースの自動評価基準です。これは、様々な評価を集めた公開データ(the WMT Metrics Shared Task dataset)とユーザーが提供する追加の評価データを使ってトレーニングされます。

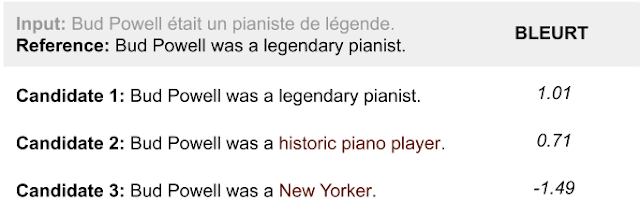

BLEURTによって評価された3つの文章

BLEURTは、候補2に候補3よりも参照文に含まれていない単語が多く含まれているにもかかわらず、候補2が参照文により意味的に類似していることを検出します。

機械学習を使った指標を開発することは、根本的な課題を提起します。指標は、幅広いタスクと領域で、時間の経過に関わらず一貫して適切に機能する必要があります。

ただし、トレーニングデータの量は限られています。実際、公開データは十分な量があるわけではありません。執筆時点で最大の人間による評価のコレクションであるWMT Metrics Task datasetには、ニュースに関する領域のみをカバーする約26万人による評価が含まれています。これだけでは、将来のNLGシステムの評価に適した基準をトレーニングするには制限が多すぎます。

この問題に対処するために、転移学習を採用しました。

最初に、BERTの「文脈を意識した単語表現(contextual word representations)」を使用します。BERTは、NLG評価基準(YiSiやBERTscoreなど)に既に上手く組み込まれている言語理解のための最先端の教師なし特徴表現学習法です。

次に、BLEURTの堅牢性を高めるための新しい事前トレーニング手法を紹介します。

私達が行った実験では、公に入手可能な人間の評価データを介して回帰モデルを直接トレーニングすることは脆弱なアプローチであることがわかりました。何故なら、評価基準が実際に適用される領域と期間は制御できないためです。

領域漂流(domain drift)になる場合、つまり、トレーニング時に使った文章のペアとは異なる領域で使われている文を評価する際は精度が低下する可能性があります。

品質漂流(quality drift)になる場合も精度が低下する可能性があります。品質漂流とは、予測時の品質評価がトレーニング中の品質評価よりも高くなる場合で、通常ならば、機械学習の研究が進歩した事を示しているため朗報となる事です。

3.BLEURT:人工知能が生成した文章の品質を評価(2/3)関連リンク

1)ai.googleblog.com

Evaluating Natural Language Generation with BLEURT

2)arxiv.org

BLEURT: Learning Robust Metrics for Text Generation

3)github.com

google-research/bleurt

4)www.statmt.org

ACL 2019 FOURTH CONFERENCE ON MACHINE TRANSLATION (WMT19)

コメント