1.動画用ニューラルネットワークを自動で探索する試み(3/3)まとめ

・従来モデルより大幅に早くビデオ認識が可能なTiny Video Networksも自動探索する事ができた

・アーキテクチャの自動進化中に実行時間を考慮し計算量を削減する事でこのパフォーマンスを向上

・人間が手動で設計した他の現代的モデルよりも数百倍速い速度を実現できた

2.計算量を削減した高速なTiny Video Networks

以下、ai.googleblog.comより「Video Architecture Search」の意訳です。元記事の投稿は2019年10月17日、Michael S. RyooさんとAJ Piergiovanniさんによる投稿です。

Tiny Video Networks:最速のビデオ理解ネットワーク

ビデオCNNモデルが、ロボットなど実世界の環境で動作するデバイスでも役立つようにするためには、リアルタイムで効率的な計算が可能になる事が必要です。

ただし、現在、ビデオ認識タスクで最新のスコアを達成するためには、大量の入力フレームを捌く事が出来る数十から数百の畳み込み層を備えた非常に大規模なネットワークが必要です。

その結果、これらのネットワークは非常に遅いランタイムに悩まされることが多く、最新のGPUでは1秒あたり少なくとも+500ms、CPUでは+2000msが必要となります。

Tiny Video Networksでは、わずかな計算コストで同等のパフォーマンスを提供するネットワークを自動的に設計することにより、この問題に対処します。

私達のTiny Video Networks(TinyVideoNets)は、競争力のある精度を実現し、リアルタイムまたはそれ以上の速度で、1秒のビデオクリップあたりCPUで37 – 100ミリ秒、GPUで10ミリ秒以内で効率的に実行できます。これは、人間が手動で設計した他の現代的モデルよりも数百倍速い速度を実現した事になります。

これらのパフォーマンスの向上は、アーキテクチャの進化中にモデルの実行時間を明示的に考慮し、アルゴリズムで検索空間を探索しながら、空間的または時間的な解像度とチャネルサイズを含めて計算を削減することで達成されています。

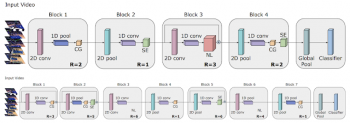

次の図は、TinyVideoNetが見つけた2つのシンプルにも関わらず非常に効果的なアーキテクチャを示しています。興味深いことに、学習したモデルアーキテクチャは、一般的なビデオアーキテクチャよりも畳み込み層が少ないのです。Tiny Video Networksは、2D pooling、gating layers、そしてsqueeze-and-excitation layersなどの軽量なパーツを好みます。更に、TinyVideoNetはパラメーターと実行時間を共同で最適化して、次回以降のネットワーク探索で使用できる効率的なネットワークを提供できます。

TinyVideoNet(TVN)アーキテクチャは、計算時間を希望の制限内に保ちながら認識パフォーマンスを最大化するために進化しました。例えば、TVN-1(上)はCPUで37ミリ秒、GPUで10ミリ秒で実行されます。TVN-2(下)は、CPUで65ミリ秒、GPUで13ミリ秒で実行されます。

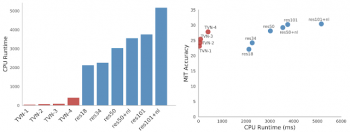

従来のモデルと比較したTinyVideoNetモデルのCPU実行時間(左)と、(2+1)D ResNetモデルと比較したTinyVideoNetsの実行時間-モデル精度(右)。TinyVideoNetsは、他のモデルが達成できない時間-精度領域を占有しており、つまり非常に高速でありつつ依然として正確であることに注目してください。

まとめ

私たちの知る限り、これはビデオ理解用のニューラルアーキテクチャを自動探索する最初の試みです。

新しい進化的アルゴリズムを使用して生成されたビデオ用アーキテクチャは、パブリックデータセットを使ったテストの結果、最もよく知られている手動で設計された従来のCNNアーキテクチャよりも大幅に優れています。また、アーキテクチャの進化により、計算効率の高いビデオモデルTinyVideoNetsを学習できることも示しています。この研究は、新しい方向性を切り開き、ビデオを理解するためのマシン進化型CNNの可能性を示しています。

謝辞

この研究はMichael S. Ryoo, AJ Piergiovanni, and Anelia Angelovaによって実施されました。

Alex ToshevとMingxing Tanもこの作業に貢献しました。議論とサポートについて、Vincent Vanhoucke、Juhana Kangaspunta、Esteban Real、Ping Yu、Sarah Sirajuddin、およびGoogleのRoboticsチームに感謝します。

3.動画用ニューラルネットワークを自動で探索する試み(2/3)関連リンク

1)ai.googleblog.com

Video Architecture Search

2)arxiv.org

Evolving Space-Time Neural Architectures for Videos

AssembleNet: Searching for Multi-Stream Neural Connectivity in Video Architectures

Tiny Video Networks

3)github.com

google-research/evanet

コメント