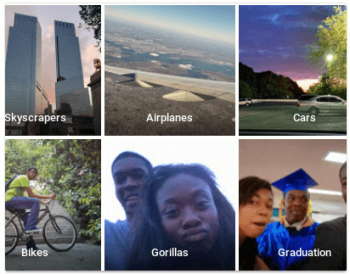

1.Google Photosが黒人をゴリラと誤認した件のまとめ

・Google Photosが黒人をゴリラと誤認した件は2年たっても修正できていないようだ

・人工知能は誤りを直接修正できないので本事例のような細かいチューニングは困難

・Googleは個別事例のチューニングよりプラットフォーム作りに注力していると思う

2.人工知能の誤認識の難しさ

改めてもう2年も前の話になるかと感慨深く感じてしまったけど、Googleの写真を分類してくれるサービスが黒人が写った写真をゴリラの写真に分類してしまった事件があった。2年たってどうなったか確かめてみたら、ゴリラがNGワード設定されていて技術的な解決が出来ていないとの事。

改めてご本人のツイッターを見ると、うーん、Jackyさんには申し訳ないが、これは写真の構図が独特で人工知能が誤認識しそうな要素が沢山あるな、と思ってしまう。

Googleの回答は「インターネットには黒人とゴリラを結びつける差別的な情報があふれており、それをマシンが機械学習してしまう、ということだと考えられます」だそうだ。つまり、「黒人の写真にゴリラと名前をつける人種差別主義者がいて人工知能がその写真を元に嘘を学んでしまった」って事だけど、それだったら、他の写真ももっと間違うはず。背景が一切なく、左下の洋服部分も暗くて一色で毛皮の光沢っぽく見えなくもないし、髪の毛が画面のかなり多くの部分を占めていて、左上のJackyさんの顔の陰影が過度に強調されているから、これ、素で間違ったんだと思う。現在の物体認識はまだまだ発展途上で人間には考えられないような誤認識をするケースもある。

とはいえ、この誤認識を修正できるかと言うと、上記のような勘違いの原因っぽいポイントは洗い出せても、人工知能がどうやってそこを学習したのか具体的な箇所はわからない。だから、直接誤りを修正する事はできない。このJackyさんを誤認識しないような個別のチューニングをする事は可能かもしれないけど、その対応をしても他で同じような誤認識をしてしまうだろうからあまり意味がない。そのため、NGワードとする事で対応したのだと思う。

Google製品を見ていて思うのは個別事例のチューニングより「システムを作るためのシステム」、つまりプラットフォーム作りに注力してるのを感じる。だから個別事例が少しずつ改良されるのではなく、ある日突然、Jackyさんを誤認識しなくなると同時にその他の誤認識も全てなくなると言った対応になるのだと思う。

また、「人工知能の公平性と倫理」は改めて色々な所で話題になり、その結果、製品や研究紹介の際に同時に公平性と論理への取り組みに言及する事が増えてきている。