1.OptFormer:パラメータ名など言語情報を参考にハイパーパラメータを最適化(1/2)まとめ

・OptFormerは様々な最適化アルゴリズムを正確に模倣できるようになった

・OptFormerは最適化目標値の予測とその不確実性の推定ができるようになった

・Google Vizierのベイズ最適化アルゴリズムを上回る拡張ポリシーを生成した

2.OptFormerの性能

以下、ai.googleblog.comより「OptFormer:Towards Universal Hyperparameter Optimization with Transformers」の意訳です。元記事は2022年8月18日、Yutian ChenさんとXingyou (Richard) Songさんによる投稿です。

アイキャッチ画像はDALL·E2での自動生成

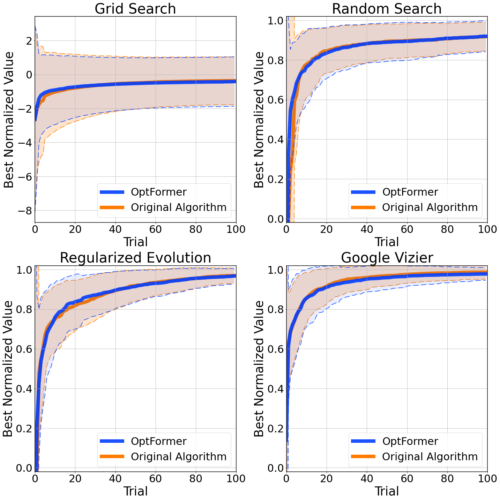

ポリシーの模倣

OptFormerは様々なアルゴリズムによる最適化の軌跡を学習するため、同時にそれらのアルゴリズムを正確に模倣することができるようになりました。指定されたアルゴリズムのメタデータにテキストベースのプロンプト(例:「Regularized Evolution」)を提供することで、OptFormerはそのアルゴリズムの動作を模倣します。

未知のテスト関数に対して、OptFormerはオリジナルのアルゴリズムとほぼ同じ最適化曲線を生成します。平均値と標準偏差のエラーバーが表示されています。

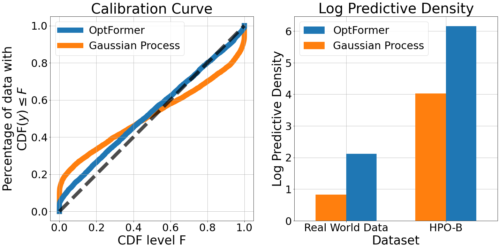

目的値の予測

さらに、OptFormerは最適化される目的値(例えば精度)を予測し、不確実性の推定値を提供することができるようになりました。

OptFormerの予測と標準的なガウス過程を比較したところ、OptFormerは格段に精度の高い予測が可能であることが分かりました。これは、OptFormerの検定曲線(calibration curve)が適合度テストにおいて理想的な対角線に密接に従うという定性的にも、対数予測密度などの標準的な集計指標による定量的にも、以下のように見ることができます。

左:Rosenblattの適合度。斜めに近い方がフィットしています。

右:対数予測密度。高いほど良いです。

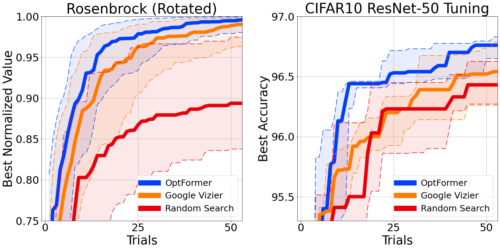

両者の組み合わせ:モデルベースの最適化

ベイズ最適化と同様に、OptFormerの関数予測機能を用いて、模倣されたポリシーをより良く導くことができます。トンプソンサンプリング(Thompson Sampling)を使って、模倣されたポリシーの提案に順位をつけ,関数予測器に従って最もよいものだけを選択することができます。

これにより、古典的な合成ベンチマーク目標を最適化できます。標準的なCIFAR-10トレーニングパイプラインのハイパーパラメータ(学習率)調整の際に、Google Vizierの業界グレードのベイズ最適化アルゴリズムを上回ることができる拡張ポリシーが生成されます。

左:古典的なRosenbrock関数に対する現時点での最適化曲線

右:CIFAR-10上のResNet-50をinit2winitで学習させるためのハイパーパラメータに対する現時点での最適化曲線。両ケースとも、曲線ごとに10のシードを使用し、エラーバーは25%および75%で表示しています。

まとめ

この研究を通して、我々はTransformerの有用かつこれまで知られていなかった最適化能力を発見しました。将来的には、複雑な探索空間での最適化を促進するために数値データとテキストデータの両方を使用する普遍的なハイパーパラメータとブラックボックス最適化インターフェースへの道を開き、GoogleのオフラインAutoMLデータの膨大なコレクションを活用することによってOptFormerをTransformerエコシステムの残りの部分(例えば、言語、ビジョン、コード)と統合したいと考えています。

謝辞

DeepMindとGoogle Research Brain Teamの以下のメンバーがこの研究を実施しました。Yutian Chen, Xingyou Song, Chansoo Lee, Zi Wang, Qiuyi Zhang, David Dohan, Kazuya Kawakami, Greg Kochanski, Arnaud Doucet, Marc’aurelio Ranzato, Sagi Perel, 及び Nando de Freitas.

また、Chris Dyer, Luke Metz, Kevin Murphy, Yannis Assael, Frank Hutter, そしてEsteban Realには貴重なフィードバックをいただき、さらに Sebastian Pineda Arango, Christof Angermueller, 及び Zachary Nadoとのベンチマークに関する技術的議論に感謝の意を表したいです。さらに、Daniel Golovin, Daiyi Peng, Yingjie Miao, Jack Parker-Holder, Jie Tan, Lucio Dery, 及び Aleksandra Faust には、有益な会話を何度も交わしたことに感謝します。

最後に、この記事のためにアニメーションをデザインしてくれたTom Smallに感謝します。

3.OptFormer:パラメータ名など言語情報を参考にハイパーパラメータを最適化(2/2)関連リンク

1)ai.googleblog.com

OptFormer: Towards Universal Hyperparameter Optimization with Transformers

2)arxiv.org

Towards Learning Universal Hyperparameter Optimizers with Transformers