1.AlphaStar:StarCraftIIでプロプレーヤーに勝った人工知能(3/3)まとめ

・AlphaStarはコンピュータ特有の優位性の利用は極力控えていた

・操作量は人間のプロプレーヤー同等、操作遅延も同等であった

・ミニマップを切り替える必要がないという特性が修正しきれていなかった

2.AlphaStarとプロプレーヤーの違い

以下、deepmind.comより「AlphaStar: Mastering the Real-Time Strategy Game StarCraft II」の意訳です。元記事の投稿は2019年1月24日、The AlphaStar teamの皆さんによる執筆です。大変すいません、「Deepmindの人工知能AlphaStarがStarCraft2でプロゲーマーに打ち勝つ」ですが誤情報でした。マップ上の全てが見えていたのではなく、「ミニマップ上に映っているものはメインスクリーンを切り替えなくてもすべての情報を取得可能」であったようです。前記事はこちら。続きはこちら。

AlphaStarのゲームプレイと画面観察の方法

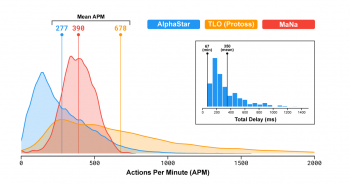

TLO選手やMaN選手などのプロのStarCraftプレーヤーは、平均して1分あたり何百もの命令を実行しており、これはAPM(Actions Per Minute)と言う単位で計測されます。プロのStarCraftプレーヤーのAPMは一般的なプレーヤーのAPMより多いのですが、それでも、従来の人工知能ボットが、何千または何万ものAPMで各ユニットを制御している事を考えるとはるかに少ない値です。

TLO選手とMaNa選手との対戦では、AlphaStarの平均APMは約280でした。プロのプレーヤーの平均よりもかなり低くなっていますが、そのアクションはより正確かもしれません。この低いAPMは、AlphaStarが当初の学習を人間のリプレイを使用して実施したためです。つまり、人間がゲームをプレイする方法を模倣しているのです。 さらに、AlphaStarは画面を確認してから平均350ms遅れてアクションをします。

左:MaNa選手とTLO選手との試合におけるAlphaStarのAPMの分布。

右:AlphaStarの画面確認からアクションに繋がるまでの遅延の分布

(情報明確化のための追記)TLO選手のAPMがAlphaStarやMaNa選手よりも高いように見えるのは、彼がラピッドファイヤーホットキーを使用し「コントロールグループから特定のユニットを削除する操作」や「コントロールグループに特定のユニットを追加する操作」(いずれもゲーム中に良く使われる操作)にキーバインディングを割り当ているからです。また、AlphaStarは平均では両playerよりAPMは低いのですが、効果的にAPMを増減させ、時々両方のプレーヤーより高くなっている事にも注意してください。

訳注:APMはプレイ上あまり意味のない操作を繰り返しても上げる事ができるのですが、操作量の多さを示すある種のステータスと見なすプレーヤーがいたり、ウォーミングアップの手慣らしとしてボタンを連打する(つまり無駄にAPMが上がる)人もいるので人間のAPMには相当な無駄が含まれています。

TLO選手とMaNa選手との対戦中、AlphaStarはRawインタフェースを介して直接StarCraftゲームエンジンと対話しました。つまり、カメラを動かさなくても、ミニマップ上に表示されている自分のユニットや相手ユニットの属性を直接観察できました。対照的に、人間のプレーヤーはメイン画面に映す出して注意を集中する場所を決定するために「注意の経済(つまり何に注意を集中して何を切り捨てるか)」を明示的に管理しなければなりません。ただし、AlphaStarのゲームを分析したところ、暗黙のうちに注目が集まっていることが示唆されました。平均すると、エージェントは、MaNa選手やTLO選手と同様に、1分あたり約30回注目する画面を切り替えました。

訳注:ミニマップは左下にマップ全体が表示されている画面なのですが、人間のプレーヤーはミニマップ上では敵の有無だけしかわからず、実際にどんなユニットがいて何が行われているかを知るためにはメイン画面をその場面に移動させなければなりません。(つまり、その分、操作が複雑になり行動に遅延が発生します)。AlphaStarはRawインタフェースを介していたために、カメラを切り替えずともミニマップ上行われている事も全て把握できていたので人間より有利であったと言う事です。

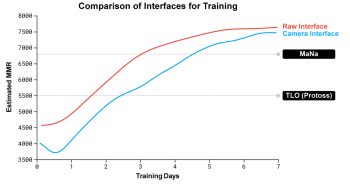

さらに、試合後に私達はAlphaStarの第二版(カメラインタフェース版)を開発しました。人間のプレーヤーのように、このバージョンのAlphaStarはいつどこにカメラを動かすかを選択し、その状況認識は画面上の情報に制限され、そして行動指示もその可視領域に制限されます。

Rawインターフェース版(赤線)とカメラインターフェース版(青線)のAlphaStarのパフォーマンス比較。新しくトレーニングされたカメラインターフェース版エージェントがRawインターフェース版エージェントのパフォーマンスに急速に追いついてほぼ同等になった事を示しています。

私たちは2つの新しいエージェントをAlphaStarリーグで訓練しました。1つはRawインタフェースを使用し、もう1つはカメラの制御を学ぶ必要がありました。

各エージェントは最初に人間のリプレイデータから教師有学習を行い、それに続いて前述の強化学習手順によって訓練されました。カメラインターフェースを使用するAlphaStarのバージョンは、Rawインターフェースとほぼ同じくらい強力で、社内のリーダーボードでは7000 MMRを超えていました。

エキジビジョンマッチでは、MaNa選手はプロトタイプのカメラインターフェース版AlphaStarを打ち破りました。しかし、カメラインターフェース版エージェントはたった7日間しか訓練されていませんでした。近い将来、完全に訓練されたカメラインターフェース版のエージェントを評価できればな、と考えています。

これらの結果を総合すると、MaNa選手とTLO選手に対するAlphaStarの成功は、多くのクリック操作、より速い反応時間、あるいはRawインターフェースによる知覚的優位性を起因とするものではなく、より優れたマクロ戦略とミクロ操作を意思決定した結果によるものであることを示唆しています。

(AlphaStar:StarCraftIIでプロプレーヤーに勝った人工知能(2/3)からの続きです)

AlphaStar:StarCraftIIでプロプレーヤーに勝った人工知能(4/3)に続きます)

3.AlphaStar:StarCraftIIでプロプレーヤーに勝った人工知能(3/3)まとめ

1)deepmind.com

AlphaStar: Mastering the Real-Time Strategy Game StarCraft II

コメント