1.DeepFusion:センサー情報とカメラ情報を効果的に融合して3次元物体検出(1/2)まとめ

・LiDARと視覚カメラは、自律走行車やロボットに使用される2種類のセンサー

・最先端の3次元物体検出器の多くはカメラを有効活用できていなかった

・DeepFusionはカメラとLiDARを効果的に融合させて品質を向上する手法

2.DeepFusionとは?

以下、ai.googleblog.comより「Lidar-Camera Deep Fusion for Multi-Modal 3D Detection」の意訳です。元記事は2022年4月12日、Yingwei LiさんとAdams Wei Yuさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Alexandre Debiève on Unsplash

LiDARと視覚カメラは、自律走行車やロボットの3D物体検出に使用される2種類の補完的なセンサーです。

LiDARはパルスレーザーの光を利用して距離を測定するリモートセンシング技術で、低解像度の形状と奥行き情報を提供します。カメラは高解像度の形状とテクスチャ情報を提供します。

LiDARとカメラが捉えた特徴を統合して最適な3次元物体検出を行うべきですが、最先端の3次元物体検出器の多くはLiDARのみを入力としていることが判明しました。その主な理由は、堅牢な三次元物体検出モデルを開発するために、ほとんどの手法が両方の入力からのデータを補強・変換する必要があり、特徴の正確な位置合わせが困難であるためです。

PointPainting、PointAugmenting、EPNet、4D-Net、ContinuousFusionなど、LiDARとカメラの出力を融合する既存のアルゴリズムは、一般的に2つのアプローチに従っています。

入力レベルの融合:LiDARの点群を対応するカメラの特徴で装飾し、早い段階で特徴を融合します。

中間レベルの融合:両方のセンサーから特徴を抽出し、それを合成します。

これらの手法は、効果的に位置を合わせる事の重要性を認識していますが、融合前に特徴を拡張・集約する一般的なシナリオで効率的に処理する事ができずに苦心しています。

このことは、両方のセンサーからの信号を効果的に融合させることは簡単ではなく、依然として困難である可能性を示しています。

CVPR 2022の論文「DeepFusion: LiDAR-Camera Deep Fusion for Multi-Modal 3D Object Detection」では、2つのセンシングモダリティからの信号を統合するために、シンプルかつ効果的な深層特徴融合戦略を適用する、DeepFusionと呼ばれる完全にエンドツーエンドのマルチモーダル3D検出フレームワークを紹介します。

LiDARの点群を手動設計したカメラの特徴表現で装飾する従来のアプローチとは異なり、本手法はエンドツーエンドのフレームワークでディープなカメラ特徴とディープなLiDAR特徴を融合させるものです。まず、特徴量の位置合わせ品質を向上させる2つの新しい技術、InverseAugとLearnableAlignを説明し、DeepFusionの開発に適用します。次に、自動車用3Dオブジェクト検出の最大データセットの1つであるWaymo Open Datasetで、DeepFusionによる最先端の性能を実証します。

InverseAug: 立体的なデータを水増しする際に正確に位置合わせ

自律走行車のための既存の3D物体検出ベンチマークで良好なパフォーマンスを達成するために、ほとんどの手法は過剰適合を避けるためにトレーニング中に強力なデータ補強を必要とします。

しかし、DeepFusionパイプラインでは、データ補強の必要性が些細ではない課題となっています。具体的には、2つのモダリティからのデータは異なる増強戦略を使用するためです。

例えば、3D点群はz軸に沿って回転させるデータ増強が行われますが、2Dカメラ画像ではランダム切り抜きを組み合わせるため、しばしば位置合わせが不正確になるのです。

次に、拡張されたLiDARデータは、三次元画素(voxels)化ステップを経て、点群から3次元画素配列に格納された立体データへと変換されます。3次元画素化されたデータは、生データとは全く異なる特徴を持つため、位置合わせがさらに困難になります。

立体に関連するデータ増強時の位置合わせ問題に対処するため、モデルの学習段階において、融合前に拡張を逆転させる技術である逆拡張(InverseAug)を紹介します。

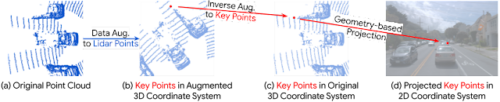

以下の例では、データ増強されたLiDARデータとカメラデータの位置合わせが困難であることを実証しています。この場合、LiDARデータポイントのような任意の3D座標である与えられた3Dキーポイントが、元のLiDARとカメラのパラメータを使用するだけでは2D空間で簡単に位置合わせができない結果となり、LiDAR点群が回転によって増強されます。そこで、InverseAugはまず、形状に関連するデータ増強を行う前に、増強パラメータを保存します。融合ステージでは、すべてのデータ増強を逆にして3Dキーポイントの元の座標を取得し、カメラ空間での対応する2D座標を求めます。

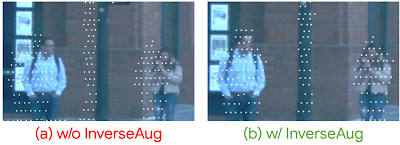

学習中、InverseAugは立体的データ増強よる不正確な位置合わせを解決します

左:InverseAugを使用しない場合の位置合わせ

右:InverseAugを使用した場合の位置合わせ

InverseAugによって位置合わせ品質が向上します

3.DeepFusion:センサー情報とカメラ情報を効果的に融合して3次元物体検出(1/2)関連リンク

1)ai.googleblog.com

Lidar-Camera Deep Fusion for Multi-Modal 3D Detection

2)arxiv.org

DeepFusion: Lidar-Camera Deep Fusion for Multi-Modal 3D Object Detection