1.差分プライバシーを使って大規模な画像分類モデルを学習(1/2)まとめ

・差分プライバシーのプライバシーと実用性の両立は様々な工夫が必要となる

・フルバッチトレーニングと公開データを使った転移学習を組み合わせた

・DP-SGDはJAXで高速化されているため試行錯誤が比較的容易で継続研究が可能

2.差分プライバシーの性能を向上させる工夫

以下、ai.googleblog.comより「Applying Differential Privacy to Large Scale Image Classification」の意訳です。元記事は2022年2月1日、Alexey KurakinさんとRoxana Geambasuさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Nick Decorte on Unsplash

精度を向上させる技術の組み合わせ

将来の学習アルゴリズムにより、差分プライバシー(DP:Differential Privacy)のプライバシーと実用性のトレードオフが改善される可能性があります。しかし、DP-SGDのような現在のアルゴリズムでは、私たちの経験から、DPをImageNetのような難しいタスクでより実用的にするための工学的な「あらゆる手段(bag-of-tricks)」が必要になる事がわかります。

JAXを用いることで、より高速にモデルを学習することができるため、DPに適した設定を迅速に繰り返し、複数の構成を検討することができます。我々は、ImageNetにおいて精度とプライバシーを達成するために有用な技術として、以下の組み合わせを報告します。

・フルバッチトレーニング

理論的には、ミニバッチサイズを大きくするとDP-SGDの実用性が向上し、フルバッチトレーニング(すなわち、全データセットを1つのバッチとする)が最も実用性が高いことが知られており、この理論を支持する実証結果が出ています。

実際、私たちの実験でも、訓練エポック数とともにバッチサイズを大きくすることで、精度を維持したままεを減少させることが実証されています。

しかし、非常に大きなバッチを用いた学習は、バッチがGPU/TPUのメモリに収まらないため、簡単な事ではありません。そこで、学習ステップごとに勾配更新をかけるのではなく、複数ステップの勾配を蓄積してから重みを更新する仮想ラージバッチトレーニングを採用しました。

| Batch size | 1024 | 4 × 1024 | 16 × 1024 | 64 × 1024 |

| Number of epochs | 10 | 40 | 160 | 640 |

| Accuracy | 56% | 58% | 58% | 57% |

| Privacy loss bound ε | 9.8 × 108 | 6.1 × 107 | 3.5 × 106 | 6.7 × 104 |

・公開データを使った転移学習

公開データで事前学習を行った後、非公開データでDPの微調整を行うと、他のベンチマークで精度が向上することが以前から示されています。しかし、与えられたタスクに対して、どのような公開データを用いれば、転移学習が最適化されるかという問題が残されています。

本研究では,ImageNetを「プライベート」データとして用い、Places365という別の画像分類データセットを「公開(public)」データと見なして、プライベートデータと公開データが分離されている状態をシミュレートします。

私たちは、ImageNet上でDP-SGDを用いてモデルの微調整を行う前に、Places365上でモデルの事前学習を行いました。Places365はImageNetのような動物の画像ではなく、風景や建物の画像のみであり、全く異なるため、異なるが関連する領域へのモデルの転移能力を実証するための良い候補となります。

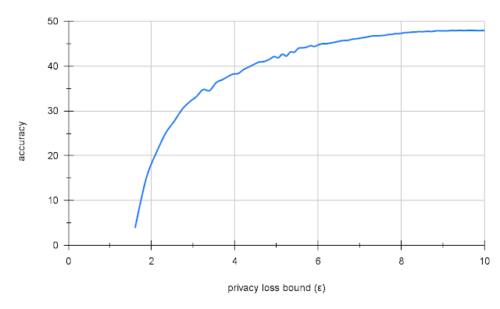

Places365からの転移学習により、妥当なプライバシーレベル(ε = 10)のImageNetで47.5%の精度が得られることがわかりました。これは、同様の非プライバシーモデルの70%の精度と比べると低いですが、非常に低い精度(2-5%)またはプライバシーがない(ε=109)ImageNetのナイーブDP学習と比べると、非常に良い結果です。

Places365からの転移学習により、妥当なプライバシーレベル(ε = 10)のImageNetで47.5%の精度が得られることがわかりました。これは、同様の非プライバシーモデルの70%の精度と比べると低いですが、ImageNetを使った単純なDP学習、例えば非常に低い精度(2-5%)またはプライバシーが保たれていない(ε=109)DP学習と比べると、非常に良い結果です。

Resnet-18でImageNet+転移学習+ラージバッチ構成におけるプライバシーと精度のトレードオフ

次のステップ

私たち、これらの初期の結果とソースコードが、他の研究者がDPの改良に取り組むきっかけとなり、ImageNetのような野心的なタスクが、困難な製品規模タスクの代理となることを期待しています。DP-SGDはJAXで高速化されたので、DPやMLの研究者が、DPをより実用的にするために、様々な学習方法、モデルアーキテクチャ、アルゴリズムを探求することを強く望みます。この分野の発展を続けるために、研究者は、フルバッチ学習と転移学習を取り入れたベースラインから始めることをお勧めします。

謝辞

本研究は、Google Visiting Researcher Programの支援により実施されました。

Geambasuがコロンビア大学准教授時代にGoogle Researchで特別研究期間(sabbatical)をとっている間に実施しました。この研究は、Steve Chien、Shuang Song、Andreas Terzis、Abhradeep Guha Thakurtaから多大な貢献を受けています。

3.差分プライバシーを使って大規模な画像分類モデルを学習(2/2)関連リンク

1)ai.googleblog.com

Applying Differential Privacy to Large Scale Image Classification

2)arxiv.org

Toward Training at ImageNet Scale with Differential Privacy

3)github.com

google-research / dp-imagenet