1.MICLe:自己教師あり学習で医療用画像の分類精度を向上(3/3)まとめ

・自己教師事前トレーニングは分布がシフトするデータセットに堅牢であった

・自己教師事前トレーニングはラベル効率が高く少ないラベルで性能向上可能

・自己教師事前トレーニングはラベルが不要なため規模拡大が容易で有望

2.分布シフトに対する堅牢性

以下、ai.googleblog.comより「Self-Supervised Learning Advances Medical Image Classification」の意訳です。元記事は2021年10月13日、Shekoofeh Aziziさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Marian Oleksyn on Unsplash

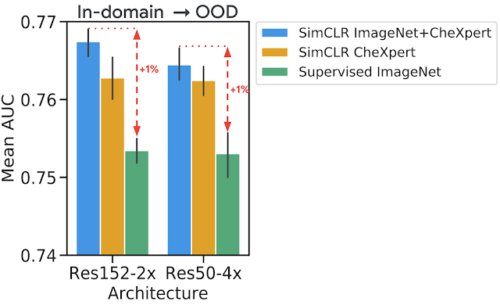

自己教師事前トレーニング(ImageNetとCheXpertデータの両方を使用)を使用した際に分布シフトデータセット(ChestX-ray14)で見られたパフォーマンスの改善は、CheXpertデータセットのみを使った際の改善よりも顕著であることがわかりました。

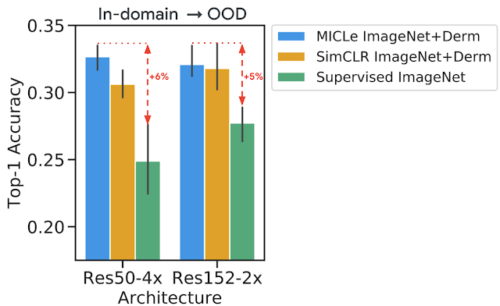

分布シフト下での一般化は臨床応用にとって最も重要であるため、これは貴重な発見です。皮膚分類タスクでは、皮膚がん診療所で収集された、悪性状態の有病率が高かった別のシフトしたデータセットについて同様の傾向が観察されました。これは、分布シフトに対する自己教師あり特徴表現の堅牢性がタスク間で一貫していることを示しています。

分布シフトデータセットで胸部X線解釈タスク行った際のモデルの性能評価

ドメイン内データでトレーニングされたモデルを使用して、さらに微調整することなく、追加のシフトされたデータセットで予測を行います(ゼロショット転移学習)。自己教師事前トレーニングは、分布シフトに対してより堅牢なより良い特徴表現につながることが観察されました。

皮膚分類タスクのための分布シフトデータセットを使ったモデルの評価

私たちの実験結果は、一般的に、自己教師の事前トレーニングされたモデルが、MICLeの事前トレーニングによって分布シフトに一般化され、最大の利益が得られることを示唆しています。

ラベル効率の向上

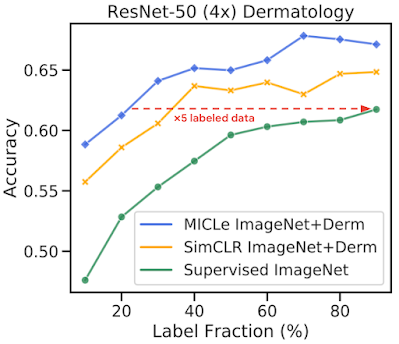

さらに、ラベル付けされたトレーニングデータを部分的に使用してモデルを微調整することにより、医用画像分類のための自己教師モデルのラベル効率を調査しました。

DermとCheXpertの両方のトレーニングデータセットの10%~90%の範囲で使用するラベルの割合を変化させ、皮膚分類タスクでパフォーマンスがどのように変化するかを調べました。

まず、自己教師モデルを使用した事前トレーニングにより、医用画像分類のラベル効率の低さを補うことができます。使用するラベルの割合を変えても、自己教師モデルは常に教師ありモデルを上回っています。

これらの結果は、ラベル付けされたサンプルの数を減らして微調整すると、MICLeが比較して高い性能向上をもたらすことも示唆しています。実際、MICLeは、ResNet-50(4x)のトレーニングデータの20%とResNet152(2x)のトレーニングデータの30%のみを使用して、教師ありモデルと匹敵する性能を出す事ができます。

MICLe、SimCLR、および教師ありモデルの比較

さまざまなラベルなしの事前トレーニングデータセットと様々な割合のラベル付きデータを使用して皮膚状態分類のtop-1精度を比較。MICLeは、ResNet-50(4x)のトレーニングデータのわずか20%のみを使用して教師ありモデルに匹敵するスコアを出す事ができます。

結論

自然画像データセットの教師あり事前トレーニングは、医用画像の分類を改善するために一般的に使用されています。ラベルのない自然画像と医用画像の自己教師事前トレーニングに基づく代替戦略を調査し、医療画像診断モデルをトレーニングするための標準的手法である教師あり事前トレーニングを大幅に改善できることを発見しました。

このアプローチは、より正確でラベル効率が高く、データ分布の変化に対して堅牢性の高いモデルにつながる可能性があります。さらに、提案されたマルチインスタンス対照学習法(MICLe:Multi-Instance Contrastive Learning)を使用すると、追加のメタデータを使用して現実に沿ったデータ増強を行い、画像分類器のパフォーマンスをさらに向上させることができます。

自己教師型事前トレーニングは、クラスラベルの注釈が不要なため、教師有り事前トレーニングよりもはるかに規模拡大が容易です。この論文が、医療画像分析における自己教師アプローチの使用を普及させ、実世界での大規模な臨床展開に適したラベル効率の高い堅牢なモデルを生み出すのに役立つことを願っています。

謝辞

本研究には、Google HealthとGoogle Brain全体の研究者、ソフトウェアエンジニア、臨床医、部門の枠を超えた貢献者からなる学際的なチームによる共同研究が含まれていました。

共著者のasil Mustafa, Fiona Ryan, Zach Beaver, Jan Freyberg, Jon Deaton, Aaron Loh, Alan Karthikesalingam, Simon Kornblith, Ting Chen, Vivek Natarajan, Mohammad Norouziに感謝します。

また、貴重なフィードバックを提供してくれたGoogle HealthのYuan Liuと、研究で使用したデータセットにアクセスするため協力してくれたパートナーにも感謝します。

3.MICLe:自己教師あり学習で医療用画像の分類精度を向上(3/3)関連リンク

1)ai.googleblog.com

Self-Supervised Learning Advances Medical Image Classification

2)arxiv.org

Big Self-Supervised Models Advance Medical Image Classification