1.AI Choreographer:音楽に合わせたダンスを生成する人工知能(2/2)まとめ

・FACTはMotion、Audio、Cross-Modalの3種のTransformerから構成される

・full-attention mask利用とN個先の予測、Cross-Modalなどの工夫をしている

・FACTは従来の最先端モデルよりは定性的評価が高いがまだ専門家には及ばない

2.FACTモデル

以下、ai.googleblog.comより「Music Conditioned 3D Dance Generation with AIST++」の意訳です。元記事は2021年9月13日、Shan YangさんとAngjoo Kanazawaさんによる投稿です。

アイキャッチ画像のクレジットはPhoto by Jeremy Bishop on Unsplash

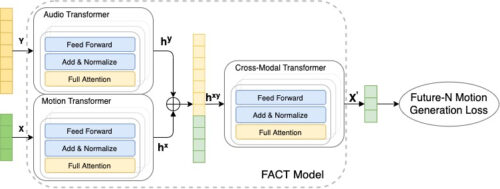

Full Attention Cross-Modal Transformer(FACT)モデル

このデータを使用して、音楽から3Dダンスを生成するようにFACTモデルをトレーニングします。 モデルは、個々のMotion TransformersとAudio Transformersを使用してシードモーション(seed motion)とオーディオ入力をエンコードすることから開始します。

次に、embeddingsは連結されてCross-Modal Transformerに送信されます。Cross-Modal Transformerは、両方のモダリティ間の対応を学習し、N個の将来のモーションシーケンスを生成します。

次に、これらのシーケンスを使用して、自己教師方式でモデルをトレーニングします。3つのTransformerはすべて、エンドツーエンドで共同で学習されます。テスト時に、このモデルを自己回帰フレームワークに適用します。このフレームワークでは、予測された動きが次世代ステップへの入力として機能します。その結果、FACTモデルはフレームごとに長距離のダンスモーションを生成することができます。

FACTネットワークは、楽曲(Y)とシードモーションの2秒シーケンス(X)を取り込み、入力された音楽と相関する長期にわたる将来のモーションを生成します。

FACTには、音楽からリアルな3Dダンスモーションを生成するために重要な3つの重要な設計上の選択が含まれます。

(1)すべてのTransformersはfull-attention maskを使用します。内部トークンがすべての入力にアクセスできるため、通常の因果モデル(Causal model)よりも表現力があります。

(2)次の動きだけでなく、現在の入力を超えたN個先を予測するようにモデルをトレーニングします。これにより、ネットワークは時間的コンテキストにより多くの注意を払うようになり、数回の生成ステップ後にモデルがモーションフリーズまたは発散してしまうのを防ぐことができます。

(3)2つのembeddings(モーションとオーディオ)を早期に融合し、入力音楽に実際にattentionを払うモデルのトレーニングに不可欠な、深い12層のcross-modal transformer モジュールを採用しています。

結果

次の3つの指標に基づいてパフォーマンスを評価します。

(1)モーションの品質

AIST++テストセットの実際のダンスモーションシーケンスと、それぞれ1200フレーム(20秒)のモデルが生成したモーションシーケンス40との間のフレシェ開始距離(FID:Frechet Inception Distance)を計算します。幾何学的および速度論的特徴に基づいて、FIDをそれぞれFIDgおよびFIDkと表記します。

(2)生成されるダンスの多様性

以前の研究と同様に、多様なダンスモーションを生成するモデルの能力を評価しました。AIST++テストセットで生成された40のモーションにわたる特徴空間の平均ユークリッド距離を計算し、幾何学的特徴空間(Distg)と動的特徴空間(Distk)を再度比較しました。

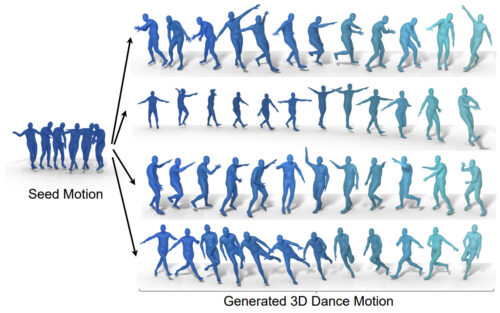

異なる音楽を使用して生成された4つの異なるダンスの振り付け(右)ですが、同じ2秒のシードモーション(左)から生み出されました。条件付けに使う音楽のジャンルは、ブレイク、バレエジャズ、クランピング、ミドルヒップホップです。シードモーションはヒップホップダンスのものです。

(3)モーションと音楽の相関関係

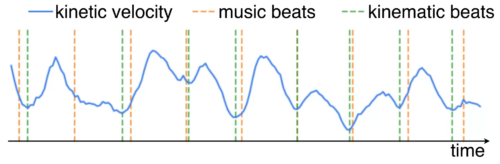

入力音楽(音楽のビート)と生成された3Dモーション(運動学的ビート)の相関関係を測定するための適切に設計された指標は存在しないため、ビートアライメントスコア(BeatAlign)と呼ぶ新しい指標を提案します。

生成されたダンスモーションの運動速度(青い曲線)と運動学的ビート(緑の点線)、および音楽のビート(オレンジ色の点線)。運動学的ビートは、運動速度曲線から極小値を見つけることによって抽出されます。

定量的評価

これらの各指標でのFACTのパフォーマンスを、他の最先端の手法のパフォーマンスと比較しました。

| Motion Quality | Motion Diversity | Motion-Music Corr | |||

| FIDk | FIDg | Distk | Distg | BeatAlign | |

| AIST++ | – | – | 9.057 | 7.556 | 0.292 |

| AIST++(random) | – | – | – | – | 0.213 |

| Li et al. | 86.43 | 20.58 | 6.85* | 4.93 | 0.232 |

| DanceNet | 69.18 | 17.76 | 2.86 | 2.72 | 0.232 |

| DanceRevolution | 73.42 | 31.01 | 3.52 | 2.46 | 0.22 |

| FACT(ours) | 35.35 | 12.4 | 5.94 | 5.3 | 0.241 |

最近、発表された3つの最先端の方法(Li et al、Dancenet、およびDance Revolution)と比較して、FACTモデルは、より現実的で、入力音楽との相関が高く、さまざまな音楽を条件とする場合により多様化するモーションを生成します。*Li et al.が生成するモーションは不連続であり、平均運動特性距離が異常に長くなります。

また、モーションと音楽の相関関係を知覚的に評価するためにユーザ調査を実施しました。各参加者は「FACTによるダンス」と「ランダムに選択した同等のダンス」を映した10本のビデオを見てもらい、音楽とより同期しているダンサーがどちらかを選択して貰いました。ユーザ調査はプロのダンサーからめったに踊らない人々まで、30人の参加者で構成されました。

各比較対象手法と比較した結果、

・81%はLi et al.よりもFACTモデルの出力を好みました。

・71%はDanceNetよりもFACTを好みました。

・77%はDanceRevolutionよりFACTを好みました。

興味深いことに、参加者の75%は、FACTによって生成されたダンスよりも、音楽とペアになっていないAIST++内に収録されているダンスモーションを好みました。AIST++内のオリジナルのダンスは非常に表現力豊かであるため、これは驚くべきことではありません。

定性的結果

DanceNet(左)やLi et.al(中央)のような従来手法との比較

FACTモデル(右)を使用して生成された3Dダンスは、より現実的で、入力音楽との相関性が高くなっています。

FACTモデルを使用して生成された他の3Dダンス

結論と考察

オーディオとモーションの対応を学習できるだけでなく、音楽を条件として高品質な3Dモーションシーケンスを生成できるモデルを紹介しました。音楽から3Dモーションを生成することは初期の研究分野であるため、私たちの作業が将来のクロスモーダルオーディオから3Dモーション生成への道を開くことを願っています。また、これまでで最大の3DヒューマンダンスデータセットであるAIST++もリリースしています。この提案された、マルチビュー、マルチジャンル、クロスモーダルの3Dモーションデータセットは、条件付き3Dモーション生成研究の研究だけでなく、一般的な人間の理解の研究にも役立ちます。GitHubリポジトリとトレーニング済みモデルでコードをリリースしています。

私たちの研究結果は、音楽で調整された3Dモーション生成のこの問題において有望な方向性を示していますが、さらに調査する必要があります。まず、私たちのアプローチは運動学に基づいており、ダンサーと床の間の物理的な相互作用については推論していません。したがって、グローバル変換は、足が滑ったり床から浮いたりするなどの不自然な動作につながる可能性があります。第二に、私たちのモデルは常に確定的に1つのダンスを生成します。音楽ごとに複数種のリアルなダンスを生成する方法を探求することは、エキサイティングな方向性です。

謝辞

RuilongLiやDavidRossを含む他の共著者の貢献に感謝します。

有益な議論をしてくれたChen Sun, Austin Myers, Bryan Seybold, Abhijit Kundu に感謝します。コードを共有してくれたEmre AksanとJiaman Liに感謝します。また、この方向性の初期の試みについてKevin Murphyに感謝し、ユーザー調査実験の支援をしてくれたPeggy ChiとPan Chenにも感謝します。

この研究は、AISTダンスビデオデータベース(https://aistdancedb.ongaaccel.jp)がなければ実現できなかったので、コミュニティへの貴重な貢献をしてくれたクリエイターの皆さんに特に感謝します。

3.AI Choreographer:音楽に合わせたダンスを生成する人工知能(2/2)関連リンク

1)ai.googleblog.com

Music Conditioned 3D Dance Generation with AIST++

2)google.github.io

AIST++ Dance Motion Dataset

AI Choreographer Music Conditioned 3D Dance Generation with AIST++

3)google.github.io

google-research / mint

4)aistdancedb.ongaaccel.jp

AIST Dance Video Database