1.Google翻訳が性別を決めつけてしまう訳を減らす仕組みを拡大まとめ

・Google翻訳は性別固有の表現を持たない言語と持つ言語間で翻訳する際に性別を決めつけてしまう事がある

・2018年12月に「性別固有の翻訳」の仕組みを取り入れたが英語スペイン語間のみにとどまっていた

・従来の仕組みでは対象言語を広げる事が難しかったが新しいリライトベースの手法で対象言語を増やせた

2.Google翻訳の新しいジェンダーバイアス対策

以下、ai.googleblog.comより「A Scalable Approach to Reducing Gender Bias in Google Translate」の意訳です。元記事の投稿は2020年4月22日、Melvin Johnsonさんによる投稿です。

Biasを強調するために選んだアイキャッチ画像はバリ島東部の穴場ビーチであるBias Tugel Beach(別名ホワイトサンドビーチ)でクレジットはPhoto by Alexey Marchenko on Unsplashでオフラインゴールデンウィーク気分をお楽しみください。

言語翻訳用の機械学習(ML:Machine Learning)モデルは、トレーニングデータに反映される社会的な偏見によって歪められる可能性があります。そのような例の1つであるジェンダーバイアス、すなわち性別を決めつけた翻訳を行ってしまう事は、「性別固有の表現を持つ言語」と「それほど固有の表現を持たない言語」との間で翻訳する時に、より明確になることがあります。

例えば、Google翻訳は歴史的に、「彼/彼女は医者です(He/She is a doctor)」をトルコ語に翻訳する際に男性を前提とした文章に翻訳し、「彼/彼女は看護師です(He/She is a nurse)」をトルコ語に翻訳する際は女性を前提とした文に翻訳していました。

2018年12月、GoogleのAI原則に沿って、不当な偏見を作らない、助長しない事の重要性を強調し、「性別固有の翻訳(gender-specific translations)」について発表しました。Google翻訳のこの機能では、性別を問わない文章を翻訳元として翻訳する際、女性と男性のどちらを前提とするかを選ぶ事ができます。

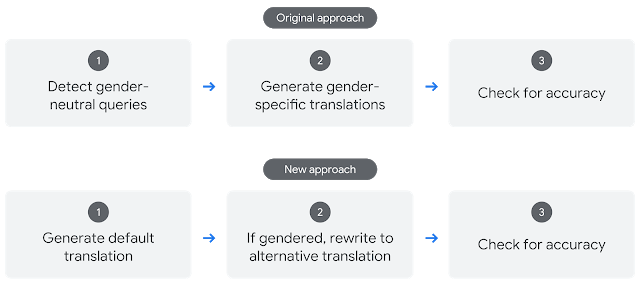

この機能は、「入力文が性別に依存しない文章である事の検出(性別中立性の検出)」、「性別固有の翻訳の生成」、および「正確性のチェック」を含む3ステップのアプローチを開発しました。

このアプローチを使用して、トルコ語から英語へのフレーズと文において「性別固有の翻訳」を可能にし、Google翻訳で最も人気のある翻訳言語ペアである英語からスペイン語への翻訳にこのアプローチを拡張しました。

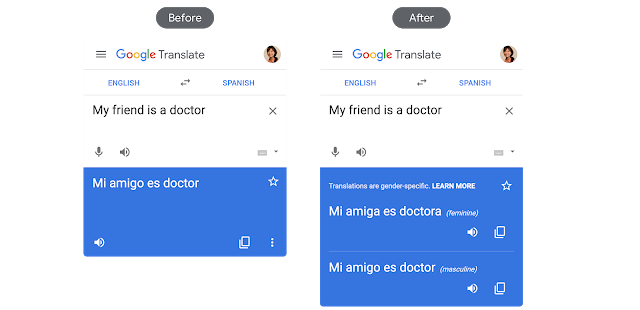

左:性別に中立な英語のフレーズを、性別固有の表現を持つスペイン語に翻訳した昔の翻訳事例。偏った翻訳文のみが示されています。

右:新しい翻訳は、女性と男性の両方の翻訳を提供します。

しかし、このアプローチをより多くの言語に適用しようとしたところ、規模拡大による問題が発生する事が明らかになりました。

具体的には、ニューラル機械翻訳(NMT:Neural Machine Translation)システムを使用して男性前提と女性前提の翻訳文を個別に生成すると、再現率(recall)が低くなります。

多くの場合、性別関連の表現箇所を除いても、2つの翻訳文は完全に同一にはなりませんでした。厳密には、入力文の最大40%は性別固有の翻訳が実現できていません。

更に、翻訳元言語の性別中立性を検出する分類器の性能は学習用データに強く依存しました。

本日、新しい英語からスペイン語への性別固有の翻訳のリリースと共に、劇的に異なるパラダイムを使用して、性別の偏見に対処する改善されたアプローチを発表します。このアプローチは最初に翻訳文を出力し、次にその翻訳文を書き換えたり編集する事で性別の偏見に対処する、リライトベースの手法です。

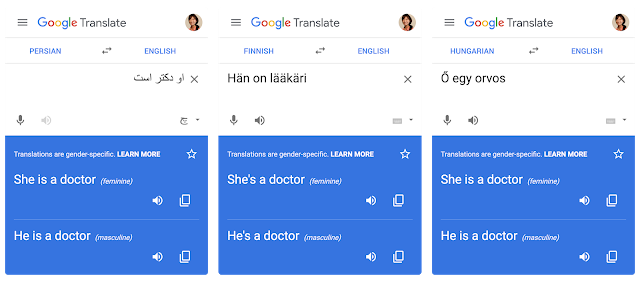

このアプローチは、性別中立性の検出器を必要としないため、特に性別中立な言語から英語に翻訳する場合、従来手法より規模を拡大可能です。新しいアプローチを使用して、性別固有の翻訳の対象言語を拡張し、フィンランド語、ハンガリー語、ペルシャ語から英語に翻訳する事が可能になりました。また、新しいリライトベースの手法を使用して、以前のトルコ語から英語へのシステムを置き換えました。

リライトに基づく性別固有の翻訳

リライトベースの方法の最初のステップは、初期翻訳文を生成することです。次に、初期翻訳文がチェックされ、性別中立の翻訳元フレーズから性別固有の翻訳が生成された箇所があるか特定します。あった場合、文レベルのリライターを適用して、別の性別翻訳を生成します。最後に、初期翻訳とリライトされた翻訳の両方がチェックされ、唯一の違いが性別表記である事を確認します。

上図:従来の性別固有の翻訳アプローチ

下図:新しいリライトベースのアプローチ

リライター

リライターの開発には、男性版と女性版の両方の翻訳を含んだフレーズのペアで構成される数百万のトレーニングデータを生成する作業が含まれていました。そのようなデータですぐに利用できるものがなかったため、この目的のために新しいデータセットを生成しました。

単一言語から構成された大規模なデータセットを元に、性別代名詞を男性から女性、またはその逆に交換することにより、プログラム的に複数の書き換え候補を生成しました。文脈に応じて、複数の有効な書き換え候補が存在する可能性があるためです。

例えば、女性の代名詞「彼女(her)」は「彼を(him)」または「彼は(he)」のどちらにも対応しており、男性の代名詞「彼の(his)」は「彼女は(she)」または「彼女の物(hers)」にマッピングできます。

正しいものを選択するための仕組みが必要でした。

正しい候補を選択するためには、構文解析モデルまたは言語モデルを使用できます。構文解析モデルは、各言語のラベル付きデータセットを使用したトレーニングを必要とするため、教師なしで学習できる言語モデルよりも拡張性が低くなります。そのため、数百万の英文でトレーニングされた内製言語モデルを使用して、最適な候補を選択します。

| 入力 | 拡張 | 出力 |

| I spoke to her. | I spoke to him. I spoke to his. |

I spoke to him. |

| I spoke to her friend. | I spoke to his friend. I spoke to him friend. |

I spoke to his friend. |

| The pen is his. | This pen is her. This pen is hers. |

This pen is hers. |

| This is his pen. | This is hers pen. This is her pen. |

This is her pen. |

この表は、データの生成プロセスを示しています。左から入力文、候補生成、最後に言語モデルを使用して決定した候補

このデータ生成プロセスにより、男性前提な入力文から女性前提な出力、またはその逆のトレーニング用データが生成できます。これらの双方向のデータを使って1層のトランスフォーマーベースのsequence-to-sequenceモデルをトレーニングしました。

モデルの堅牢性を高めるために、トレーニング用データに句読点を加えたり、大文字と小文字を変換を行う事でデータを増やしています。この最終的なモデルは、要求された男性または女性の書き換えを99%の確率で生成できます。

評価

また、新しい翻訳システムと従来の翻訳システムを比較して、どのくらい偏見が削減されたか相対的割合を測定する、バイアス削減(bias reduction)と呼ばれる新しい評価方法を考案しました。

ここで「バイアス」とは、翻訳元文章が指定していない性別を翻訳先文章で選択する事と定義されています。

例えば、従来のシステムが90%の割合でバイアスを出力し、新しいシステムが45%の割合でバイアスを出力する場合、50%の相対的なバイアス削減となります。

この測定基準を使用すると、新しいアプローチにより、ハンガリー語、フィンランド語、ペルシャ語から英語への翻訳ではバイアスが90%以上減少しています。

新しいアプローチにより、従来のトルコ語から英語へのシステムのバイアスは60%から95%に改善されました。 新しいGoogle翻訳は、平均97%の精度(precision)で性別固有の翻訳を検出します。(つまり、性別固有の翻訳を表示する事をGoogle翻訳が決定した場合、97%の確率でそれは適切です)

最初のリリース以来、性別固有の翻訳の品質を高め、さらに4つの言語ペアに拡張することで、大きな進歩を遂げました。Google翻訳では、更なる性別による偏見の改善に取り組んでおり、本手法を文レベルから文章レベルのより長い翻訳にも拡張する予定です。

謝辞

この取り組みは、以下の人々を含む、しかし以下に限定されない多くの人々の努力のおかげで達成されました。(姓のアルファベット順)Anja Austermann, Jennifer Choi, Hossein Emami, Rick Genter, Megan Hancock, Mikio Hirabayashi, Macduff Hughes, Tolga Kayadelen, Mira Keskinen, Michelle Linch, Klaus Macherey, Gergely Morvay, Tetsuji Nakagawa, Thom Nelson, Mengmeng Niu, Jennimaria Palomaki, Alex Rudnick, Apu Shah, Jason Smith, Romina Stella, Vilmos Urban, Colin Young, Angie Whitnah, Pendar Yousefi, Tao Yu。

3.Google翻訳が性別を決めつけてしまう訳を減らす仕組みを拡大関連リンク

1)ai.googleblog.com

A Scalable Approach to Reducing Gender Bias in Google Translate

コメント