1.ロボット工学における進化的メタラーニングの探索(1/3)まとめ

・シミュレーションによりロボットのトレーニングは実現しやすくなったがギャップが存在

・シミュレーション環境と現実世界の間に存在する微妙なギャップで意図した通りに動かない

・進化的戦略に基づくメタラーニングにより脚付き歩行ロボットでこの問題を解決

2.メタラーニングとは?

以下、ai.googleblog.comより「Exploring Evolutionary Meta-Learning in Robotics」の意訳です。元記事の投稿は2020年4月21日、Xingyou (Richard) SongさんとYuxiang Yangさんによる投稿です。

「メタ」とは改めて言葉で説明しようとすると非常に難しい概念ですが、アイキャッチ画像の「「モナリザを撮影している人」を撮影する人」のようなものです。「モナリザを撮影している人」にとっては自分とモナリザが世界の全てですが、その世界を別の一段高い次元から俯瞰する事をメタ視点と言ったりします。

ロボットにとってシミュレーション環境で学習中は、シミュレーション環境が世界の全てです。学習結果を現実世界に持っていく事は学習結果の転移と見なす事もできますが、メタの壁を超える事、すなわち閉じられた世界でのみ通用する「モナリザを撮影する方法」を学ぶのではなく「撮影する方法」を学ぶ、メタラーニングの一種と考える事が出来ると言う視点が今回のお話の出発点です。

アイキャッチ画像はオフラインゴールデンウイーク特集でいつの日か行ってみたいルーヴル美術館のモナリザですが、かなりシビアな展示状況なんですね、Photo by Mika Baumeister on Unsplash

より正確なシミュレータの迅速な開発により、ロボットを操作するために必要な「ロボット用ポリシー(robotic policies)」の学習に使用できる十分な量のデータを生成できるようになりました。

それゆえ、ロボット工学の研究者がロボットを現実世界で使用するためのトレーニングは実現しやすくなりましたが、「現実世界とのギャップ(reality gap)」と呼ばれる問題がまだ残っています。

「トレーニング時に使用したシミュレーション環境」と「ロボットが実際に使用される現実世界の環境」の間に存在する微妙な違いにより、ロボットが意図した通りに動かない事があるのです。

シミュレーション環境でトレーニングしたロボット用ポリシーを「シミュレーション環境から現実世界に適応(sim-to-real adaptation)」することは、現代のロボット工学の最大の課題の1つとなっています。

最近のいくつかのアプローチは、模倣学習(Imitation learning)やオフライン強化学習など、蓄積された過去データを活用して、現実世界とのギャップに適応するポリシーを準備する事を試みています。しかし、より一般的なアプローチは、シミュレーション環境の属性を変化させて、より多くの学習データを提供することです。これは、「domain randomization(環境のランダム化)」と呼ばれる手法です。

ただし、domain randomizationは、安定的な動作を実現するために性能を犠牲にする可能性があります。全てのタスクに対して安全で着実なロボット操作が行われるようにポリシーを最適化する事になるため、特定のタスクのポリシーを改善する余地がほとんどないのです。

例を挙げると、ロボットの歩行タスクを考えてみましょう。床面と脚の摩擦、重心の移動、地形の違いなど、様々な物理的な力が作用するため、これを完全にシミュレーション環境で現実世界と同等に実現する事は困難で、ここにはシミュレーションと現実世界のギャップが存在します。

もし、その他の条件が全く同じで、「平面を歩く事」と「起伏のある面を歩く事」を求められたとしましょう。平面を歩く場合、ロボットはより高速に歩行する事ができますが、起伏のある面を歩く場合は転倒を避けるため、より慎重に歩行する事が求められます。しかし、domain randomization手法を使った場合、平面を歩く場合であっても、非常に慎重な歩行を行う事になります。

論文「Rapidly Adaptable Legged Robots via Evolutionary Meta-Learning」では進化的戦略(ES:Evolutionary Strategies)に基づくメタ学習(meta-learning)の一種を紹介しています。

これにより、シミュレーションでのみうまく機能すると一般的に考えられているポリシーを、完全にモデルフリーな方法で現実世界のロボットに効果的かつ効率的に適応させる事ができます。

メタポリシーを適応させる以前のアプローチには、standard policy gradientsなどがありますが、これはシミュレーション環境から現実世界に適応する事には使えません。

ESを使用すると、ロボットは現実世界とのギャップをすばやく克服し、現実世界の動的な変化にも適応できます。現実世界の動的な変化のいくつかが、シミュレーション環境では発生しない可能性があっても大丈夫です。本研究は、ESを使用してロボットにポリシーを適応させる初めての例です。

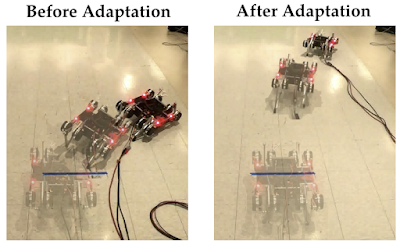

私達のアルゴリズムは、脚付き歩行ロボットの操作ポリシーを環境の変化にすばやく適合させます。この例では、バッテリーの電圧が16.8Vから10Vに低下し、モーターのパワーが減少しました。また、500gの重さがロボットの側面に配置され、ロボットがまっすぐ歩けず回転するようにしました。しかし、ポリシーは、50回のエピソード(または150回の現実世界のデータ)でのみ適応が可能です。

Meta-Learningとは?

本研究はメタラーニングテクニックの一種に分類されるもので、脚式ロボットで実証されました。高次の視点から言えば、メタラーニングは、「過去の経験」と「与えられたタスクに関する少量の経験」を組み合わせることにより、完全に最初から再トレーニングすることなく、「与えられたタスク」をすばやく解決できるようになる事を学習します。

これは、「過去の経験」のほとんどがシミュレーションで簡単に得る事が出来、最小限の、しかし必要な量の経験を現実世界のタスクで補う「シミュレーション環境から現実世界に適応」する問題では特に有益です。

シミュレーションから得た経験により、ポリシーは様々なタスクを解決するための一般的な動作を学習する事が出来、その一方、現実世界から得た経験を使って、具体的な現実世界のタスクに合わせてポリシーを微調整できます。

ポリシーをメタラーニングでトレーニングするためには、シミュレーション中にメタポリシーを捜す必要があります。

通常、これは、「モデルにとらわれないメタラーニング(MAML:Model-Agnostic Meta-Learning)」を使って実現できます。MAMLは、少量のタスク固有データを使用して特定のタスクにすばやく適応できるメタポリシーを捜し出します。

このようなメタポリシーを計算するための標準的なアプローチは、policy gradient methodsです。これは、同じ状態で同じアクションが選択される可能性を高める方法を捜そうとします。

特定のアクションが実行される可能性を判断するためには、ポリシーは確率的でなければなりません。これにより、ポリシーによって選択されたアクションがランダム性を持つ事になります。

ロボットポリシーを展開する現実世界の環境も非常に確率的です。全く同じ状態と同じアクションから開始しても、自然に発生する動きによりわずかな違いが発生する可能性があるからです。

確率的な環境内で確率的なポリシーを使用する際には、2つの相反する目的が生じます。

(1)ポリシーの確率性を下げる事が重要になる場合があります。

そうでなければ、ポリシーのアクションのランダム性によって高ノイズ問題が悪化する可能性があります。

(2)ただし、ポリシーの確率性を高めることは、利益をもたらす可能性もあります。

ポリシーは適応する環境のタイプを調査するためにランダムなアクションを使用する必要があるためです

これらの2つの競合する目的は、ポリシーの確率性を減少および増加させることを目的としており、複雑化を引き起こす可能性があります。

3.ロボット工学における進化的メタラーニングの探索(1/3)関連リンク

1)ai.googleblog.com

Exploring Evolutionary Meta-Learning in Robotics

2)arxiv.org

Rapidly Adaptable Legged Robots via Evolutionary Meta-Learning

3)bair.berkeley.edu

Learning to Learn

コメント