1.AutoFlip:機械学習を用いてビデオの最適な箇所を切り抜く(1/3)まとめ

・テレビやデスクトップパソコン用のビデオはアスペクト比が違うのでモバイルデバイスでの再生に不適

・従来のアスペクト比を修正する手法は固定箇所を切り抜くため重要な箇所が抜け落ちてしまう事がある

・AutoFlipはビデオを分析し、最適な切り抜き箇所を追跡して切り抜くため最適なビデオを自動で再構成可能

2.AutoFlipとは?

以下、ai.googleblog.comより「AutoFlip: An Open Source Framework for Intelligent Video Reframing」の意訳です。元記事の投稿は2020年2月13日、Nathan FreyさんとZheng Sunさんによる投稿です。アイキャッチ画像のクレジットはPhoto by Jakob Owens on Unsplash

2020年12月追記)その他のMediaPipeシリーズのまとめ記事はこちら。

テレビやデスクトップパソコン向けに撮影および編集されたビデオは、通常、横長のアスペクト比(16:9または4:3)で作成および表示されます。ただし、スマホやタブレットなどのモバイルデバイス向けにコンテンツを作成および使用するユーザーが増えているため、このアスペクト比は、動画を映してるディスプレイに必ずしも収まらない場合があります。

ビデオを様々なアスペクト比に再構成する従来のアプローチでは、通常、静的な切り抜き、つまりカメラのビューポート(訳注:描画する画面の大きさと位置)を指定してから、外側の視覚コンテンツを切り抜きます。

残念ながら、これらの固定した場所を切り抜くトリミングアプローチは、様々な構図やカメラの動きによって、思う通りの場所が切り抜けない事がよくあります。 しかしながら、より手間をかけたアプローチでは、通常、ビデオ編集者が各フレームで目立たたせたい顕著なコンテンツを手動で識別し、ビデオ全体を通じてトリミング領域を調整する必要があります。このプロセスは、多くの場合、退屈で時間がかかり、ミスが発生しやすくなります。

この問題に対処するため、インテリジェントビデオリフレーミング用のオープンソースフレームワークであるAutoFlipを発表します。 AutoFlipは、時系列マルチモーダルデータを処理するためのパイプラインの開発を可能にするMediaPipeフレームワークの上に構築されています。

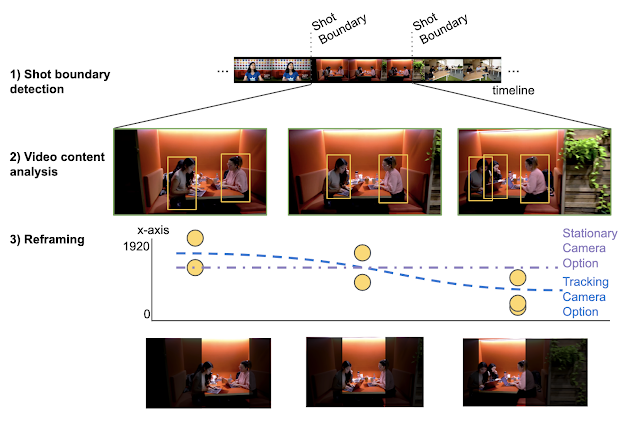

ビデオ(カジュアルに撮影されたビデオからプロが編集したビデオまで)と標的範囲(風景、矩形、ポートレートなど)入力に与えると、AutoFlipはビデオコンテンツを分析し、最適な切り抜き部分を追跡する、トラッキングおよびトリミング戦略を実行し、目的のアスペクト比で同じ長さのビデオを生成して出力します。

左:元のビデオ(16:9)

中央:標準的な中央部分を固定した切り抜き(9:16)

右:AutoFlipで作成したリフレーム(9:16)。関心のある被写体を検出することにより、AutoFlipは視覚的コンテンツの重要な箇所が抜け落ちてしまう事を回避します。

オートフリップの概要

AutoFlipは、スマートにビデオの再フレーミングを行う完全自動のソリューションを提供します。最先端の機械学習による物体検出および追跡テクノロジーを使用して、ビデオコンテンツを知的に理解する事でこれを実現しています。

AutoFlipは、撮影場面が変更した事を示すコンポジション(画面構成)の変更を検出します。これにより、撮影場面の変更に伴って切り抜く場所を変更する事ができます。各ショット内でビデオを分析し、写っている内容に最適化したカメラモードとパスを選択することにより、着目すべきコンテンツを識別して、最適な箇所を切り抜くのです。

3.AutoFlip:機械学習を用いてビデオの最適な箇所を切り抜く(1/3)関連リンク

1)ai.googleblog.com

AutoFlip: An Open Source Framework for Intelligent Video Reframing

2)github.com

mediapipe/mediapipe/docs/autoflip.md

コメント