1.Fairness Indicator:公正な機械学習を構築するためのツール(2/3)まとめ

・Fairness Indicatorsを使用すると公平性基準の計算と視覚化が可能になり、独自の基準を追加する事も可能

・Fairness IndicatorsはWhat-If toolと統合されており問題がありそうなデータスライスを事前に特定可能

・公平性の概念は状況や場面に依存するため様々なケーススタディや事例も提供されている

2.Fairness Indicatorsとは?

以下、ai.googleblog.comより「Fairness Indicators: Scalable Infrastructure for Fair ML Systems」の意訳です。元記事の投稿は2019年12月11日、Catherina XuさんとTulsee Doshiさんによる投稿です。

Fairness Indicatorsツールの一覧

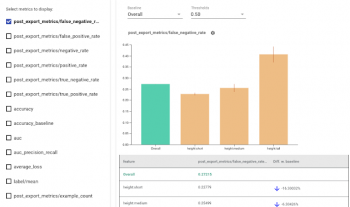

Fairness Indicatorsツールを使用すると、分類モデルの識別結果に良く使われる公平性基準の計算と視覚化が可能になります。

例えば、偽陽性率や偽陰性率など、スライス(訳注:スライスチーズのスライス、「薄く切る」の意味で、データを色々な切り口で分割する事を意味しています)したデータ全体、または基準となるスライスとのパフォーマンスを簡単に比較できます。

このツールは、統計的に有意な不均衡を明らかにする可能性のある信頼区間を計算し、複数のしきい値にわたって評価する事ができます。基準とするスライスを自由に切り替えて、他の基準を用いて様々なパフォーマンスも検証できます。ユーザーは、ユーザ独自のユースケース用に視覚化を行うために独自の基準を追加することもできます。

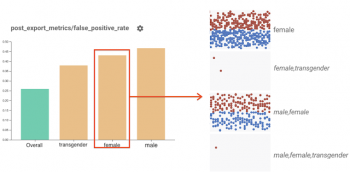

更に、Fairness IndicatorsはWhat-If tool(WIT)と統合されています。Fairness Indicatorsグラフ上のバーをクリックすると、これらの特定のデータポイントがWITに読み込まれ、さらに検査、比較、反事実分析(counterfactual analysis)が行われます。

これは、大規模なデータセットで特に役立ちます。WITを使用して詳細な分析を行う前に、Fairness Indicatorsを使用してデータのどの部分に問題があるか特定できるためです。

Fairness Indicatorを使用して、公平性の評価を視覚化します。

Fairness Indicators上のスライスをクリックすると、What-If Tool内のそのスライス内の全てのデータポイントが読み込まれます。 上記の例では、「female」ラベルの付いたすべてのデータポイントが表示されます。

Fairness Indicatorsツールのベータ版には次のものが含まれます。

Pythonのパッケージ管理ツールであるpipによって提供される以下のパッケージ

1.Tensorflow Model Analysis(TFMA)、Fairness Indicators、Tensorflow Data Validation(TFDV)、What-If Tool、およびColabsで書かれた以下のサンプルが含まれています。

1)Fairness Indicatorsのサンプル

Fairness Indicatorsの使用法の紹介

2)TensorBoardでのFairness Indicators

TensorBoardプラグインとしての使い方

3)TFHubのEmbeddingsとFairness Indicators

下流タスクの公平性基準に対して様々なEmbeddingsがどのように影響を調査する事例

4)Cloud Vision APIの顔検出モデルとFairness Indicators

モデルカードに記載するモデルの評価結果を生成するためにFairness Indicatorsを使用する事例

2.GitHubリポジトリ

GitHubでソースコードが公開されています。

3.使用法のガイダンス

公平性の概念は状況や場面に依存するため、各ユースケースとユーザーへの潜在的な影響を慎重に検討することが重要です。このドキュメントでは、グループと基準を選択するためのガイダンスを提供し、評価のベストプラクティスを示しています。

4.ケーススタディ

Fairness Indicatorsの使用に関するインタラクティブなケーススタディ。JigsawのConversation AI teamが、Toxic Comment Classificationデータセットを使用して分類モデルのバイアスをどのように検出するかを示します。

3.Fairness Indicator:公正な機械学習を構築するためのツール(2/3)関連リンク

1)ai.googleblog.com

Fairness Indicators: Scalable Infrastructure for Fair ML Systems

2)www.kaggle.com

Jigsaw Unintended Bias in Toxicity Classification

3)modelcards.withgoogle.com

Model Cards

4)github.com

tensorflow/fairness-indicators

5)developers.google.com

ML Practicum: Fairness in Perspective API

コメント