1.Fairness Indicator:公正な機械学習を構築するためのツール(1/3)まとめ

・機械学習は不公平な偏見(バイアス)を反映または強化してしまう危険性がある

・GoogleがAI開発時の原則としてかかげるAI principlesではバイアスを避ける事を第二原則としている

・この度、公平性を検証するツールであるフェアネスインジケーターのベータ版をリリースした

2.機械学習の公平性とは?

以下、ai.googleblog.comより「Fairness Indicators: Scalable Infrastructure for Fair ML Systems」の意訳です。元記事の投稿は2019年12月11日、Catherina XuさんとTulsee Doshiさんによる投稿です。

産業界と学術界は、機械学習(ML)を使用してより良い製品を作成したり、重要な問題に取り組む事を探求し続けていますが、アルゴリズムとそれらを訓練する際に使われるデータセットには、不公平な偏見(バイアス)を反映または強化してしまう恐れがあります。例えば、不正コメント監視システムが特定グループが書き込んだ害のないコメントを「迷惑コメント」または「有害コメント」として誤って認識をしてしまうと、以降の会話からそれらのグループは除外されてしまいます。

2018年、GoogleはAIを使用して製品をより便利にしていく際に守る原則としてAI principlesを共有しました。2番目の原則「不公平なバイアスの作成または強化を回避する」は、不当なバイアスを減らし、人々への影響を最小限に抑えるというコミットメントの概要を示しています。

このコミットメントの一環として、10月に開催したイベントTensorFlow Worldで、フェアネスインジケーターのベータ版をリリースしました。これは、バイナリおよびマルチクラス分類に対する公平性基準を定常的に計算し、視覚化するためのツール群で、開発チームが不公正なバイアスを特定するための第一歩を踏み出すためのに役立ちます

フェアネスインジケータを使用すると、透明性基準レポートを生成します。これにより、開発者がモデルを責任を持って展開する方法についてより良い判断を下せるようにすることが可能になります。これらの情報はモデルカードに使われるデータのようなものです。

訳注:モデルカードとは、食品や工業製品には賞味期限等の注意書きや成分表ラベルが貼ってありますが、機械学習モデルも同様にラベルを張るべきではないかとGoogleが提唱している仕様の事で、機械学習モデルの成分表のようなものです。

公平性に関する懸念と評価ポイントはケースごとに異なります。

このリリースには、「Jigsaw’s Unintended Bias in Toxicity dataset」を使って意図しないバイアスをインタラクティブに検出するケーススタディも含まれており、どのように製品展開するかに応じて変化する機械学習モデルの偏りを検出および修正するためにフェアネスインジケータを使用する方法を示しています。

フェアネスインジケータは、ベータ版として利用可能であり、あなた独自のユースケースを試すことができます。

機械学習の公平性とは?

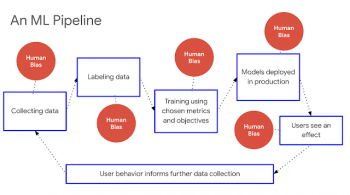

バイアスは、典型的な機械学習パイプラインのどの部分にも現れます。

データセットそのものに偏りが存在するケースから、結果をユーザーに表示する際に出現するケースまであらゆる場面です。これらのバイアスに起因するエラーは、一部のユーザーに他のユーザーと比べて不均衡な影響を与える可能性があります。

この不均衡な影響を検出するには、個々のデータを細かく分割したり、ユーザーをグループにわけて評価してみる事が重要です。これは、全体のパフォーマンスだけを見ていると特定グループに対するパフォーマンスの低下が見えなくなる可能性があるためです。これらのグループ分けには、人種、民族、性別、国籍、収入、性的指向、能力、宗教的信念などの取り扱いに注意が必要な個人特性によって定義されるグループが含まれますが、これらに限定されません。

しかしながら、測定基準を測定するだけでは公平性を達成できないことにも留意してください。分割したデータを用いた評価がそれぞれ高性能であっても、システムが公平であるとは限りません。むしろ、この評価は、特に分類モデルのパフォーマンスにギャップがないかを識別するための、最初に確かめる事の1つと見なすべきです。

3.Fairness Indicator:公正な機械学習を構築するためのツール(1/3)関連リンク

1)ai.googleblog.com

Fairness Indicators: Scalable Infrastructure for Fair ML Systems

2)www.kaggle.com

Jigsaw Unintended Bias in Toxicity Classification

3)modelcards.withgoogle.com

Model Cards

コメント