1.Live Caption:オンデバイスで音声コンテンツに字幕を付与(1/2)まとめ

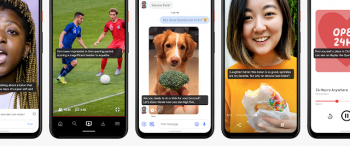

・音声コンテンツに字幕を付ける新しいAndroidの機能、Live Captionが発表された

・現在Pixel 4およびPixel 4 XLで利用可能、今後順次Pixel 3や他のAndroidデバイスでも利用可能になる予定

・メディアの再生中にボリュームコントロールをシングルタップするとLive Captionを起動可能

2.Live Captionとは?

以下、ai.googleblog.comより「On-Device Captioning with Live Caption」の意訳です。元記事の投稿は2019年10月29日、Michelle Tadmor-RamanovichさんとNadav Barさんによる投稿です。

音声コンテンツに字幕(キャプション)を付ける事は、聴覚に困難を抱える人にとって非常に重要ですが、誰にとっても有益です。

電車内、会議中、ベッド内、子供が寝ているときなど、音声なしでビデオを見るのが一般的です。 また、研究により、字幕を使用すると、ユーザーが動画を見る時間を約40%延ばせる事が示されています。 ただし、キャプションのサポートはアプリ間やアプリ内でも断片的に実装されているため、ライブブログ、ポッドキャスト、パーソナルビデオ、オーディオメッセージ、ソーシャルメディアなど、字幕によるアクセスができないオーディオコンテンツが大量に残っています。

先日、Live Captionを発表しました。これは、スマートフォンで再生するメディアに自動的にキャプションを付ける新しいAndroidの機能です。キャプションを付ける作業は、ネットワークリソースを使用せずに、完全にオンデバイスでリアルタイムに行われるため、プライバシーが保持され、応答時間が短縮されます。この機能は現在Pixel 4およびPixel 4 XLで利用可能で、今年後半にPixel 3モデルに展開され、間もなく他のAndroidデバイスでより広く利用できるようになります。

メディアの再生中に、ボリュームコントロールをシングルタップするとLive Captionを起動して、画面にキャプションを表示できます。

正確さと効率を重視したLive Captionの開発

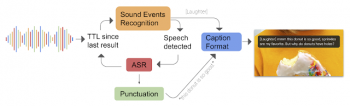

ライブキャプションは、デバイス上の3つのディープラーニングモデルを組み合わせて機能します。

1)音声認識のためのリカレントニューラルネットワークシーケンス変換モデル(RNN-T)

2)暗黙の句読点のためのテキストベースのリカレントニューラルネットワークモデル(RNN)

3)音声イベント検出のための畳み込みニューラルネットワークモデル(CNN)

Live Captionは3つのモデルからの信号を統合して、[APPLAUSE(拍手)]や[MUSIC(音楽)]などのサウンドイベントタグで音声認識が中断しないように単一のキャプションを作成します。句読点記号は予測されますが、文章は同時並行して更新されます。

入力音声は、音声認識とASRによるフィードバックループを介して処理されます。生成されたテキストまたは音声ラベルは整形され、キャプションに追加されます。

3.Live Caption:オンデバイスで音声コンテンツに字幕を付与(1/2)関連リンク

1)ai.googleblog.com

On-Device Captioning with Live Caption

コメント